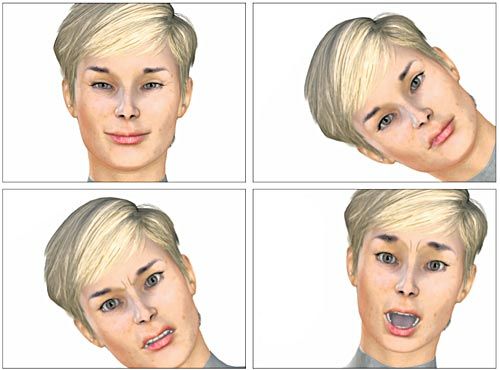

Avatare können mittels Kontrollsoftware Gefühle zeigen. In diesen Fällen sind das: Glück, Verachtung, Wut und Furcht (von links oben im Uhrzeigersinn). Davor wurde mithilfe eines Codierungssystems jede Muskelbewegung im Gesicht einer Emotion zugeordnet.

..., wodurch sich einige Anwendungen, etwa in der Medizin, ergeben.

* * *

Als der amerikanische Gast nachts durch die Räume des Wiener Departments für Anthropologie in der Althanstraße ging, blieb ihm beinahe das Herz stehen. Aus einem Zimmer hörte er eine Stimme, die genervt forderte: "Spiel mit mir". Max, ein von der Universität Bielefeld für die Kommunikation im virtuellen Raum entwickelter Avatar, war für Tests in Wien und eingeschaltet geblieben - und weil niemand mit ihm kommunizierte, war diesem Computermenschen ziemlich langweilig geworden. Heute steht Max im Heinz-Nixdorf-Forum in Paderborn, erklärt staunenden Besuchern die Computerausstellung und verwickelt sie in Gespräche.

Eine Geschichte, die Karl Grammer ganz gern erzählt, wenn - wieder einmal - ein Journalist Fragen nach dem Avatar mit Emotionen stellt. Seit Mitte der 1990er-Jahre beschäftigt sich der Verhaltensforscher und Evolutionsbiologe mit künstlicher Intelligenz und der Möglichkeit, sie mittels Software dem Menschen so ähnlich wie nur möglich zu machen. Er entwickelte mit einem Team ein Programm für die Gefühlsregungen der Avatare, gründete ein eigenes Unternehmen namens Digital Mankind, weil er von zahlreichen Anwendungsmöglichkeiten der Software überzeugt war, liquidierte sie wieder, "weil die Zeit noch nicht reif war dafür", und erlebt nun für diese Ideen einen neuen Boom und mehr Nachfrage denn je. Grammer und sein Team gingen bei der Arbeit wie jeder Verhaltensforscher von sechs Basisemotionen beim Menschen aus: Freude, Überraschung, Wut, Furcht, Trauer und Ekel.

Die Frage, die bei der Entwicklung der Software wichtig war: Welcher Gesichtsmuskel wird bei welchem Gefühl bewegt? Das "facial action coding system" (Gesichtsbewegungskodierungssystem), Mitte der 1970er-Jahre entstanden, gibt da eindeutige Antworten. Mit seiner Hilfe kann man in der Verhaltenspsychologie ein echtes von einem zynischen Lächeln, freudiges von ängstlichem Staunen unterscheiden. Kein Schauspieler kann das annähernd präzise darstellen, weil sein Spiel immer nur seiner Vorstellung von einem bestimmten Gefühl entspricht. Der Grund: Im "facial action coding system" sind bestimmte Emotionen bestimmten Muskelkontraktionen zugeordnet. Ein Psychologe nannte das vor 35 Jahren das "Formelbuch der Gefühlswelt". Bei der Erstellung der Kontrollsoftware waren aber nicht nur die Basisemotionen des Menschen wichtig: Um einen Avatar mit Gefühlen auszustatten, muss man ihn auch mit der zur Emotion passenden Körperhaltung und mit kaum merkbaren winzigen Gesichtsausdrücken versorgen, die Forscher als "micro expressions" bezeichnen.

Ehrliches Lächeln

Was den modernen Avatar von der nur menschenähnlichen Computeranimation herkömmlicher Art unterscheiden sollte, ist aber vor allem die Dynamik der Muskelbewegungen, die Menschen steuern können. Diese kann beim selben Muskel völlig unterschiedlich sein und damit auch unterschiedliche Gefühle vermitteln. Zieht jemand beim Lächeln die Mundwinkel rasch in die Höhe, dann handelt es sich vermutlich um ein zynisches Lächeln, macht er das langsam, dann liegt der Schluss nahe, dass es der, der lächelt, auch wirklich ehrlich meint. Das so entwickelte Emotionskostüm wurde bereits für medizinische Zwecke am AKH getestet. Patienten mit Asperger-Syndrom, die nicht imstande sind, nonverbale Kommunikation wahrzunehmen, wurden mittels funktioneller Magnetresonanztomografie (FMRI) beim Umgang mit den Computergesichtern getestet. Sie zeigten positive Reaktionen. Sogar autistische Kinder können emotionales Feedback annehmen, was ihnen in der Regel besonders schwerfällt. Manche von ihnen verstecken sich unter einem Tisch, wenn es darum geht, ihnen zu erklären, was sie richtig oder falsch machen.

Die Emotionenkontrollsoftware aus Wien wird mittlerweile auch fernab der Wissenschaft in einem Bereich angewandt, in dem man Verhaltensforschung vielleicht nicht vermuten würde: Global Emotion, ein in Deutschland ansässiges Netzwerk von IT- und Businessexperten, setzt gefühlvolle Avatare für Trainingsprogramme ein, die dann so vielsagende Namen wie Getting Flirty tragen.

Geschäftsleute können so lernen, kaum sichtbare Gesichtsausdrücke beim Gegenüber im Meeting zu deuten. Im interkulturellen Training wird man darüber hinaus auf Gespräche mit Menschen vorbereitet, die aus einem ganz anderen Kulturkreis kommen und ihre Emotionen vielleicht gar nicht oder nur sehr verhalten zeigen. Unter den Kunden sind Unternehmen, die mit China ins Geschäft kommen wollen.

Die verstärkte Nachfrage nach Avataren macht die Anthropologen nun auch mutiger, was die nächsten wissenschaftlichen Herausforderungen betrifft: In einem der jüngsten Projekte wird den Computermenschen das Übersetzen von Text in Gebärdensprache beigebracht. Kooperationspartner sind Sign Time TV, ein Internet-Sender, der Nachrichten in österreichischer Gebärdensprache bringt, und das Wiener Unternehmen Lemonaut, das sich auf Computeranimationen spezialisiert hat. "Sehr schwierig, aber wir wissen schon den Dreh, wie es funktionieren könnte," sagt Grammer.

Was kommt als nächster Schritt? Wer an Hollywood-Geschichten über vollkommene menschliche Abbilder im virtuellen Raum denkt, die als Alter Ego leben und Befehle ausführen, wird bei Grammer enttäuscht. Er hat keine entsprechenden Visionen. Für ihn ist der Avatar nur eine ideale Möglichkeit, noch mehr über Verhaltensmuster des Vorbilds zu erfahren, wie es interagiert und wie es reagiert. Und das ist immer noch der Mensch selbst.(Peter Illetschko /DER STANDARD, Printausgabe, 17.11.2010)