Erst vor wenigen Wochen hat Online-Riese Google seine Deep Learning-Engine "Tensor Flow" zu Open Source erklärt und große Teile dementsprechend als Quellcode zur Verfügung gestellt. Nuin folgt ein anderer bedeutender Internetkonzern nach: Facebook.

Dort hat man unter dem Namen "Big Sur" einen eigenen Rechner entwickelt, der besonders effizient darin sein soll, digitale neuronale Netzwerke zu trainieren. Auch dieser wird nun Open Source.

Doppelt so schnell wie der Vorgänger

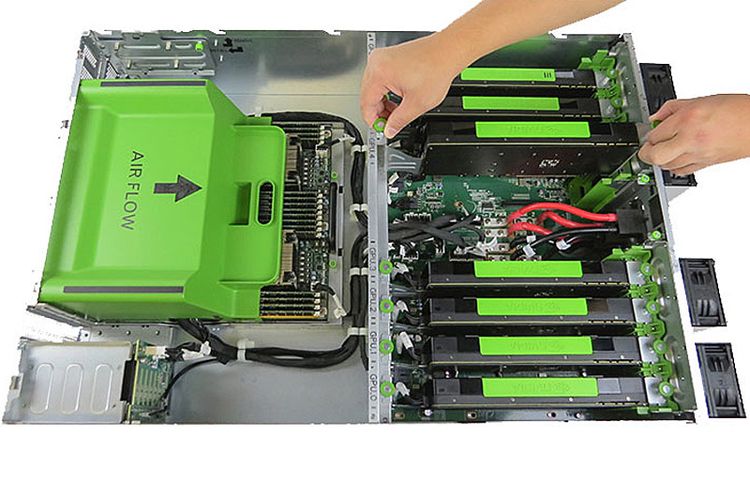

Insgesamt acht Grafikplatinen stecken im Gehäuse der von Außen unscheinbaren Maschine, deren Energieverbrauch bei lediglich 300 Watt liegt. Allerdings nicht weil Facebook damit besonders anspruchsvolle Grafikanwendungen betreiben möchte, sondern weil Grafikprozessoren für Deep Learning-Aufgaben viel besser geeignet sind, als herkömmliche Prozessoren. Letztere kommen ergänzend aber ebenso zum Einsatz.

Hergestellt hat Facebook Big Sur gemeinsam mit dem taiwanischen Fertiger Quanta und den GPU-Experten von Nvidia. 18 Monate dauerte die Entwicklung, und sie hat sich ausgezahlt. Laut Facebook ist der Deep-Learning-Rechner doppelt so flott wie das zuvor verwendete System – kann also in der gleichen Zeit zweimal so viele neurale Netzwerke trainieren oder Netzwerke, die doppelt so groß sind.

Lernen durch Daten

Facebook kann seine künstliche Intelligenz auf diesem Wege in höherem Tempo weiterentwickeln. Zum Einsatz kommt die Technologie etwa bei "M", dem digitalen Assistenten, der sich aktuell noch in der Testphase befindet, sowie bei Mechanismen wie der Gesichtserkennung auf Fotos, die Nutzer beim sozialen Netzwerk einstellen.

Je mehr Daten man einspeist, desto intelligenter wird der Algorithmus, der etwa durch zahlreiche Bilder von Hunden lernen kann, Hunde verschiedener Rassen auf Fotos korrekt zu erkennen.

Offenlegung im Eigeninteresse

Dass man nun das Design von Big Sur offenlegt, geschieht allerdings nicht aus reiner Großzügigkeit, erklärt "Wired". Deep Learning ist ein relativ junges Betätigungsfeld, die Anzahl der Experten in dem Bereich ist überschaubar, die Konkurrenz beim Rekrutieren selbiger entsprechend groß.

Mit diesem Schritt zeigt man einerseits das eigene Bemühen und erwirbt Anerkennung in der Community. Gleichzeitig beschleunigt man die Entwicklung, in dem künftig viel mehr Fachleute Zugang haben und ihre Expertise einbringen. Zudem besteht die Chance, dass auch andere Unternehmen solche Rechner betreiben wollen, was durch ein höheres Produktionsvolumen den Fertigungspreis drücken kann.

Das wiederum kann das System für mehr Firmen attraktiver machen, wodurch mehr Erkenntnisse in die Forschung an künstlicher Intelligenz einfließen können und die Entwicklung insgesamt profitiert, sowohl im Hardware- als auch im Softwarebereich. Dass Facebook seine Geheimnisse teilt, ist also auch ein Schritt, um mit Google und Co Schritt zu halten. (gpi, 11.12.2015)