Man stelle sich zwei Videos vor: In einem singen hochrangige Regierungsmitglieder ein Nazi-Lied. Ihre Gesichter, ihre Stimmen wirken komplett authentisch. In dem anderen Video, das offenbar heimlich aufgenommen wurde, scherzt ein sozialdemokratischer Parteichef herablassend über arme Mitbürger. Auch da: Mimik, Gestik und Stimme wirken real. Beide Videos hätten das Potenzial, die heimische Innenpolitik auf den Kopf zu stellen – und in naher Zukunft soll die Fälschung derartiger Clips mühelos möglich sein.

Obama-Deepfake

Das illustriert ein aktuelles Video, in dem der ehemalige US-Präsident Barack Obama etwa sagt: "Präsident Trump ist ein totaler, kompletter Vollidiot." Der "Deepfake", ein täuschend echt aussehendes, mithilfe von künstlicher Intelligenz gefälschtes Video, wurde von "Buzzfeed" und dem Schauspieler Jordan Peele geschaffen, um die Problematik darzustellen. "Das ist eine gefährliche Zeit. Künftig müssen wir bei den Dingen aus dem Internet, denen wir vertrauen, wachsam sein", sagt er in einer ähnlichen Stimme wie jene des US-Demokraten, während ein Fake-Obama seine Lippenbewegungen imitiert.

"Informationsapokalypse"

"Wir sind hoffnungslos aufgeschmissen, und je weiter man in die Zukunft blickt, desto schlimmer wird es", warnte der Technologieforscher Aviv Ovadya vor kurzem. Er war einer der Ersten, die Mitte 2016 vor einer Welle an Fake-News warnten. Doch die gefälschten Zeitungsartikel und angeblich unterdrückten Bilder waren nur der Anfang, sagt Ovadya zu "Buzzfeed". Aus den Fake-News werden in Kürze Deepfake-News, die zu einer "Informationsapokalypse" führen werden.

Nicht der erste Obama-Fake

Forscher der University of Washington zeigten bereits im vergangenen Jahr anhand eines gefälschten Obama-Videos, wie leicht Computerprogramme Zielpersonen Wörter in den Mund legen können. Die Informatiker verwendet dafür anfangs frühere Interviewausschnitte Obamas, dann griffen sie auf einen Stimmenimitator zurück. Die Resultate wirkten verblüffend echt – und inspirierten auch das "Buzzfeed"-Video, das von Peele moderiert wird.

Relativ bald gelangten auch Internetnutzer an eine Software, die es erlaubt, Deepfakes mithilfe von künstlicher Intelligenz zu schaffen, und nutzten diese, um Fake-Pornos von Prominenten zu erstellen. Große Plattformen wie Reddit und Pornhub mussten entsprechende Videos sperren.

Warnung

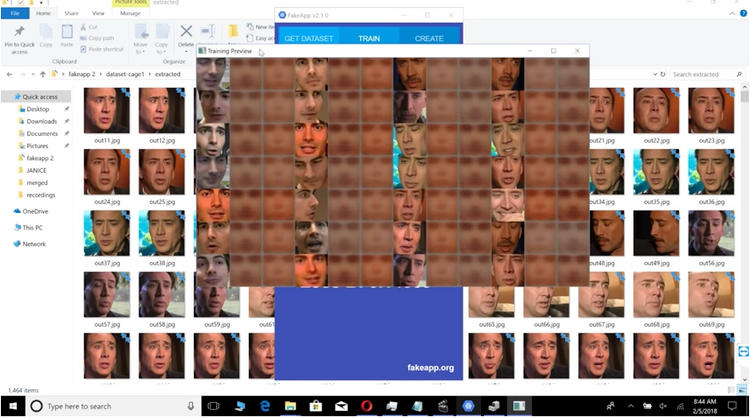

Möglich waren die Deepfake-Pornos und das Obama-Video von "Buzzfeed" wegen der sogenannten Fake App, die mit Googles Open-Source-Programmbibliothek für künstliche Intelligenz, Tensor Flow, operiert und Adobe After Effects. Beides sind Tools, auf die die breite Masse Zugriff hat. Nur beim Ton musste Peele noch mit seiner Obama-Nachahmung nachhelfen.

Perfekte Fälschung

Das alles ist nur der Beginn. Denn bald könnten unterschiedliche technologische Neuerungen ineinanderfließen, um den perfekten Fake zu produzieren. Adobe arbeitet etwa an "Voco", einem "Photoshop für Audio". Dieser könnte genutzt werden, um die passende Tonspur zu einem gefälschten Video zu produzieren. Gefälschte Clips vermeintlicher Reden von US-Präsident Donald Trump oder dem nordkoreanischen Diktator Kim Jong-un sind in Kürze kein Problem mehr.

Man stelle sich vor, was passiert, wenn diese Videos im Netz landen und sich dort in Windeseile verbreiten. Sicherheitsforscher haben für derartige Vorfälle schon einen Namen: "diplomacy manipulation". Dabei will ein "negativer Akteur" geopolitische Ereignisse fälschen, um bestimmte Ziele zu erreichen.

Sprachassistenten treiben an

Durch den aktuellen Hype um digitale Sprachassistenten entwickeln sich künstliche Stimmen immer rasanter weiter, um einen natürlicheren Umgang zwischen Mensch und Maschine zu ermöglichen. Adobe versprach bei einer Vorstellung von Voco, dass das Unternehmen auch daran forsche, wie man unechte Aufnahmen erkennt.

Bots

Ein anderes Szenario sind "sachpolitische Simulationen". Denn nicht nur Fälschungstools für Audio und Video werden besser, sondern auch sogenannte Bots, also automatisch agierende Fake-Profile in sozialen Medien. Vor allem im US-Präsidentschaftswahlkampf bewiesen russische Bots, welches negative Potenzial sie aufweisen.

Sie können den Eindruck erwecken, dass bestimmte Stimmungen im Land vorherrschen, woraufhin Politiker ihre Positionen adaptieren. Bislang sind Bots aber mit etwas Mühe identifizierbar, etwa durch ihre Sprache oder ihren unglaubwürdigen Themenmix. Mit Fortschritten im Bereich der künstlichen Intelligenz könnten echte Wählerschaft und Fake-Profile jedoch kaum mehr unterscheidbar sein. Grassroot-Kampagnen – etwa für Volksbegehren – könnten so ihren Wert verlieren, da Manipulationen nicht mehr erkennbar sind.

Laser Phishing

Im Sicherheitsbereich bereitet Laser Phishing Forschern Kopfzerbrechen. So bezeichnet man mittels künstlicher Intelligenz maßgeschneiderte "Lock"-E-Mails, die Nutzer zum Verraten ihrer Passwörter oder anderer wichtiger Daten verführen sollen. Computerprogramme könnten bald in der Lage sein, soziale Medien automatisiert nach Informationen über Personen abzugrasen, um diesen dann eine zielgenau entworfene Fake-Nachricht zukommen zu lassen. Das könnte auch genutzt werden, um rasch Gerüchte zu verbreiten.

Nichts ist echt

Langfristig könnten derartige Propagandawerkzeuge dazu führen, dass Menschen gar keinen Nachrichten mehr vertrauen, befürchtet Ovadya. Denn auch "echte" Videos und Tonspuren könnten mit Verweis auf die Omnipräsenz von Fakes vom Tisch gewischt werden. So behauptete Donald Trump vor einigen Monaten, der berüchtigte "Access Hollywood"-Videoclip, in dem er sich sexistisch äußert, sei digital manipuliert worden.

Ovayda ruft Technologiekonzerne dazu auf, möglichst rasch funktionierende Tools zu entwickeln, um Fälschungen zu identifizieren. Möglichkeiten, um den echten Ursprung eines Bildes zu beweisen, wären etwa kryptografische Anwendungen wie die Blockchain. Außerdem könnten Lokalmedien, die vor Ort berichten, an Bedeutung gewinnen. (Fabian Schmid, Muzayen Al-Youssef, 13.5.2018)