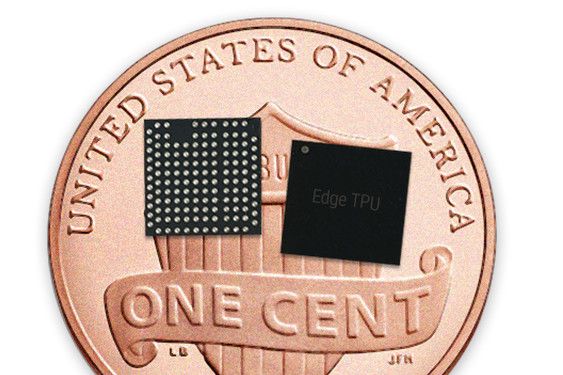

Zum Größenvergleich: Die Edge TPU auf einem Penny.

Vor zwei Jahren hat Google unter dem Namen Tensor Processing Unit die erste Generation von speziell auf Maschinenlernaufgaben optimierten Prozessoren vorgestellt. Mittlerweile sind die für den Cloud-Einsatz gedachten TPUs in ihrer dritten Generation angekommen, während Google sich zunehmend auch anderen Kategorien widmet.

Edge TPU

Unter dem Namen Edge TPU hat Google nun einen kleinen Chip zur Beschleunigung für KI-Aufgaben vorgestellt. Auch wenn es von der Größe her durchaus passen würde, ist der Chip nicht für Smartphones gedacht, sondern soll vor allem im industriellen Bereich seinen Einsatz finden. So könnte er etwa für Qualitätskontrollen in der Fertigung verwendet werden, betont Google.

Lokale Ausführung

Solch spezialisierte Chips eröffnen komplett neue Möglichkeiten für neuronale Netzwerke. Ermöglichen sie doch Maschinenlernaufgaben direkt am Gerät durchzuführen, was nicht nur aus eine Privatsphärenperspektive besser ist, sondern auch erheblich flotter sein kann, da sämtliche Netzwerkzugriffe entfallen. Für größere Berechnungen kann dann im von Google beworbenen Modell noch immer auf Cloud TPUs zurückgegriffen werden. Als Software für die Edge TPU-Nutzung verweist das Unternehmen auf das eigene Tensorflow Lite.

DevKit

Google bietet Interessenten ein Development Kit an, das ein vollständiges System-on-Module (SOM) darstellt. Darauf enthalten ist neben der Edge TPU auch eine CPU von NXP sowie Secure Element zur Absicherung und WLAN-Support. Die Verbindung nach außen wird via USB oder PCI Express hergestellt. Wer solch ein Development Kit haben will, kann sich bei Google dafür voranmelden. (26.7.2018)