Es vergeht kaum ein Tag, ohne neue Schreckensszenarien über die zunehmende Artificial Intelligence (AI) zu hören: Übernahme durch AI, selbst agierende Killerroboter, selbstentscheidende medizinische Systeme, die im Stande sind Leben auszulöschen. Es können alle beruhigt sein – so weit wird es wahrscheinlich nicht kommen, denn bevor wir Killerroboter entwickeln, wird uns wahrscheinlich der Strom ausgehen. Warum der zunehmende Stromverbrauch in der IT zu einem echten Problem werden kann, ist außerhalb von ausgewählten Wissenschaftskreisen wenig bekannt. Wahrscheinlich ist dieses Thema auch nicht so hollywoodreif wie Killerroboter.

Bild nicht mehr verfügbar.

In der Geschichte der Informationsverarbeitung hatten wir mehrere Wendepunkte, zum Beispiel die Erfindung des Desktop-Computers oder die Erfindung des Smartphones. Alle diese Wendepunkte haben eines gemeinsam, nämlich den enormen Anstieg des Energieverbrauchs. Der größte Wendepunkt – die digitale Transformation – steht uns noch bevor.

IT und der grüne Strom

Alleine Google verbraucht im Jahr so viel Strom wie ungefähr die gesamte Stadt Graz. Derzeit gibt es weltweit circa eine halbe Million Rechenzentren, die insgesamt so viel Strom im Jahr verbrauchen wie fast 30 Atomkraftwerke erzeugen können. Tendenz steigend. Eigentlich exponentiell steigend. Um ein Atomkraftwerk zu ersetzen, benötigt man mehrere hundert Windräder. Über die Schwierigkeiten, alleine vier Windräder in Österreich zu bauen, wurde schon berichtet. Wir können nicht unendlich viel grünen Strom erzeugen, denn das ist durch geografische und natürliche Ressourcen vorgegeben und limitiert. Durch die zunehmende Digitalisierung wird bald jede Glühbirne, jeder Einkaufswagen, jede Jacke, jedes Ding um uns herum eigentlich ein Computer sein, der ununterbrochen Daten produziert. Diese Daten müssen verarbeitet und gespeichert werden. In naher Zukunft wird die gesamte IT-Industrie einer der größten Stromverbraucher sein. Die Gefahr ist daher sehr groß, zu raschen Lösungen zu greifen, wie zum Beispiel zum Bau von neuen Atomkraftwerken, wenn plötzlich der Energieverbrauch in der IT enorm ansteigt. Die andere Gefahr ist es, zu radikalen Maßnahmen zu greifen und den Zugang zur IT zu reduzieren beziehungsweise zu limitieren, mit teilweise verheerenden sozialen Auswirkungen.

Warum ist die IT mit ihrem Stromverbrauch so problematisch?

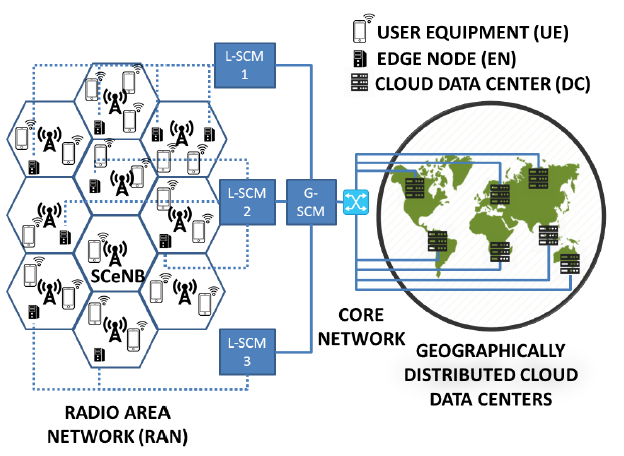

Daten müssen zunehmend dort verarbeitet werden, wo sie entstehen, auf dem ersten möglichen Datenverarbeitungspunkt im Netzwerk. Wenn vier selbstfahrende Autos in Wien auf einer Kreuzung ohne Ampel autonom und selbstregulierend die Kreuzung übersetzen müssen, dann kann der Server, der die Daten verarbeitet, nicht in Salzburg sein. Die Entscheidungen von selbstfahrenden Autos müssen in Bruchteilen von Sekunden geschehen. Liegt der Server in Salzburg, dann ist die Latenz (Antwortzeit) einfach zu groß. Daran wird sich in naher Zukunft nicht viel ändern, weder durch 5G, 6G oder andere Technologien – hier spielt die Physik einfach nicht mit. Damit die vier Autos samt Insassen unbeschadet davonkommen, muss die Datenverarbeitung in der unmittelbaren Umgebung geschehen. Die Daten werden zunehmend in der Internetinfrastruktur nicht nur befördert, sondern auch verarbeitet, zum Beispiel durch Router oder Switches. Diese sind aber nicht leistungsstark genug, wodurch neue kleine Rechenzentren, sogenannte "Edge-Rechenzentren", in der unmittelbaren Umgebung der Datenerzeuger gebaut werden. Eine Edge-Infrastruktur auf der Autobahn, in der Stadt und in anderen urbanen Gegenden aufzubauen ist sehr teuer, ineffizient und selten mit grünem Strom zu lösen.

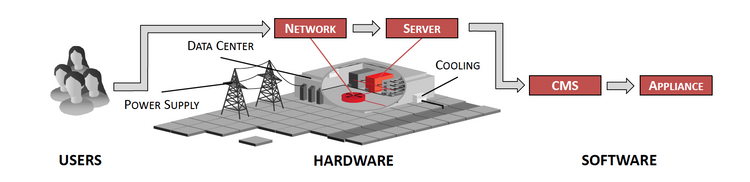

Klassische Rechenzentren und Cloud-Computing

Der klassische Ansatz ist die Auslagerung der Datenverarbeitung in große Datenzentren (zum Beispiel Clouds). Solche Rechenzentren können überall dort gebaut werden, wo es günstigen und grünen Strom gibt, und vor allem dort, wo es viel Platz gibt. Derzeit bauen viele Firmen sogenannte "high-latitude" Rechenzentren jenseits des sechzigsten Breitengrads, denn da können die Server natürlich gekühlt werden und die Kühlung macht oft fast 40 Prozent des gesamten Stromverbrauchs eines Rechenzentrums aus. Diese großen, optimierten und effizienten Rechenzentren gebaut auf der grünen Wiese helfen uns aber wenig bei den vier selbstfahrenden Autos auf der Kreuzung mitten in Wien. Deshalb werden die Erbauer von Rechenzentren immer einfallsreicher. Um die Kühlung günstiger zu machen, baut Microsoft Unterwasserrechenzentren. Es gibt mehrere Gründe, warum ein Rechenzentrum unter Wasser gebaut werden soll: Die meisten Leitungen sind bereits unter Wasser verlegt und die Hälfte der Weltbevölkerung lebt in Küstenregionen, somit ist neben der Kühlung auch für kurze Latenzzeiten gesorgt. Wien ist weit entfernt vom sechzigsten Breitengrad, und in Wien gibt es weder ein Meer, noch einen See, wo Rechenzentren untergetaucht werden könnten. Es ist daher die große Frage, ob es hier weiterer technologischer Durchbrüche bedarf, die uns helfen können, den enormen Stromverbrauch in den Griff zu bekommen.

Quantencomputer und Wasserstoffkraftwerke

Der erste Ansatz, um dem steigenden Stromverbrauch Herr zu werden, ist der Einsatz von völlig neuen, supereffizienten Rechenarchitekturen. Quantencomputer versprechen eine extreme Recheneffizienz beim Bruchteil des Energieverbrauchs von klassischen Computern. Quantencomputer eignen sich aber für hochspezielle Aufgaben, zum Beispiel im Finanzbereich, für Simulationen oder im Bereich der Lebenswissenschaften. Spannend bleibt die Frage wie sich dieser Forschungsbereich in der nahen Zukunft entwickeln wird. Es ist sehr unwahrscheinlich, dass ein selbstfahrendes Auto in mittlerer Zukunft mit einem Quantencomputer ausgestattet werden kann. Es ist auch sehr unwahrscheinlich, dass ein Quantencomputer mitten auf der Autobahn für die Echtzeitauswertung vom Kamerabildern eingesetzt werden kann.

Der zweite Ansatz ist die Speicherung von Strom über Zeit und Raum, was derzeit mit konventioneller Technologie nicht möglich ist. Mit Wasserstoffkraftwerken kann man genau das erreichen. Angenommen wir könnten in der Sahara riesige Farmen mit Sonnenkollektoren bauen, dann könnten wir enorm viel Strom gewinnen – allerdings in einer Gegend, in der fast keine Menschen wohnen und in der es sonst keine Stromabnehmer gibt. Man könnte aber mit diesem Strom Wasserstoff gewinnen, ihn in Behälter füllen und dann in Gegenden transportieren, wo viel Strom benötigt wird und wo Wasserstoffkraftwerke betrieben werden können. Leider zeigen die neuesten Untersuchungen, dass genau dieser Zwischenschritt (Wasserstoff erzeugen und transportieren) mit einem enorm hohen CO2-Fußabdruck verbunden ist.

Hybride Zukunft

Die Zukunft wird offensichtlich hybrid: Klassische und Quantencomputer, konventionelle und Wasserstoffkraftwerke. Wir werden aber mit den klassischen Computern und der klassischen Stromerzeugung über weite Strecken der digitalen Transformation auskommen müssen. Auf zwei Dinge können wir zurückgreifen: gut ausgebaute Telekommunikationsinfrastrukturen, die noch weiter ausgebaut werden und gut ausgebaute Internetinfrastrukturen. Die Herausforderung ist es, diese beiden Bereiche sinnvoll zu verbinden. In meinem FWF START Project Rucon wird auf der TU Wien genau diese Symbiose erforscht mit dem Ziel, Applikationen so über die Rechenzentren zu verteilen, dass möglichst wenig Strom verbraucht wird und die Benutzerzufriedenheit erhalten bleibt. Dabei untersuchen wir geo-temporale Bedingungen der einzelnen Edge/Cloud-Rechenzentren. Die Geo-Mobilität der Benutzer und die Möglichkeit, Applikationsprofile herzustellen, spielen dabei eine wichtige Rolle.

Leider lassen sich die Verhaltensweisen bei datenintensiven Applikationen sehr schlecht vorhersehen, weil sich die Datenwerte über unendliche Domänen erstrecken können. Statistische Verfahren versprechen große Abhilfe. Die zunehmende Mobilität der Benutzer, der Geräte und letztendlich der gesamten Infrastruktur bringen aber neue Herausforderungen für eine effiziente Arbeitslastverteilung. (Ivona Brandić, 9.1.2019)