Künstliche Intelligenz ist eine der aktuell wichtigsten Entwicklungen in der Techbranche. Viele Unternehmen entwickeln oder übernehmen lernfähige Systeme, um sie zu eigenen Zwecken zu trainieren. Ihre Einsatzgebiete sind weitreichend – vom Spamfilter über besser Computergegner in Videospielen bis hin zur Diagnose von Krankheiten wie Hautkrebs.

Die Technologie hat aber auch das Potenzial, Menschen mit körperlichen Einschränkungen das Leben zu erleichtern. Beispiele dafür liefern aktuelle Entwicklungen von Google und Microsoft. Sie arbeiten an Systemen, die Zeichensprache übersetzen und Gesichter beschreiben können.

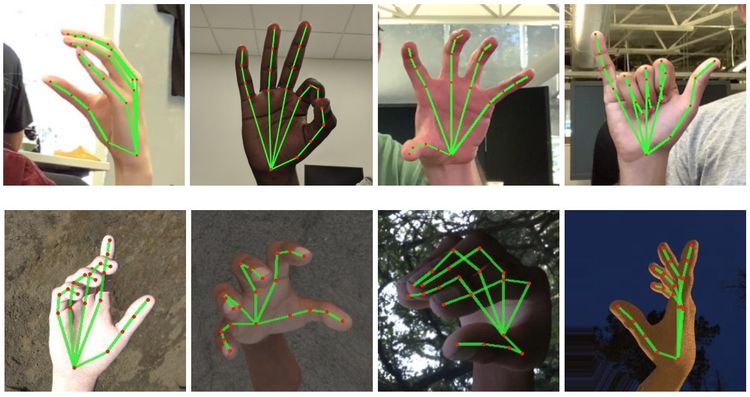

Ausgeklügelte Handerkennung

Bei Google nutzt man ein Open-Source-Framework namens Mediapipe, gedacht für die Verarbeitung "wahrnehmbarer Daten" wie Audio und Video und verknüpft es mit einer Kamera und Maschinenlernen.

Das System ist in der Lage, über eine Kamera ein oder zwei Hände zu erkennen, ihre dreidimensionale Ausrichtung zu verstehen und ihr 21 "Keypoints" zuzuweisen. Diese befinden sich auf der Handfläche, dem Ansatz der Finger sowie deren einzelnen Gliedern. Über ihre Bewegung und Anordnung erkennt die Software schließlich Gesten und übersetzt sie.

Von "Daumen hoch" bis Zeichensprache

Dabei verliert die KI auch nicht den Fokus, wenn etwa Hände zusammenkommen, etwa beim Händeschütteln. Bei der Erkennung von Handflächen, was aufgrund von deren Größe technisch sehr herausfordernd ist, erreicht man eine Erfolgsrate von 95,7 Prozent. Eine deutliche Steigerung im Vergleich zu herkömmlichen Implementationen, die rund zehn Prozent schlechter liegen. Das System lässt sich auch nicht davon außer Tritt bringen, wenn Teile der Hand durch Gesten (etwa eine Faust) oder Drehung verdeckt werden. Als Trainingsmaterial nutzte man rund 30.000 Handfotos.

Die Erkennung von Handgesten – reichend von "Alltagsgesten" wie "Daumen hoch" über "Schere, Stein, Papier" bis hin zur Zeichensprache – funktioniert auch in Verbindung mit einem Smartphone in Echtzeit. In Zukunft ließe sich damit also eine augmentierte Übersetzungs-App umsetzen, die bei der Kommunikation mit Menschen mit eingeschränktem Hör- oder Sprechvermögen hilft. Eine ausführliche Zusammenfassung über das System liefert Google in einem Blogeintrag.

"Project Tokyo"

Microsoft hingegen arbeitet an einem System, das Blinden und Sehbehinderten zugutekommen soll. "Project Tokyo" kombiniert KI mit spezialisierter Hardware – in diesem Falle eine angepasste Version der AR-Brille Hololens. In einem Artikel hat man nun den Status quo der Entwicklung beschrieben.

Diese verfügt über Gesichtserkennung. Taucht im Sichtfeld der Kamera eine Person auf, die in der Kontaktdatenbank des Trägers ist, so informiert sie ihn über akustische Hinweise. Dabei hilft die Raumerkennung in Verbindung mit dem Spatial-Audio-System der Brille, um den Standort des Erkannten zu kommunizieren.

Ebenso werden "visuelle Hinweise" von der KI erkannt, etwa wenn jemand Augenkontakt herstellt. Das soll die Teilhabe an Gruppensituationen erleichtern und die Verbindung zu anderen Menschen stärken.

Könnte im Schulbetrieb helfen

Entwickelt wurde "Project Tokyo" ursprünglich 2016 in Zusammenarbeit mit sehbehinderten Athleten bei den Paralympics in Brasilien. Microsoft plant eine Ausweitung des Projektes und eruiert aktuell, ob das System auch Blinden und Sehbehinderten beim Schulbesuch zum Vorteil gereichen kann. (gpi, 29.6.2020)