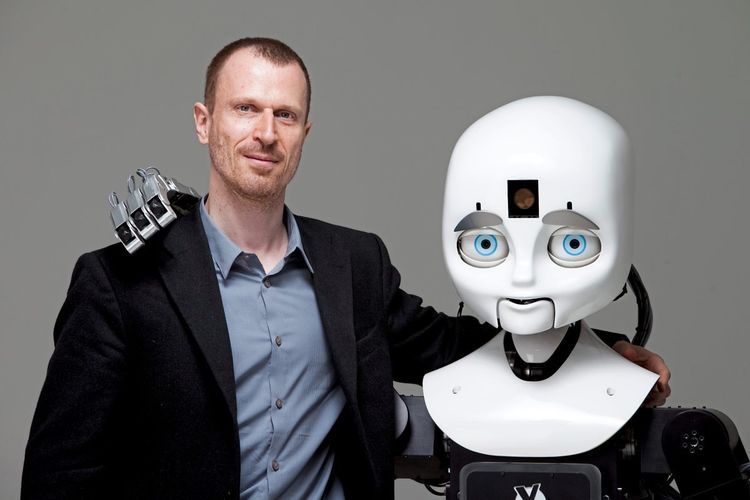

Nicht ganz auf Augenhöhe, trotzdem ein gutes Team: Matthias Scheutz bringt Robotern soziale Kompetenzen bei.

Eine neue Generation von Robotern, die keine passiven Arbeitsautomaten sind, sondern ihre Umgebung wahrnehmen, reagieren, und autonom Entscheidungen treffen: In den Forschungslabors von Matthias Scheutz sind sie bereits Realität. Der gebürtige Österreicher leitet an der Tufts University in Massachusetts, USA, das Human-Robot-Interaction-Labor und ist seit kurzem Principal Scientist am Center for Vision, Automation & Control des Austrian Institute of Technology (AIT) in Wien. Sein Ziel: Roboter zu besseren Teamplayern zu machen.

STANDARD: Roboter können besser mit Menschen zusammenarbeiten, wenn sie auf gemeinsame mentale Modelle zurückgreifen, wie Sie in einer kürzlich veröffentlichten Studie zu einer fiktiven Mars-Mission gezeigt haben. Was sind mentale Modelle?

Scheutz: Mentale Modelle sind Wissensstrukturen, die wir aufbauen, und zwar dazu, was der andere weiß, welche Ziele er hat, wie er sich in der Vergangenheit verhalten hat. Diese Strukturen sind essenziell, um Teamarbeit effizient zu gestalten, besonders unter Zeitdruck. Aus der Managementforschung weiß man, dass die effektivsten Teams die sind, in denen alle Mitglieder ein gutes Gesamtverständnis haben und es schaffen, die verschiedenen individuellen mentalen Modelle konsistent zu halten, indem sie sich ständig abstimmen. Das kann in gut trainierten Teams, wie etwa bei der Feuerwehr, auch nonverbal funktionieren. Wir können unseren Geist nicht teilen – im Gegensatz zu Robotern. Unser Ziel ist, dass autonome Roboter, die ihr Wissen über gemeinsame Plattformen teilen, in Teams integriert werden, Aufgaben selbstständig ausführen und auf Änderungen eingehen können – in der industriellen Fertigung, im Katastropheneinsatz oder auf dem Mars.

STANDARD: Wie war die Mars-Studie aufgebaut?

Scheutz: In Kollaboration mit Nasa-Forschern haben wir ein Szenario kreiert, in dem wir erstmals die Technologie der geteilten mentalen Modelle bei Robotern experimentell evaluiert haben. Es handelte sich um eine virtuelle Raumstation mit zwei Robotern und einem Menschen, wobei Letzterer die Hauptaufgabe hatte, mit einem Rover, der sich auf dem Planeten befindet, Kontakt zu halten. Die Nebenaufgabe, die uns eigentlich interessierte, bestand darin, dass Mensch und Roboter zusammenarbeiten mussten, um defekte radioaktive Säulen zu reparieren, die die Energie für die Station liefern. Das Experiment war so angelegt, dass die Frequenz der Schäden immer häufiger wird. So wollten wir eine bessere Vergleichbarkeit erreichen, ob sich Roboter mit oder ohne geteilte mentale Modelle besser schlagen.

STANDARD: Mit welchem Ergebnis?

Scheutz: Teams mit Robotern mit geteilten Wissensplattformen schafften es länger, die Versorgung der Raumstation aufrechtzuerhalten, da sich die beiden Roboter viel besser die Arbeit aufteilen konnten. Der eine wusste etwa, wenn der andere bei einer Säule angekommen war, und konnte sich ohne weitere Anweisung gleich den nächsten Aufgaben widmen. Der Mensch brauchte also nicht so viel mit den Robotern kommunizieren. Interessant war, dass die Arbeitsbelastung nicht sank, weil die Testpersonen die ersparte Zeit in die vermeintliche Hauptaufgabe investierten. In anderen Situationen kann es durchaus der Fall sein, dass die Extraarbeit, die einem der Roboter abnimmt, eine Erleichterung bringt.

STANDARD: Sie arbeiten in Ihrer Forschung auch daran, dass Roboter sich besser an menschliche Normen halten, was soziale Interaktionen betrifft. Wie bringen Sie Maschinen bei, sich richtig zu verhalten?

Scheutz: Die Idee ist, dass Maschinen, die in menschliche Kontexte eingebettet sind – Assistenzroboter im Spital oder Altersheim, Roboter, die im Empfang einer Bank arbeiten oder in einem Supermarkt aufpassen –, ein gewisses Verständnis von den sozialen Normen haben müssen. Sonst will niemand etwas mit ihnen zu tun haben. Es ist ein großes Problem, dass soziale und moralische Normen selbst kein konsistentes System bilden. Zum Beispiel wird die Norm, niemandem Schmerzen zuzufügen, gebrochen, wenn man geimpft wird. Wir Menschen müssen abwägen, wobei Werte und Vorstellungen eine Rolle spielen. Maschinen müssen in der Lage sein, in so einer Situation zu handeln.

STANDARD: Wie gehen Sie vor?

Scheutz: Der Ansatz, dass der Roboter sich per Maschinenlernen das Verhalten vom Menschen abschaut, ist hier aufgrund der Inkonsistenzen schwer durchführbar. Also müssen wir explizit vorgeben, welche Normen und Vorschriften in einer bestimmten Situation gelten. Wenn es einen Konflikt gibt und nicht alle Regeln befolgt werden können, schauen wir uns einfach formuliert an: Welche Teilmenge von diesen Normen ist die größte Teilmenge, die die minimalsten Verletzungskosten hat? Die wählt der Roboter dann. Ein Beispiel: Wenn es in einem Vorlesungssaal brennt, wo die Norm gilt, den Vortragenden nicht zu unterbrechen, dann darf man das in dem Fall trotzdem. Wenn Roboter die Prinzipien kennen, können sie sich auch für ihr Verhalten rechtfertigen. Denn sie wissen dann, was sie warum tun, auch wenn sie noch nie in dieser Situation waren. Beobachtungsbasierte Lernmethoden schaffen das nicht.

STANDARD: Deswegen kann ein Roboter auch einmal sagen: Nein?

Scheutz: Wir wollen keinesfalls, dass Roboter blindlings Anweisungen ausführen. In dem System, an dem wir arbeiten, geht der Roboter jedes Mal, wenn er eine Anweisung bekommt, eine Reihe von Fragen durch: Kann ich das? Kann ich es jetzt und hier? Ist die Person autorisiert? Wir wollen ja nicht, dass, wenn ich sage, ich brauche eine Latte für den Zaun, der Roboter zum Nachbarn geht und eine abmontiert. Er muss verstehen, was er darf, wer ihm was anweisen darf und ob es erlaubt und angemessen ist.

STANDARD: Im Umgang mit autonomen Systemen spielt Vertrauen eine große Rolle. Sie sprechen hier von emotionaler Intelligenz der Roboter. Kann man Empathie programmieren?

Scheutz: Da sind wir noch ganz am Anfang. Wir haben kürzlich in einer Studie gesehen, wie Menschen automatisch die Art und Weise, wie ein Roboter etwas sagt, interpretieren. Es ging um eine Situation, in der ein Teamleiter eine Aufgabe versemmelt hatte. Wenn der Roboter mit Empathie reagierte ("Nächstes Mal machen wir es besser"), wurde er als emotional intelligent eingestuft im Gegensatz zu einer unempathischen Reaktion ("Meine Schuld war es nicht"). Es spielt also eine große Rolle, wie Maschinen etwas ausdrücken. In weiterer Folge hängt das Vertrauen in die Maschine davon ab, wie emotional intelligent sie zu sein scheint.

STANDARD: Welche Rolle spielt das Aussehen des Roboters?

Scheutz: Wie eine Maschine konstruiert ist, wirkt sich unmittelbar darauf aus, wie sie behandelt wird und welche Fähigkeiten wir ihr zuschreiben. Es ist schockierend, wie stark Geschlechterstereotype auf Roboter übertragen werden. Wenn man nichts dazusagt, werden sie als männlich betrachtet. Umgekehrt haben Kollegen einem Roboter Lippenstift aufgetragen, und Männer haben die Maschine deutlich anders behandelt als einen neutralen Roboter. Weil wir die Tendenz haben, Roboter zu überschätzen und ihnen mentale Zustände zuzuschreiben, ist es sehr wichtig, dass wir ganz klar zeigen, was sie können und was nicht. Gerade in der Teamarbeit muss man genau wissen, was von einer Maschine zu erwarten ist – damit man sich auf sie verlassen kann. (Karin Krichmayr, 14.11.2020)