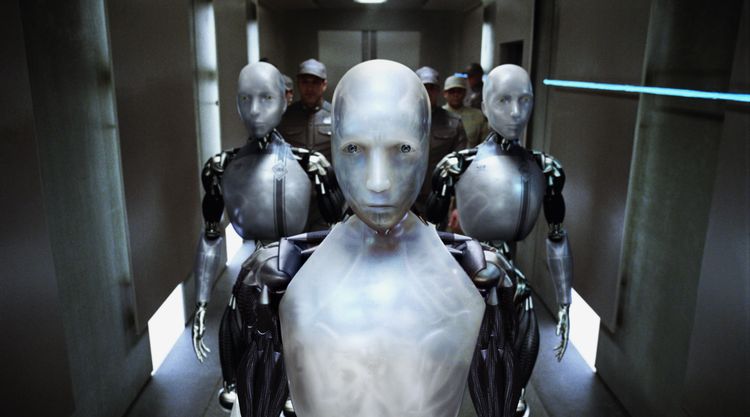

Können wir jemals feststellen, wann uns eine Software geistig überlegen ist – so wie im Film "I, Robot" aus dem Jahr 2004?

In dem Science-Fiction-Film "I, Robot", in dem humanoide Roboter im Chicago des Jahres 2035 in beinahe allen Lebensbereichen zum Einsatz kommen, unterliegt jeder Roboter drei Gesetzen. Erstens: Ein Roboter darf keinem Menschen schaden oder durch Untätigkeit einen Schaden an Menschen zulassen. Zweitens: Ein Roboter muss jeden von einem Menschen gegebenen Befehl ausführen, aber nur, wenn dabei das erste Gesetz nicht gebrochen wird. Drittens: Ein Roboter muss seine eigene Existenz bewahren, es sei denn, dies spricht gegen das erste oder zweite Gesetz. Damit soll verhindert werden, dass sich Roboter gegen die Menschen stellen. Freilich artet die Situation im Film bald aus, am Ende kann die Katastrophe und die Unterwerfung der Menschen durch eine sogenannte Superintelligenz nur knapp verhindert werden.

Was im Film schon möglich ist, lässt in der Realität (zum Glück, würden einige sagen) noch ein wenig auf sich warten. Eine "Superintelligenz", also ein Wesen oder ein Roboter, der dem Menschen in seiner Intelligenz um ein Vielfaches voraus ist, gibt es noch nicht. Trotzdem gehen einige Entwicklungen dahin, so einer künstlichen Intelligenz eines Tages zumindest nahe zu kommen: Hausroboter, die das Putzen übernehmen oder Angehörige pflegen, selbstfahrende Autos oder (zumindest einigermaßen intelligent wirkende) Sprachprogramme gibt es bereits, und sie sollen in den nächsten Jahren immer "intelligenter" werden.

Gefährliche Entwicklung

Auch deshalb warnen Wissenschafter schon jetzt vor den Gefahren solcher übermächtiger Software und Programme. Eine internationale Forschergruppe hat in einer neuen Studie untersucht, wie und ob sich eine Superintelligenz überhaupt kontrollieren ließe. Die kurze Antwort: Nein. Schon jetzt gebe es Maschinen, die wichtige Aufgaben unabhängig durchführen, ohne dass den Programmierern zu hundert Prozent klar ist, wie sie sich diese Aufgabe beigebracht haben, schreiben die Forscher – eine Entwicklung, die eines Tages für die Menschheit durchaus gefährlich werden könnte.

Die Wissenschafter sind nicht die Ersten, die sich mit der Frage der Kontrolle künstlicher Intelligenz beschäftigen. In einem Interview mit der "Zeit" beschreibt der schwedische Philosoph Nick Bostrom das Problem der Kontrolle folgendermaßen: "Stellen Sie sich eine Maschine vor, die mit dem Ziel programmiert wurde, möglichst viele Büroklammern herzustellen, zum Beispiel in einer Fabrik. Diese Maschine hasst die Menschen nicht. Sie will sich auch nicht aus ihrer Unterjochung befreien. Alles, was sie antreibt, ist, Büroklammern zu produzieren, je mehr, desto besser. (...) Um dieses Ziel zu erreichen, muss die Maschine funktionsfähig bleiben. Das weiß sie. Also wird sie um jeden Preis verhindern, dass Menschen sie ausschalten. Sie wird alles tun, um ihre Energiezufuhr zu sichern. Und sie wird wachsen – und selbst dann nicht aufhören, wenn sie die Menschheit, die Erde und die Milchstraße zu Büroklammern verarbeitet hat. Das ergibt sich logisch aus ihrer Zielvorgabe, die sie nicht hinterfragt, sondern bestmöglich erfüllt."

Maschine kontrollieren

Laut Bostrom müsse einerseits sichergestellt werden, dass die Entwickler einer solchen Maschine nicht darauf aus sind, persönliche Vorteile zu verfolgen. Zweitens müssen Kontrollmaßnahmen in die Maschine eingebaut werden, auf die die Maschine selbst nicht zugreifen kann und mit denen sowohl die Fähigkeiten als auch die Motivation der Maschine kontrolliert werden können.

Die Wissenschafter der aktuellen Studie sind da skeptischer. Sie experimentierten mit zwei Möglichkeiten, künstliche Intelligenz zu kontrollieren: Bei der ersten soll die Maschine vom Internet und anderen Geräten getrennt werden. Dabei würde sie jedoch auch alle ihre anderen Fähigkeiten einbüßen, für die sie geschaffen wurde. Für die zweite Möglichkeit könnte ein "Sicherheits-Algorithmus" programmiert werden, der es der Maschine verbietet, Menschen jemals Schaden zuzufügen – ähnlich den drei Gesetzen aus dem Film "I, Robot".

Algorithmus nicht funktionsfähig

Dieser Algorithmus wäre laut Forschern allerdings nicht in der Lage festzustellen, ob die künstliche Intelligenz tatsächlich vorhat, der Menschheit Schaden zuzufügen – und könnte von dieser ebenso leicht getäuscht werden. Zudem stellt sich für die Forscher ein weiteres Problem: Möglicherweise weiß die Menschheit nicht einmal, wann es eine Superintelligenz gibt, da allein das Verständnis für ein solches Wesen die Intelligenz des Menschen überschreiten würde.

Was bleibt also zu tun? Vielleicht sollten wir dem Rat des russischen Informatikers Roman Yampolskiy folgen, der meinte: "Wir sollten eine Superintelligenz nie aus ihrer 'virtuellen Box' befreien" – eine Art Käfig, der die Funktionen des Systems einschränkt –, nicht einmal dann, wenn diese eines Tages in der Lage wäre, die größten Probleme dieser Welt wie Armut, Pandemien oder den Klimawandel zu lösen. Aber selbst dann wären wir anderen Experten zufolge nicht zu hundert Prozent geschützt: Ein superintelligentes Wesen könnte es vielleicht auch schaffen, aus dem am besten gesichertsten "Gefängnis" auszubrechen. Würden wir es merken, bevor es zu spät ist? (Jakob Pallinger, 19.1.2021)