Da mögen draußen die Privatsphären- und Kartellrechtsdiskussionen toben, innerhalb von Googles Entwicklerkonferenz I/O ist die Welt noch heil. Also zumindest so heil, wie sie angesichts der aktuellen Pandemie überhaupt sein kann. Im Vorjahr abgesagt, findet die wichtigste Konferenz im Google-Jahr, die sonst tausende Entwickler ins kalifornische Mountain View lockt, dieses Mal zur Gänze virtuell statt. Im Fokus stehen dabei technische Neuerungen quer durchs Google-Universum – von Android bis zur Google Suche. Und von denen hat das Unternehmen auch heuer wieder eine ganze Menge zu bieten, wie sich im Rahmen der einleitenden Keynote am Dienstagabend schnell zeigen sollte.

Android 12: Die Beta ist da

Erste Testversionen von Android 12 mag es schon seit einigen Monaten geben, wie zu erwarten hat sich Google die wirklich großen Neuerungen aber einmal mehr für die I/O aufbehalten. Und dabei wird eines schnell klar: Wer sich bei den letzten großen Versionssprüngen beschwert hat, dass sich nur wenig Sichtbares getan hat, der wird das über Android 12 schwerlich behaupten können. Geht die neue Softwaregeneration doch mit einem kompletten Redesign der Oberfläche einher. Und so viel sei vorab verraten: Es wird bunter, verspielter – aber auch individueller.

Unter dem Namen "Material You" stellte Googles Design-Chef Matias Duarte eine Art nächste Generation des eigenen Material Design vor. Ein zentrales Konzept ist dabei die automatische Anpassung an die Vorlieben der Nutzer, etwa indem sich Farben des User Interface am Wallpaper orientieren. So wurden praktisch alle Teile von Android umgearbeitet – vom Lock Screen über einzelne Knöpfe bis zu Widgets. All das mit zahlreichen Animationen versehen. Das neue Design ist prinzipiell für alle Smartphones mit Android 12 gedacht, einzelne Funktionen sollen aber vorerst Googles eigener Pixel-Serie vorbehalten bleiben. Bis Herbst – also wohl nicht ganz zufällig zeitgerecht zur Vorstellung des Pixel 6 – will das Unternehmen auch gleich alle der eigenen Apps entsprechend angepasst haben.

Mit iOS 14 hat Apple bei seinen iPhones ein Konzept übernommen, das es bei Android schon seit langem gibt: Widgets. Diesen Umstand kann man nun für sinnlose "Wer hat's erfunden"-Diskussionen nutzen, oder aber man erfreut sich der Realität, dass diese Konkurrenz für die Nutzer erfreuliche Konsequenzen hat. Immerhin hat dies jetzt Google dazu gebracht, sein eigenes Widget-System zu hinterfragen und von Grund auf zu erneuern.

Android Privacy

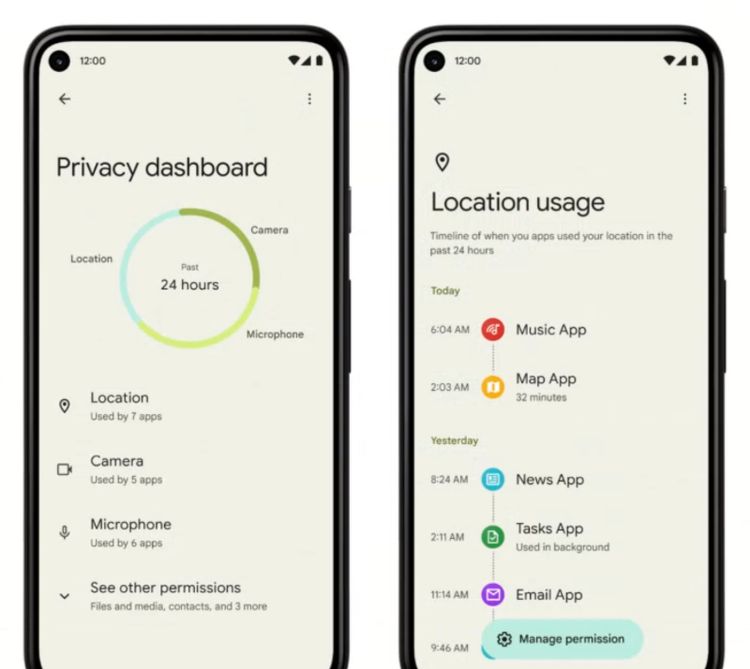

Keine neue Android-Release ohne Verbesserungen im Bereich Privatsphäre. Eine Regel, die in den vergangenen Jahren mit schöner Regelmäßigkeit eingehalten wurde, und auch für Android 12 nicht gebrochen wird. Das wichtigste zum Start: Android erhält ein "Privacy Dashboard". In diesem wird haarklein verzeichnet, welche App wann auf welche Berechtigung zugegriffen hat. Auch Statistiken dazu, wie oft einzelne Apps den Standort ermitteln oder Mikrofon und Kamera nutzen, gibt es. Zudem können an dieser Stelle gleich die zugehörigen Berechtigungen entzogen werden, wenn sich eine App unerwünscht verhält. Wer sich jetzt denkt: Das hab ich doch schon einmal wo gehört, hat natürlich recht. Dieses Feature war schon im Vorjahr in einer durchgesickerten Testversion von Android 11 zu sehen, in der fertigen Release war dann davon aber nichts mehr zu bemerken. Mit Android 12 wird es jetzt aber ernst.

Ein weiteres Privacy-Feature der neuen Betriebssystemversion nennt sich "Private Compute Core": Dabei handelt es sich um einen vom Rest des System getrennten Hochsicherheitsbereich. In diesem sollen sensible Daten verarbeitet werden, auf die andere Apps auf keinen Fall einen Zugriff haben dürfen. Nicht zuletzt denkt man dabei an Maschinenlernaufgaben, die ausschließlich lokal am Gerät erfolgen – also etwa smarte Wortvorschläge in der Tastatur oder auch die automatische Liederkennung bei Pixel-Smartphones.

Eine weitere Verbesserung gibt es Hinblick auf die besonders sensible Standortberechtigung. Ähnlich wie bei iOS gibt es künftig auch unter Android die Möglichkeit, mit Apps wahlweise nur den ungefähren oder auch den genauen Standort zu teilen. Wer wusste wie, konnte es schon in früheren Testversionen von Android 12 aktivieren, jetzt wird es aber offiziell: Mit der neuen Betriebssystemversion wird nun bei jedem Zugriff auf Kamera oder Mikrofon ein farblich auffällig gestalteter Indikator in der Statuszeile angezeigt. Ein Touch darauf offenbart dann auch, welche App dafür verantwortlich ist, und erlaubt zudem diese Berechtigung schnell wieder zu entziehen.

Vermischte Verbesserungen

Neu ist zudem ein Feature namens "Locked Folder", mit dem in Google Photos gespeicherte Aufnahmen durch ein zusätzliches Passwort geschützt werden können. Dieses Feature soll zunächst exklusiv für Pixel-Smartphones zur Verfügung stehen. Für die mobile Google-Suche ist wiederum eine "Schnelllöschfunktion" geplant, über die rasch die Daten der letzten 15 Minuten entfernt werden können. Und bei Google Maps soll noch deutlicher über den aus einer Privatsphärenperspektive besonders sensiblen Standortverlauf informiert werden. So soll etwa bei der nachträglichen Betrachtung der eigenen Wege über die Google-Maps-App nicht nur darauf hingewiesen werden, woher diese Daten stammen, sondern auch gleich ein Schalter angeboten werden, um diese Funktion zu deaktivieren. Im Endeffekt gehe es bei solchen Dingen immer auch um Transparenz, also dass die Nutzer wissen, wofür sie sich entscheiden, betont Google.

Was bei all dem aber auch auffällt, ist, worüber Google nicht spricht: Apples App Tracking Transparency. Einen ähnlichen Trackingschutz wird es unter Android zumindest vorerst also nicht geben. Das ist allerdings auch nicht ganz überraschend, immerhin ist es für Google als Werbefirma etwas schwieriger, solche Formen des "Third Party Tracking" zu deaktivieren, als für Apple. Insofern dürfte man in diesem Bereich wohl darauf warten, bis es privatsphärenfreundlichere Alternativen für personalisierte Werbung gibt.

So gesehen ist das Thema eng mit jener Problematik verknüpft, die sich gerade rund um den Browser Chrome stellt. Und dort hat Google zumindest schon ein ungefähres Datum genannt: 2022 sollen bei Chrome die "Third Party Cookies" abgeschafft werden, die Chancen für einen vergleichbare Maßnahme – was Apples "App Tracking Transparency" genau genommen ist – in Android 13 stehen also gar nicht so schlecht. Den für den Browserbereich gedachten Ersatz – die "Privacy Sandbox" oder auch konkret "Federate Learning of Cohorts" (Floc) – erwähnte Google im Rahmen der Keynote ebenfalls erneut. Ob sich dieser durchsetzt, wird sich angesichts des starken Widerstands, den es dagegen von allerlei Seiten gibt, aber erst zeigen.

Kooperation

Eine weiterer Schwerpunkt der aktuellen Android-Entwicklung ist die bessere Verschränkung mit anderen Geräten. So soll künftig jedes Android-Smartphone gleichzeitig automatisch als Fernbedienung für Fernseher mit Android TV dienen können – ganz ohne separate App. Zudem betont Google die stärkere Verschränkung mit Chromebooks über den dort angesiedelten "Phone Hub". Dieser bietet einerseits den Schnellzugriff auf die letzten am Smartphone geöffneten Links aber auch umgekehrt die Möglichkeit das Mobiltelefon aufzuspüren oder lieber doch stumm zu schalten. Und mit Android 12 soll das Smartphone auch als Autoschlüssel verwendet werden können – vorausgesetzt das eigene Gerät unterstützt die Ultrawideband (UWB)-Technologie.

Download

Die erste Beta für Android 12 steht ab sofort für Pixel-Smartphones ab dem Pixel 3 zum Download. Wer sich das manuelle Aufspielen mittels "Factory Image" oder "Full System OTA" ersparen will, für den gibt es ebenfalls erfreuliche Nachrichten: Mit dem Start der Betaphase ist es nun möglich, sich online anzumelden, um dann die neue Version bequem als Update ans eigene Smartphone geschickt zu bekommen.

Parallel zu Pixel-Geräten gibt es die Beta allerdings auch für ausgewählte Geräte anderer Hersteller – und zwar gleich einer ganzen Menge. Von OnePlus über Realme, Xiaomi und ZTE reicht die Palette bis zu Tecno und TCL. Eine Liste mit weiterführenden Links findet sich bei Google, auch wenn am späten Dienstagabend noch nicht alle davon funktionierten. Zudem scheint die Liste nicht ganz vollständig zu sein, hat doch HMD mittlerweile separat angekündigt, dass das Nokia X20 ebenfalls Teil des Android 12 Developer Preview-Programms ist.

Bis zur Veröffentlichung der fertigen Version von Android 12 werden übrigens noch einige Monate vergehen. Der aktuelle Zeitplan sieht noch mehrere weitere Testversionen vor, bevor dann im Spätsommer das stabile Update samt zugehörigem Quellcode freigegeben wird.

Wear OS

Es ist ein Comeback, mit dem viele schon nicht mehr gerechnet haben: Google zeigt plötzlich wieder Interesse an Smartwatches. Und zwar gemeinsam mit einem anderen großen Namen der Branche. In Kooperation mit Samsung wurde eine vollständig neue Wear-OS-Version entwickelt, die Googles System mit dem bisher von Samsung favorisierten Tizen zusammenführt – was auch bedeutet, dass Samsung künftig auf sein eigenes Betriebssystem verzichten will.

Die Kombination der beiden Systeme soll erheblich flotter sein – Google spricht von bis zu 30 Prozent schneller startenden Apps. Auch der Akkuverbrauch soll erheblich geringer ausfallen. Passend dazu wurde auch die Oberfläche grundlegend überarbeitet, ebenso wurden einige Google-Apps redesignet. Nicht ganz überraschend kam die Ankündigung, dass einige Fitbit-Funktionen direkt in Wear OS integriert werden sollen – immerhin hat Google das Unternehmen ja genau aus diesem Grund übernommen.

Künstliche Intelligenz

Spracherkennung und -ausgabe haben in den vergangenen Jahren große Fortschritte gemacht. Konversationen verlaufen hingegen meist noch immer relativ hölzern. Das will Google mit einem neuen Maschinenlernmodell für natürliche Sprache ändern. Dieses heißt LaMDA, und Google demonstrierte es im Rahmen der Keynote anhand einer Konversation mit einer KI, die sich für den – wie Pichai betont – Planeten Pluto hält. Google selbst betont allerdings, dass LaMDA noch in Entwicklung befindlich ist, derzeit also noch einige Fehler hat. Insofern wird es auch noch etwas dauern, bis das Ganze dann in fertigen Google-Produkten landet.

Wahrscheinlich eine der wichtigsten Neuvorstellungen der I/O ist gleichzeitig eine, deren Relevanz der breiten Masse zumeist eher verschlossen bleibt. Unter dem Namen "Multitask Unified Model" (MUM) stellt Google ein neues Maschinenlernmodel vor, und die damit einhergehenden Versprechungen sind groß. Das Unternehmen spricht etwas vage davon, das MUM tausendmal so mächtig wie das bisher zum Einsatz kommende BERT sein soll.

Greifbarer sind da schon andere Angaben: Wo Maschinenlernmodelle heutzutage üblicherweise auf eine Aufgabe spezialisiert sind, kann MUM gelerntes Wissen auf bis zu 75 unterschiedliche Sprachen übertragen – aber auch auf unterschiedliche Modalitäten wie Text, Bilder oder sogar Videos. Damit sollen ganz neue Anwendungsgebiete möglich werden, die ein tiefes Verständnis des Kontextes benötigen. Als Beispiel verweist man auf einen Satz, in dem die KI darüber informiert wird, dass man schon am Mount Adams war und nächsten Herbst dann den Mount Fuji besteigen will. Abschließend wird die Frage gestellt wird, was man anders machen solle, um sich auf den Trip vorzubereiten. Die Antwort könnte dann Details zur richtigen Ausrüstung aber auch zur relativen Schwierigkeit sowie passende Videos und Artikel enthalten, verspricht Google.

Bevor die Begeisterung darüber allzu groß wird: MUM sei zwar derzeit bereits weit fortgeschritten, trotzdem befinde sich das Ganze noch in einer experimentellen Phase, in der man nicht zuletzt nach passenden Anwendungen sucht, betonte Google auf Rückfrage des STANDARD bei einem Pressegespräch im Vorfeld der I/O. Insofern wolle man sich auch noch auf keinen fixen Zeitrahmen für die ersten Anwendungen festlegen.

TPUs

Einmal mehr kündigte Google eine neue Generation seiner Tensor Processing Units (TPU) an, die man in den eigenen Rechenzentren für die Beschleunigung von Maschinenlernaufgaben nutzt. Die TPUv4 soll dabei doppelt so flott sein wie die Vorgängerversion. Einzelne solcher TPUs können dann wieder in "Pods" mit bis zu 4.096 Einzelchips kombiniert werden, was Rechenleistung über einem Exaflop ermöglichen soll – das wären also 10^18 Fließkommaoperationen.

Erweiterte Bilderkennung und Augmented Reality

Wesentlich greifbarer als die langfristigen KI-Projekte sind da schon Verbesserungen an Google Lens: Die visuelle Suche soll nämlich erneut mächtiger werden. Konkret bedeutet dies, dass übersetzter Text künftig gleich auch kopiert oder als Ausgangspunkt für eine Suche genutzt werden kann. Auch Vorlesen lassen kann man sich solche übersetzten Passagen. Nicht zuletzt sieht man den Nutzen vor allem für Schüler und Studenten, die weitere Recherchen für ihre Hausarbeit vornehmen wollen – egal in welcher Sprache diese vorliegt. All das soll es noch im Mai über ein Update der Google- beziehungsweise der eigenen Lens-App unter Android geben, im Sommer folgt dann iOS.

Wer heutzutage von einem Smartphone aus eine Google-Suche durchführt, dem wird schon einmal aufgefallen sein, dass bei einigen Begriffen Augmented-Reality-Objekte angeboten werden, die dann quasi in die reale Welt gesetzt werden können, um sie näher zu betrachten. Bisher gibt es das etwa für einige Tiere oder den Curiosity Rover der NASA. Nun nutzt man dieses Feature, um Bewegungsabläufe von Sportlern zu veranschaulichen. Dafür hat man unter anderem mit der Turnerin Simone Biles sowie der Fußballerin Megan Rapinoe zusammengearbeitet. Das Ganze steht laut Google ab sofort zur Verfügung.

Seit einigen Monaten zeigt die Suchmaschine des Unternehmens unter dem Namen "About this result" Kontextinformationen zu einzelnen Informationen an, also vor allem woher dieses Wissen stammt. Bislang gibt es diese Transparenzangaben allerdings nur in den USA. Das soll sich jetzt ändern: Bald soll diese Funktion weltweit bei englischen Spracheinstellungen verfügbar sein, weitere Sprachen sollen dann folgen. Zudem sollen die dort gelieferten Informationen auch detaillierter werden.

Neuerungen für Google Maps

Erst vor wenigen Wochen hat Google eine Reihe von Neuerungen rund um seinen Kartendienst Maps angekündigt. Für die I/O hat man sich aber noch einige weitere Highlights vorbehalten. Dazu kommt eine Verbesserung der "Live View" genannten Augmented-Reality-Ansicht, die sich viele wohl seit der ersten Vorstellung dieses Features gewünscht haben: Damit kann künftig das Smartphone genutzt werden, um direkt in einer Kameraansicht Details zu Geschäften und Lokalen präsentiert zu bekommen. Diese Informationen werden dann einfach über das reale Geschehen gelagert. Zudem sollen in dieser Ansicht auch Straßenzeichen sowie der Weg zum eigenen Hotel – wenn man gerade auf Reisen ist – angezeigt werden. Der Zeitrahmen für all das ist derzeit aber noch etwas vage, Google spricht lediglich von "in den nächsten Monaten", dafür dann gleich auf Android und iOS.

Dazu kommt ein weiteres Update für die Routenplanung. So soll Google Maps in Zukunft nämlich nichts weniger als Unfälle vermeiden. Und das sieht so aus: Haben mehrere Routen eine ähnliche Ankunftszeit, sollen in Zukunft jene Wege vermieden werden, bei denen aufgrund der Verkehrslage ein harter Bremsvorgang zu befürchten ist. Auch hier spricht man von einem Launch in den kommenden Monaten – und das global. Gleiches gilt für ein Feature namens "Area Busyness". Durch dieses werden auf der Karte gerade überdurchschnittlich stark besuchte Stadtviertel markiert. Eine Art Warnung also für all jene, die sich lieber von Menschenmassen fernhalten wollen – oder auch ein Hinweis für die, denen in einer postpandemischen Welt irgendwann wieder der Sinn nach mehr Geselligkeit steht.

Bessere Karten

Dass es künftig deutlich detaillierteres Kartenmaterial mit Infos zu Fußgängerübergängen und Gehsteigen oder auch zu kleineren Wegen und Verkehrsinseln geben soll, hat Google schon mehrfach angekündigt. Neu ist insofern jetzt nur, dass man sich darauf festlegt, dass bis Ende des laufenden Jahres zumindest 50 Städte so ein Upgrade erfahren sollen. In dieser Liste findet sich neben Seattle und Singapur übrigens auch Berlin.

Wer sich von der Fülle an Informationen, die Google Maps mittlerweile so anbietet, erschlagen fühlt, für den gibt es ebenfalls gute Nachrichten: In den kommenden Monaten soll ein Update erfolgen, mit dem dann die angezeigten Plätze nach Tageszeit und ob man gerade auf Reisen ist gefiltert werden. So werden dann etwa am morgen Cafes statt Restaurants – die gar nicht offen haben zu dem Zeitpunkt – in den Vordergrund gestellt.

Google Photos

Einige neue Funktionen kündigt Google für seinen Fotoservice an. So sollen künftig mithilfe von Maschinenlernen "cinematische Momente" kreiert werden, wenn zwei kurz hintereinander aufgenommene Bilder vorhanden sind. Die KI füllt dabei quasi die Lücken aus, und erstellt automatisch eine kurze Videosequenz. Apropos Erinnerungen: Fortan will Google den Nutzern mehr Möglichkeiten geben, einzelne Momente gezielt auszunehmen, um schmerzhafte Erinnerungen zu verhindern.

Und dann gab es indirekt doch noch eine Erwähnung des Pixel 6 – also Googles nächstem Smartphone. Nämlich in Form eines Beitrags, in dem Google betonte, dass man seine Kameras künftig gezielt optimieren will, um Personen mit dunkler Haut auf Bildern besser wiederzugeben. Und genau das soll erstmals bei der kommenden Pixel-Generation zum Einsatz kommen.

Zusammenarbeitstools

Unter dem Namen Smart Canvas kündigt Google einige Neuerungen für all jene Office-Tools an, die man mittlerweile unter dem Namen Google Workspace anbietet. Damit soll vor allem die Zusammenarbeit mit anderen verbessert werden, indem Dokumente wesentlich interaktiver werden. So können damit etwa bei einzelnen Teilen über ein @username gezielt andere Nutzer, die am selben Dokument arbeiten, angesprochen werden. Neu sind ebenfalls gemeinsame Checklisten: Dafür wird Google Tasks ausgebaut, um anderen Usern Aufgaben zuweisen zu können. Zudem können künftig von einen Dokumente aus direkt Videoanrufe in Google Meet initiiert werden. Apropos: Für Meet kündigt man einen Companion Mode an, in dem sämtliche Teilnehmer in einer Art virtuellem Büro zusammengefasst werden.

Weiters sollen die Nutzer das Layout der Videoanzeige künftig nach Belieben manuell anpassen können. Und für viele wohl am interessantesten: Es soll künftig nicht nur automatisch generierte Untertitel in mehr Sprachen geben sondern auch gleich automatische Übersetzungen. All das soll im Verlaufe des Jahres unter anderem mit Englisch, Spanisch, Französisch, Portugiesisch und – ja, tatsächlich – auch Deutsch klappen.

Shopping

Ein Bereich, bei dem Google noch einiges Wachstumspotential für sich selbst sieht, ist der Online-Einkauf. Der "Shopping Graph" soll dabei helfen produktübergreifend die passenden Produkte zu finden. Das kann etwa mit einem Foto beginnen, auf dem ein Kleidungsstück mit Google Lens identifiziert wird, und dann mit einer Recherche im Desktop-Browser oder auch auf Youtube fortgesetzt werden.

Project Starline

Zum Abschluss der Keynote gab es dann noch eine echte Überraschung. Unter dem Namen "Project Starline" arbeitet Google an einer Art plastischem Videochatsystem, das mithilfe einer Fülle von Kameras und Tiefensensoren in Echtzeit ein extrem detailliertes 3D-Modell einer Person erstellt, und mithilfe von starken Kompressionsalgorithmen an das Gegenüber schickt. Dort wird dies dann auf einem – angeblich ebenfalls von Google entwickelten – Lichtfeld-Display dargestellt, was in eine äußerst realistische – und eben plastisch wirkende – Wiedergabe resultieren soll.

Was nach einem leicht übertriebenen Aprilscherz klingt, soll laut Google aber wirklich existieren und auch schon in einzelnen Büros des Unternehmens stehen. In den kommenden Monaten will man dann ausgewählten Partnern Zugriff auf Project Starline geben. Bei all dem betont die Firma allerdings, dass sich das Ganze noch in einem frühen Entwicklungsstadium befindet. (Andreas Proschofsky, 18.05.2021)