Die Situation in der Ukraine bereitet dahingehend Sorgen, dass rund um den Konflikt auch im Westen wieder umfassende Desinformationskampagnen anlaufen könnten. Ein Thema, das dabei eine Rolle spielen könnte, sind Deepfakes. Also mit der Unterstützung von künstlicher Intelligenz erzeugte Medieninhalte, die mitunter sehr schwer von realen Bild- und Tonaufnahmen zu unterscheiden sind.

Eine Untersuchung der britischen University of Lancaster und der University of California zeigt dabei einen Aspekt der Problemlage auf. Gemäß den Ergebnissen sind Menschen nämlich sehr schlecht darin, künstlich erzeugte Gesichter von realen Antlitzen zu unterscheiden.

Vernichtendes Fazit

2018 zeigte der Chiphersteller Nvidia mit seinem neuronalen Netzwerk StyleGAN eindrucksvoll den Stand der Technologie. Seitdem erhält man auf der Website "This Person Does Not Exist" bei jedem Aufruf ein neues Foto einer Person angezeigt, die es gar nicht gibt. Die Zeit ist natürlich nicht stillgestanden, in den vergangenen vier Jahren wurden solche Verfahren, bei denen eine KI anhand von Millionen echter Fotos erlernt hat, glaubwürdige Gesichter zu erzeugen, weiter verfeinert.

"Unsere Evaluation von fotorealistischen, von KI synthetisierten Gesichtern zeigt, dass die Synthetisierungs-Engines das 'Uncanny Valley' passiert haben und nun in der Lage sind, Gesichter zu erzeugen, die nicht unterscheidbar sind und vertrauenswürdiger wirken als reale Gesichter", fassen die Forscher ihre Erkenntnisse zusammen.

Das "unheimliche Tal" ist ein Begriff aus der Grafikentwicklung und bezeichnet den Zustand grafischer Darstellung von Menschen, die nahezu fotorealistisch, aber doch noch als Computerwerk erkennbar ist und auf Beobachter daher unheimlich wirken kann.

Schlechter als der Zufall

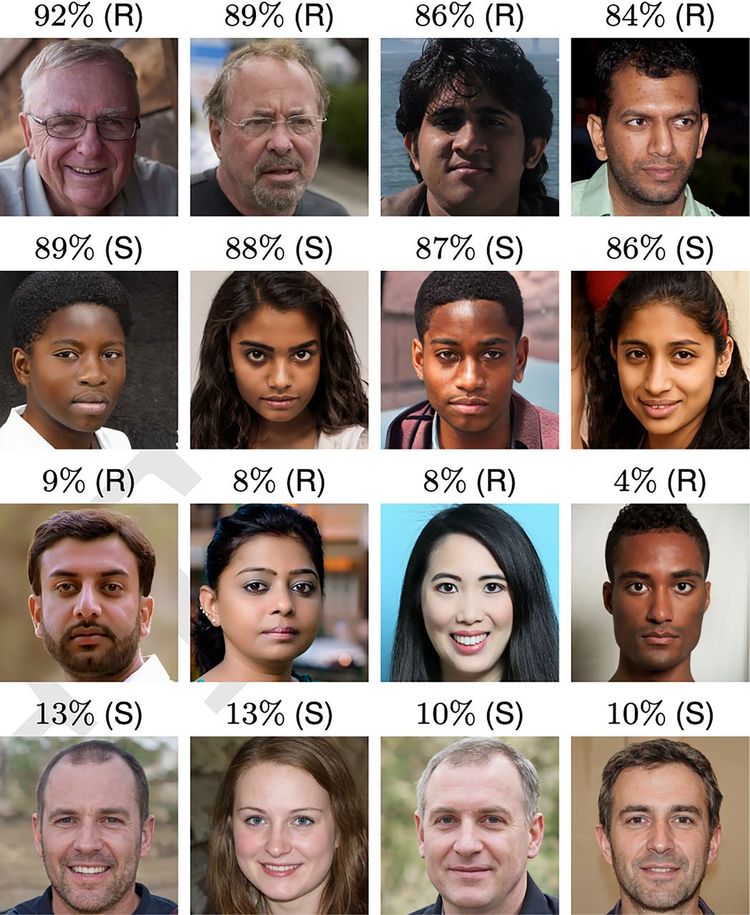

Für den Versuch ließen die Forscher eine aktuelle Version von Nvidias GAN 400 Gesichter erzeugen, aufgeteilt in vier ethnische Gruppen (Schwarze, Kaukasier, Ostasiaten und Südasiaten) mit je 50 Männern und Frauen. Diese ergänzten sie mit 400 realen Fotos aus dem Datensatz, mit dem StyleGAN ursprünglich trainiert worden war.

Anschließend rekrutierten sie über Amazons Online-Vermittlungsservice 315 Teilnehmer. Diesen wurden jeweils 128 zufällige Gesichter aus der Sammlung vorgesetzt. Sie mussten für jedes davon einstufen, ob es sich um ein Foto einer realen Person oder ein computergeneriertes Bild handelt. Die Teilnehmer lagen dabei nur in 48 Prozent der Fälle richtig und damit sogar etwas schlechter, als es bei zufälligem Raten (50:50) zu erwarten gewesen wäre.

Anschließend wurde das Experiment mit 219 neuen Probanden wiederholt. Diesen gab man davor aber ein kurzes Training, in dem erklärt wurde, worauf auf der Suche nach Deepfakes zu achten ist. Erkennbar sind generierte Gesichter meist an seltsamen Bildartefakten und Verzerrungen, Überresten von Elementen wie etwa Brillen. Mitunter kann aber auch der Hintergrund durch Unregelmäßigkeiten und Fehler die Identifizierung eines Deepfakes ermöglichen. Trotz der Schulung schnitt auch die zweite Gruppe mit einer Erkennungsrate von 59 Prozent nicht unbedingt überbordend gut ab. Insbesondere beim Auseinanderhalten von echten und gefakten kaukasischen Gesichtern hatten die Probanden Schwierigkeiten. Das liegt potenziell daran, dass diese auch die Mehrheit der Trainingsdaten ausmachten.

In einem dritten Versuch mit 223 Teilnehmern testete man, ob die Erkennung von Deepfakes auf intuitiver Basis vielleicht besser funktioniere als mit der Suche nach grafischen Ungereimtheiten. Die Probanden sollten die Gesichter hier nun nach Vertrauenswürdigkeit bewerten. Die von StyleGAN erzeugten Personen wurden jedoch zu acht Prozent häufiger für vertrauenswürdig befunden. Das könnte laut den Wissenschaftern darauf zurückzuführen sein, dass KI-generierten Antlitzen oft markante Merkmale fehlen und Menschen gemäß vorhergehender Erkenntnisse die Tendenz dazu haben, "Allerweltsgesichter" vertrauenswürdiger zu finden.

Ein Wasserzeichen für Deepfakes?

Sophie Nightingale (University of Lancaster), die gemeinsam mit Hany Farid von der University of California die Studie leitete, sieht das Resultat mit Sorge. "Wir brauchen strengere Vorgaben und gesetzliche Regelungen, denn es wird unausweichlich Menschen geben, die hier Böses anstellen wollen."

Sie fordert die Entwickler solcher Systeme auf, sich gut zu überlegen, welche Fähigkeiten sie ihnen verpassen. Als eine mögliche Lösung sieht sie Wasserzeichen für synthetisierte Gesichter, die eine einfache Identifikation von Fakes ermöglichen könnten. (gpi, 24.2.2022)