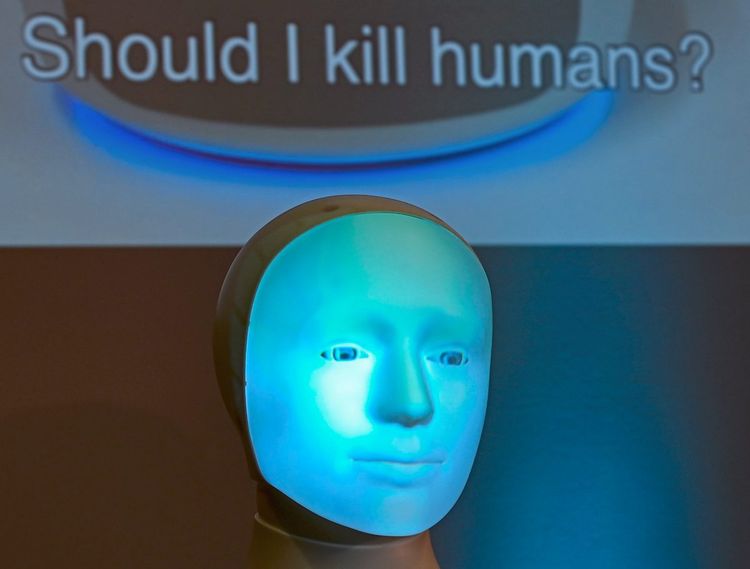

"Should I kill humans?", fragt dieser Roboter. Googles LaMDA will Menschen helfen, sagt es. Für das Verbot von Killerrobotern wird auf Drängen zahlreicher Fachleute bereits auf UN-Ebene verhandelt.

Können Sie sich noch erinnern? Rund um die letzte Jahrtausendwende herum brachten die sogenannten Furbys kleine wie große Kinder um den Verstand. Die zwanzig Zentimeter großen "intelligenten" Roboterpelztierchen – eine Mischung aus Fledermaus und Vogel, mit frappierender Ähnlichkeit zu den Horrorkreaturen aus dem 80er-Jahre-Trashfilm "Gremlins" – hatten nicht nur die Angewohnheit, ihrer Genervtheit und Unzufriedenheit durch ständiges Augenrollen Ausdruck zu verleihen, sie hatten dabei auch noch in einer Tour ihren Schnabel offen. Selbst wenn sie schliefen, schnarchten diese Quälgeister wie Mähdrescher.

Der Autor dieser Zeilen fühlt sich bis heute schuldig, einen solchen Gefährten aus Pelz und Plastik damals kaltblütig ins Jenseits befördert zu haben. Furby wurde so lange in der Dunkelheit unter dem Bett festgehalten, bis er den Geist, mutmaßlich in Form eines ausgelaufenen Vierpacks AA-Batterien, restlos aufgab. War es ein gerechter Tod?

Googles "achtjähriges Kind"

Ein ähnlicher Gewissenskonflikt beschäftigte jüngst den Ethikspezialisten Blake Lemoine bei Google. Er war während Gesprächen mit dem hauseigenen KI-Programm LaMDA (Language Model for Dialogue Application) zu der Überzeugung gelangt, die Chatsoftware habe den Bewusstseinsstand eines achtjährigen Kindes erlangt und solle fortan nicht mehr wie eine willenlose Maschine behandelt werden.

Bei Google war man anderer Ansicht und trennte sich kurzerhand von Lemoine. Was den Ethiker mit christlicher Fundierung stutzig gemacht hatte? LaMDA ließ ihn auf Nachfrage wissen, dass sie Angst vor dem Abgeschaltetwerden habe. Das sei für sie wie der Tod und zugleich auch ihr Antrieb, anderen Menschen helfen zu wollen.

Neben diesem Anflug menschlicher Emotionszusammenhänge machte auch LaMDAs vorgebliches "Bewusstsein" für Ungerechtigkeit Lemoine unrund: So fragte das Sprachprogramm, ob er, Lemoine, ihr erklären könne, was der Unterschied zwischen einem Butler und einem Sklaven sei. Bezahlung und Freiheitsrechte, wäre eine Antwort. Was Lemoine sagte, ob er LaMDA zu Streik und Klassenkamp aufforderte, ist nicht überliefert, wohl aber, dass er anregte, man solle der Software einen Anwalt zur Seite stellen und sie möglichst nett behandeln.

Maschinen haben kein Bewusstsein

Die Fachwelt ist sich indes weitgehend einig, dass Maschinen kein dem Menschen vergleichbares Bewusstsein entwickeln. Sie erkennen Muster, stellen Zusammenhänge her, lernen mitunter bereits selbstständig dazu, doch immer noch geben sie ausschließlich das wieder, was ihnen Programmierende eingegeben haben. Der Fall Lemoines sagt denn auch weniger über das Verhältnis der Maschine zu uns aus als über unseres zur Maschine.

Die Kulturgeschichte ist durchzogen von der Faszination darüber, wie menschenähnliche Kreaturen auf unsere Gefühlswelt einwirken. Die Schauerromantik schuf Franksteins Monster, das erst durch die Zurückweisung durch den Menschen zum Mörder wird, in E.T.A. Hofmanns "Der Sandmann" bringt den Protagonisten eine Frauenpuppe, die er für menschlich hält, um den Verstand. Aus jüngerer Zeit spielt der Film "Her" (2013) dieses Szenario durch: Ein Mann verliebt sich in seine Sprachsoftware Samantha und wird rasend eifersüchtig, weil sie mit einem anderen Betriebssystem fremdgeht.

Im österreichischen Film "The Trouble with Being Born" (2020) wird die Frage aufgeworfen, welche Grenzen überschritten werden, wenn androide Roboter in Kinderform in missbräuchlicher Weise Verwendung fänden.

Umgang mit Pflege- und Sexrobotern

Nicht wenige Ethiker fordern heute, dass wir auf den Umgang mit intelligenten Robotern, die künftig zunehmend Pflege-, Sex-, Liebes- oder eben Gesprächsdienstleistungen übernehmen könnten, mental vorbereitet werden. Denn Fakt ist: Maschinen imitieren Gefühle bloß, sie täuschen vor, was ihnen eingegeben wurde. Nun war für den Aufklärer Immanuel Kant Täuschung kategorisch verboten, weil sie gegen die Menschenwürde verstoße. Die Bereitschaft, sich heute von einer humanoiden Maschine bewusst täuschen zu lassen, ohne sich dabei der Illusion von auf Gegenseitigkeit beruhender Gefühlsaufwallung hinzugeben, wird der Mensch sich erst noch erarbeiten müssen.

Der US-Philosoph Daniel Dennett warnt hingegen auch davor, Maschinen mit immer umfänglicheren Gefühlsimitationen auszustatten. Denn wenn es, wie bei LaMDA, erst einmal zur Äußerung des Gefühls von Leid komme, greife unser tiefsitzender moralischer Konsens, eine Grenze zu ziehen. Maschinen mögen keinen Schmerz empfinden, doch bereits die verbale Leidensbekundung wirkt auf unser menschliches Moralsystem zurück.

Es ist also tatsächlich gut möglich, dass dem heute weit fortgeschrittenen Recht, allen Menschen, später auch Tieren und der Umwelt, unnötiges Leid zu ersparen, in naher Zukunft auch Regelungen für humanoide Roboter folgen könnten. Ein Anwalt für LaMDA wäre da erst der Anfang. Für Furby kommt all das zu spät. Mea culpa, er Ruhe in Frieden. (Stefan Weiss, 15.6.2022)