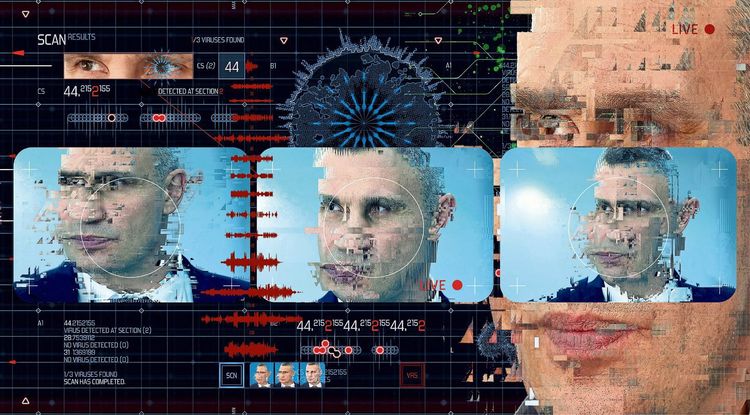

Was Wiens Bürgermeister Michael Ludwig durch den Kopf gegangen ist, als er vor einigen Wochen realisierte, einem Fake-Videotelefonat mit dem Kiewer Bürgermeister Witali Klitschko aufgesessen zu sein, ist unbekannt. Fast zeitgleich hatte es auch seine Berliner Amtskollegin Franziska Giffey und den Madrider Bürgermeister José Luis Martínez-Almeida erwischt, die das Gespräch jedoch abbrachen.

Ludwigs Büro bemühte sich schnell, von etwaigen eigenen Versäumnissen abzulenken, und sprach von einem "schweren Fall von Cyberkriminalität". Schnell machten Berichte die Runde, bei dem Video habe es sich um einen "Deepfake" gehandelt, also eine gefinkelte Manipulation von digitalem Bild- und Tonmaterial mithilfe künstlicher Intelligenz.

Russisches Komikerduo statt Deepfake

Die Vermutung war nicht völlig aus der Luft gegriffen. Denn Videomaterial kann mittlerweile relativ einfach so manipuliert werden, dass der Kopf einer abgelichteten Person ausgetauscht und anschließend neu animiert wird. Bekannt wurde das Phänomen 2017, als Pornovideos mit Prominenten wie Taylor Swift oder Scarlett Johansson die Runde machten. Deren Gesichter waren in die Videos hineinmontiert worden.

Im Fall des falschen Klitschkos setzten die mutmaßlichen Urheber – ein russisches Komikerduo – aber offenbar auf Lowtech. Wie sich später herausstellte, dürften sie einfach altes Videomaterial der Boxerlegende zusammengeschnitten haben. Die Stimme für das Gespräch, das auf Englisch geführt wurde, wurde ebenfalls nicht aufwendig mit künstlicher Intelligenz erzeugt, sondern offenbar von einem Klitschko-Imitator beigesteuert.

Pixeliges Videotelefonat

"Abseits aller technischen Möglichkeiten sind es oft einfache Tricks, mit denen wir uns täuschen lassen", erklärt Martin Boyer vom Austrian Institute of Technology (AIT). Er leitet das Forschungsprojekt "defalsif-AI", im Rahmen dessen manipulierte Foto-, Video- und Textdateien mittels einer Softwarelösung schnell identifiziert werden sollen.

Damit Manipulationen nicht sofort auffallen, würden etwa Videos künstlich auf eine niedrige Auflösung heruntergerechnet. Ungereimtheiten bei Bild und Ton, die von der Bearbeitung herrühren können, werden so verschleiert. Im Falle eines manipulierten Videotelefonats könne etwa eine schlechte Streamingverbindung vorgegaukelt werden.

Auch die geringfügige Gesprächsverzögerung, die beim Erstellen von künstlich erzeugten Bewegtbildern oder der Stimme unvermeidbar seien, könnten auf diese Weise legitimiert werden. "Das menschliche Gehirn verzeiht sehr viele Ungereimtheiten, gerade wenn wir nicht mit einer Täuschung rechnen", erklärt Boyer.

Um Manipulationen und Fälschungen zu erkennen, müsse man folglich zunächst einmal ein Bewusstsein entwickeln, dass diese jederzeit möglich seien, egal ob es sich nun um Fotos, Videos, Ton oder auch Text handle, sagt Boyer.

Eine Milliarde Bilder auf Instagram täglich

Dass man bei der Flut an Bildern und Videos, die Tag für Tag in sozialen Netzwerken, auf Onlineplattformen und über persönliche Kommunikationskanäle auf einen einprasseln, nicht immer und überall wachsam sein kann, liegt aber ebenfalls auf der Hand. Allein auf Youtube werden täglich über 720.000 Stunden an Videomaterial hochgeladen.

Auf Instagram werden jeden Tag über eine Milliarde Bilder gepostet, über Whatsapp sind es Schätzungen zufolge sogar fast sieben Milliarden. Nicht selten gehen dabei auch manipulierte oder aus dem Kontext gerissene Beiträge viral, die teilweise sogar von Medien aufgegriffen und weiterverbreitet werden.

Genau hier setzt die AIT-Software "defalsif-AI" an, deren Entwicklung im Rahmen des Sicherheitsforschungsprogramms Kiras vom Bundesministerium für Landwirtschaft, Regionen und Tourismus (BMLRT) gefördert wird. Sie soll künftig Alarm schlagen, wenn ein Foto oder ein Video Hinweise auf eine Manipulation liefern. Das Analysewerkzeug will die Ersteller manipulierter Beiträge mit ihren eigenen Mitteln schlagen: dem Einsatz gewiefter Algorithmen, die über maschinelle Lernprozesse immer besser im Erkennen von Fake-Inhalten werden.

Merkel, Obama und Gump

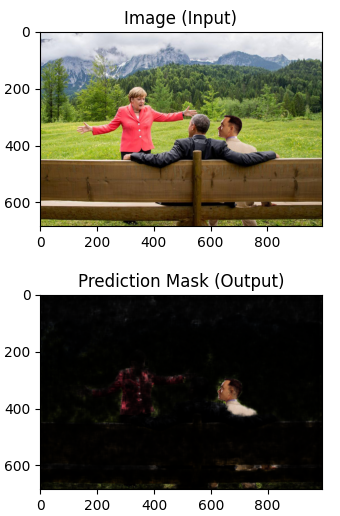

Wie das funktioniert, veranschaulicht Boyer anhand eines Bildes, das Angela Merkel vor einer Bergkulisse zeigt. Sie spricht mit Barack Obama, der auf einer Bank im Grünen sitzt. Dass das Bild mit Photoshop auffrisiert wurde, verrät ein nicht unwesentliches Detail: Neben Obama sitzt die Filmfigur Forrest Gump in derselben Pose, die man aus dem Filmplakat von 1994 kennt.

Um die Analyse zu starten, wird die Fotodatei auf die "defalsif-AI"-Plattform hochgeladen. Optional kann man das Entstehungsdatum und den vermuteten Ort der Aufnahme angeben – Medienberichten zufolge stammt das Merkel-Obama-Bild aus Garmisch-Partenkirchen. Die Bildanalyse, die sämtliche Pixel auf den Einsatz von Weichzeichnern, Schärfefiltern und anderen Bearbeitungseffekten untersucht, weist schnell den Bereich, wo die Filmfigur eingefügt wurde, als verdächtig aus.

Darüber hinaus spuckt die Software aufgrund der zu sehenden Umgebung den vermuteten Ort der Aufnahme aus. Erstaunlicherweise irrt sie sich gerade einmal um 50 Kilometer und verortet das Bild auf der anderen Seite des Gebirgsmassivs. Anhand des Aufnahmeorts prüft die Software auch die Wetterbedingungen zum kommunizierten Aufnahmezeitpunkt. Wäre statt bewölktem Frühlingshimmel ein Schneesturm zu sehen, würde die Software auch anschlagen.

Schließlich führt sie eine Bildersuche im Web durch. Ist das Bild schon vor längerer Zeit in anderem Kontext erschienen, ist das ebenfalls ein wichtiger Hinweis, dass es zweckentfremdet wurde.

Auch gegen Hassrede einsetzbar

Neben Foto-, Video- und Audiomaterial soll das System auch bei Texten zum Einsatz kommen, etwa um Hassrede oder politisch motivierte Desinformation im Internet zu entdecken. "Technisch ist und bleibt es ein Katz-und-Maus-Spiel. Deswegen kombinieren wir verschiedene Analyseverfahren, die bei Bedarf adaptiert werden können", erklärt Boyer. Die Entscheidung, ob tatsächlich ein Fake vorliege, obliege aber stets den Nutzern der Software. Diese gebe nur an, wie wahrscheinlich eine Manipulation sei.

Nach einer Evaluierung im Herbst, die rechts- und sozialwissenschaftlich begleitet wird, soll das Werkzeug unter anderem von Medien im Kampf gegen Fake-Beiträge eingesetzt werden können. (Martin Stepanek, 07.08.2022)