Eines ist unbestreitbar: Bei der Bewerbung eines neuen Smartphones machen sich große Zahlen immer gut. Insofern verwundert es nicht, dass sich aktuelle Geräte mit ihren Angaben zur Kamera geradezu überschlagen. Das neue iPhone 14 Pro kann etwa mit einem 48-Megapixel-Sensor aufwarten, bei Samsungs Top-Geräten sind es ohnehin schon seit ein paar Jahren 108 Megapixel – und Motorola setzt dem Ganzen mit einem 200-Megapixel-Sensor im unlängst vorgestellten Edge Ultra 30 die Krone auf.

Alle Wege führen zur gleichen Auflösung

Klingt nach einem Wiederaufflammen jenes Megapixel-Rennens, das die frühen Jahre der Digitalfotografie geprägt hat. Aus einer Marketingperspektive ist es das auch sicher, und doch ist alles etwas komplizierter. Denn egal welches der einleitend erwähnten Smartphones man auch benutzt, von Haus aus landen dabei erst recht wieder Aufnahmen mit rund 12 Megapixel auf dem lokalen Datenspeicher.

Pixel-Binning

Der Grund dafür nennt sich "Pixel-Binning", eine Technologie, bei der mehrere der lichtempfindlichen Einzelelemente am Sensor zu einem Bildpunkt in einer fertigen Aufnahme kombiniert werden. Beim iPhone 14 Pro werden etwa 2 × 2 Pixel zusammengefasst, beim Samsung Galaxy S22 Ultra sind es 3 × 3 und beim erwähnten Motorola-Smartphone gar 4 × 4 Pixel.

Doch wozu all das, wenn dann doch erst recht wieder "nur" eine Aufnahme in gewohnter Auflösung herauskommt? Um das zu erklären, muss zunächst einmal ausgeholt werden, um zumindest grob zu erklären, wie sich Smartphone-Fotografie in den vergangenen Jahren entwickelt hat.

Eine Vorgeschichte oder: Wieso alle bei zwölf Megapixeln stehengeblieben sind

Dass sich in den vergangenen Jahren Smartphone-Fotos rund um zwölf Megapixel eingependelt haben, hat durchaus gute Gründe. Da wäre zunächst einmal der simple Umstand, dass ein größerer Megapixel-Wert nicht notwendigerweise bessere Bilder bedeutet. Ganz im Gegenteil kann eine höhere Bildauflösung sogar nachteilig sein.

Das hat schlicht physikalische Gründe: In einem Smartphone ist sehr wenig Platz, also sind die verwendeten Kamerasensoren typischerweise ebenfalls sehr klein. Das wiederum bedeutet natürlich, dass auch die Bildpunkte winzig sind – üblicherweise im Bereich um die 1–2 µm. Je größer nun die Megapixel-Zahl ist, desto kleiner werden logischerweise die einzelnen Bildpunkte (wenn man von einem gleich großen Sensor ausgeht, versteht sich). Kleinere Pixel bedeutet vor allem, dass sie weniger lichtempfindlich sind, aber auch, dass sie stärker für Störungen und Fehler anfällig sind.

Computational Photography

Während die stetige Erhöhung der Megapixel-Werte also irgendwann kaum mehr relevante Vorteile – aber dafür einige Nachteile – versprach, tauchte ein anderes Thema am Horizont der Smartphone-Fotografie auf, die sogenannte Computational Photography. Statt eines Bilds werden dabei in rascher Abfolge mehrere Aufnahmen getätigt, die dann alle etwas anders sind und über schlaue Algorithmen für das fertige Bild kombiniert werden. Google war mit seinem HDR+-Modus einer der Pioniere, mittlerweile machen das aber alle Hersteller in der einen oder anderen Form bei ihren Smartphones.

Das wiederum führte in der Smartphone-Entwicklung zu einem Fokus auf eine immer schnellere Bildverarbeitung. Dadurch wurde es nicht nur möglich, eine immer größere Zahl an Aufnahmen für die Computational Photography heranzuziehen und so die Qualität weiter zu steigern, natürlich wurde auch die Aufnahme- und Berechnungszeit kontinuierlich verkürzt. Heutzutage geschehen diese Berechnungen praktisch in Echtzeit.

Zahlt sich nicht aus

Die Megapixel-Anzahl stagnierte hingegen, der Grund dafür ist eine sehr einfache Rechnung. Wenn ein Hersteller mit immer mehr Aufnahmen und Berechnungen – erheblich – mehr Qualität aus den Bildern holen kann als durch eine Megapixel-Steigerung, dann wird Letztere zu einer schlechten Idee. Immerhin bedeutet eine höhere Auflösung auch, dass sich der Rechenaufwand für die Computational Photography vervielfacht – womit man dann recht bald an die Leistungsgrenzen von solchen Geräten stieß; und je mehr Megapixel, umso schwieriger wird es.

Parallelentwicklung

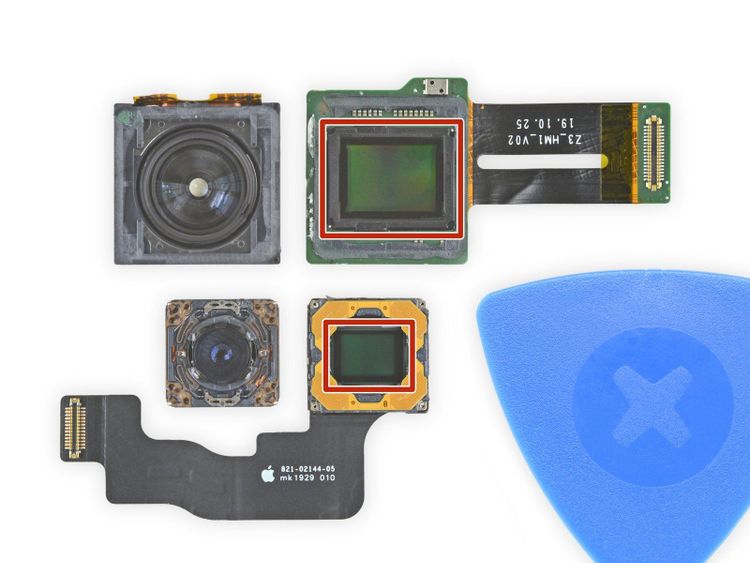

Parallel dazu gab es zuletzt aber noch einen weiteren Trend: den zu immer größeren Sensoren. Die Logik dahinter ist leicht erklärt: Ein größerer Sensor kann mehr Licht einfangen. Damit ist er nicht nur bei Abendaufnahmen besser, die ganze Kamera wird auch flotter, weil schneller ein Bild entstehen kann. Insofern ist es kein Wunder, dass der Sensor in aktuellen Top-Smartphones mittlerweile meist um ein Vielfaches größer ist, als es bei Spitzenmodellen vor ein paar Jahren der Fall war. Dass diese Geräte auch generell immer größer geworden sind, hat bei dieser Entwicklung natürlich auch geholfen.

Doch anstatt einfach einen 12-Megapixel-Sensor mit besonders großen Bildpunkten zu verwenden, hat sich eine andere Idee durchgesetzt: Es wird ein höher aufgelöster Sensor verwendet, bei dem dann für die Aufnahmen von Haus aus mehrere Pixel zu einem Bildpunkt in der fertigen Aufnahme kombiniert werden – das sogenannte Pixel-Binning.

Eine (zu) einfache Rechnung

Die Überlegung dahinter ist recht simpel: Am Abend können durch das Binning vergleichsweise lichtstarke Aufnahmen getätigt werden, während bei guten Lichtverhältnissen die volle Auflösung genutzt werden kann, um noch weitere Details aus einem Motiv herauszuholen. So weit das Marketingversprechen, in der Realität ist es dann nämlich doch nicht ganz so einfach.

Das Pixel-Binning hat nämlich einen negativen Nebeneffekt auf die Bildqualität, durch die komplexere Verarbeitung gibt es eine gewisse Neigung zu störenden Artefakten. Was auch heißt: Ein Zwölf-Megapixel-Sensor in gleicher Größe ist einem 48-Megapixel-Sensor in gleicher Größe zunächst einmal überlegen.

Hochauflösend ist nicht alles

Dazu kommt, dass die erwähnte Idee mit den hochauflösenden Fotos als Alternative ja schön und nett ist, in der Praxis aber nicht immer das hält, was sich die Nutzer davon versprechen. Zwar gibt es hier oft mehr Details, da die erwähnte Computational Photography aber etwa bei 108 Megapixeln (Spoiler: bis vor kurzem) nicht realistisch war, ist der Gesamteindruck einer solchen Aufnahme oft sogar schlechter.

Zudem sind die Aufnahmen eines 108-Megapixel-Sensors mit Pixel-Binning generell eine Spur schwächer als jene eines klassischen 108-Megapixel-Sensors. Um zu verstehen, warum, an dieser Stelle ein kleiner – und grob vereinfachter – Exkurs zum Thema "Wie Digitalkameras eigentlich funktionieren".

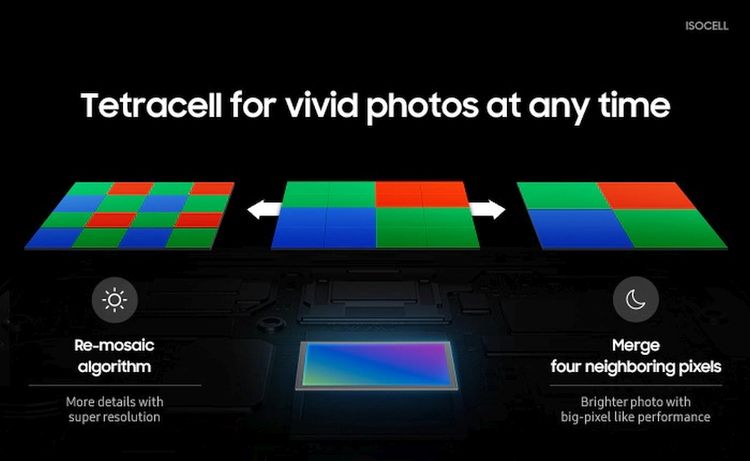

Damit eine Kamera überhaupt Farbe reproduzieren kann, kommen über dem Sensor verschiedenfarbige Filter zum Einsatz. Bei normalen Smartphones-Sensoren ist das ein Bayer-Filter, wo jedes Pixel einem gewissen Muster folgend eine andere Farbe abdeckt. Bei einem Pixel-Binning mit 2 × 2 Bildpunkten kommt stattdessen ein Quad-Bayer-Filter zum Einsatz, wo die vier zusammengefassten Pixel auch dieselbe Farbe abdecken. Das heißt natürlich: Bei einem Bild mit voller Auflösung ist diese Abdeckung nicht optimal. Über einen Prozess namens "Remosaicing" lässt sich das zwar zurückrechnen, ein gewisser Verlust an Bildqualität ist dabei aber unvermeidlich.

Wozu das alles?

All das wirft eine Frage auf: Wieso nehmen die Hersteller dann nicht einfach einen großen Zwölf-Megapixel-Sensor? Wenn wir jetzt mal den sicher nicht zu unterschätzenden Marketing-Faktor ausblenden, gibt es mittlerweile auch tatsächlich technische Gründe für die Wahl eines höher aufgelösten Sensors mit Pixel-Binning. Und das liegt nicht zuletzt daran, dass Smartphones bei der Bildverarbeitung immer schneller und besser geworden sind.

Das zeigt sich gerade beim iPhone 14 Pro gut, wo es über den ProRAW-Modus möglich ist, Bilder in voller Auflösung zu schießen, die tatsächlich oft besser sind als das, was sonst aus der iPhone-Kamera kommt. Das, weil dabei eben dank des technischen Fortschritts sehr wohl bereits mehrere Einzelaufnahmen in ein fertiges Foto kombiniert werden – also Computational Photography eingesetzt wird.

Nicht von Haus aus – aus gutem Grund

Gleichzeitig zeigt dieser Modus auch die aktuell noch vorhandenen technischen Beschränkungen. So ist die Aufnahme hier deutlich langsamer, und für die breite Masse ist Geschwindigkeit sicher wichtiger als eine möglichst hohe Detailtreue. All das ist aber ein Minuspunkt, der sich mit der fortschreitenden Hardwareentwicklung von selbst erledigt haben sollte. Was hingegen sehr wohl bleiben wird, ist, dass solche ProRAW-Aufnahmen dann schon einmal zwischen 75 und 120 MByte an Speicherplatz verbrauchen – ein Vielfaches der klassischen Zwölf-Megapixel-Fotos.

Wohin die Reise in Zukunft geht, zeigt aber auch Samsung vor: Dessen Galaxy S22 Ultra nimmt parallel zu mehreren Zwölf-Megapixel-Bildern auch ein Foto mit 108 Megapixeln auf, um daraus dann mehr Details für die fertige Aufnahme zu gewinnen. Die volle Auflösung wird also zur Verbesserung der Bildqualität des zusammengeführten Zwölf-Megapixel-Fotos genutzt.

"Zoom"

Bei Apple zeigt man mit dem iPhone 14 Pro aber noch eine weitere smarte Nutzung eines solchen Sensors vor, und zwar zur Verbesserung des digitalen Zooms. Bei einer zweifachen Vergrößerung wird nun einfach eine 48-Megapixel-Aufnahme getätigt, bei der dann aber nur die 12 Megapixel in der Mitte genutzt werden. Ja, das ist nichts anderes als "Croppen", also das Zuschneiden einer hochauflösenden Aufnahme. Trotzdem ist das Ergebnis – zumindest bei guten Lichtverhältnissen – einem klassischen digitalen Zoom überlegen, bei dem die Zwölf-Megapixel-Aufnahmen mithilfe smarter Algorithmen aufgeblasen werden.

Und noch ein weiterer Vorteil von Pixel-Binning, der bisher unterschlagen wurde: Einige dieser Sensoren nutzen die höhere Pixelanzahl, um den Dynamikumfang von Aufnahmen zu verbessern. Über eine gezielte Anpassung der einzelnen Subpixel ist es möglich, mehr Informationen zu Highlights und Schatten in einer einzelnen Aufnahme zu kombinieren – etwas, das sonst nur durch die Kombination mehrerer Bilder möglich wäre. Es handelt sich dabei also um eine Art "Echtzeit-HDR"-Modus – und das macht dann wieder Rechenzeit für andere smarte Algorithmen frei. (Andreas Proschofsky, 26.9.2022)