Den "Search On"-Event nutzte Google für die Vorstellung einer Fülle neuer Features, hier die bilderbasierte Suche nach Gerichten in der eigenen Umgebung.

Angesichts der Fülle an Aktivitäten, die Google über die Jahre entfaltet hat, könnte man es fast schon vergessen. Aber im Kern der Angebote des Unternehmens steht bis heute die Suchmaschine. Mit dem um diese gestrickten Werbegeschäft nimmt man auch weiterhin das meiste Geld ein. Insofern nimmt die Weiterentwicklung der Suche eine zentrale Rolle in der Strategie von Google ein. Im Rahmen eines "Search On" genannten Events hat der Softwarehersteller nun verraten, wie es mit der Suche sowie mit verwandten Services wie Google Maps und Shopping weitergehen soll.

Text, Bild und Sprache

Die grundlegende Richtung wurde dabei schon vor einigen Monaten vorgegeben. Im Rahmen der Entwicklerkonferenz I/O betonte Google Mitte Mai, dass die Zukunft der Suche multimodal sein soll. Das bedeutet, dass Sprache, Bilder und Text immer öfter bei Suchanfragen kombiniert werden sollen. Damit soll die Suche künftig auch "natürlicher" werden, komme dies doch näher an das heran, wie unser Gehirn denkt, ist zumindest Google überzeugt.

Als ersten Schritt gibt es seit einigen Monaten die sogenannte "Kombisuche", bei der visuelle Suchanfragen mit Google Lens nachträglich mit zusätzlichen Textfragen verfeinert werden können. Also etwa nach einer Jacke suchen, aber gleich dazuschreiben, dass man eine ähnliche gerne in Grün hätte – oder aber nach einem ganz anderen Kleidungsstück, das aber das gleiche Muster aufweist. Bisher ging das nur auf Englisch in den USA, in den kommenden Monaten soll diese Möglichkeit aber auf 70 weitere Sprachen ausgedehnt werden – darunter auch Deutsch.

Lokale Angebote

Der nächste Schritt nennt sich dann "In meiner Nähe". Damit kann nach der Verfügbarkeit einzelner Produkte in der jeweiligen Umgebung gesucht werden. Vom Foto eines einzelnen Gerichts ausgehend, kann dann etwa gesucht werden, wo es dieses in der Nähe gibt. Aber auch für andere Kategorien soll das funktionieren – darunter Kleidung oder Haushaltswaren. Die "Near me"-Funktion wird in einigen Wochen auf US-Englisch an den Start gehen, eine Ausweitung auf andere Sprachen soll dann kommendes Jahr folgen.

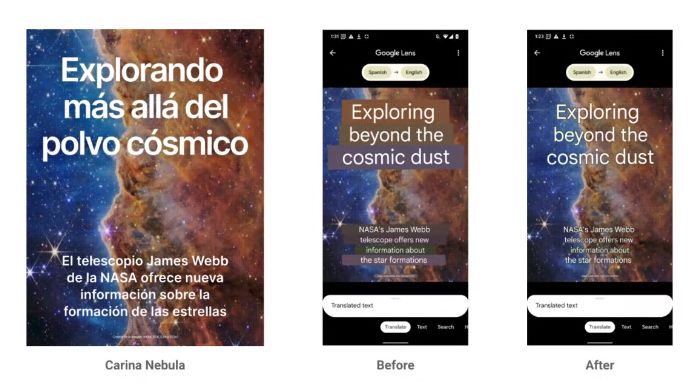

Übersetzung mit Lens

Eines der unumstrittenen Highlights von Google Lens ist die Möglichkeit, Texte mithilfe der Kamera zu übersetzen – und zwar direkt im Originalbild. Das kann ein Straßenschild ebenso sein wie das Menü in einem Restaurant. Nun soll die Qualität der Darstellung deutlich verbessert werden, womit sich die übersetzten Texte noch natürlicher in die Umgebung einfügen sollen.

Dabei setzt man auf dieselbe KI-Technologie, die auch schon bei Pixel Smartphones für den "Magic Eraser" verwendet wird, mit dem sich nachträglich störende Objekte aus einem Bild entfernen lassen – die sogenannten Generative Adversarial Networks (GAN). Diese Verbesserung für die Übersetzungsfunktion in Google Lens soll weltweit in den kommenden Wochen bei allen Android- und iOS-Nutzern ankommen.

Die nächste Generation der Suche

Ein weiteres großes Thema bei Google: Man will es künftig einfacher machen, tiefergehende Recherchen zu einem Thema durchzuführen. Dazu gehört, dass schon beim Eintippen von Suchanfragen verwandte Stichwörter angezeigt werden sollen, über die die Anfrage verfeinert werden kann. Zudem soll aber auch die Aufarbeitung der Ergebnisse verändert und vor allem visueller werden – und so auf eine gewisse Weise, die Suche neu erfunden werden.

Statt einer Liste an beim Runterscrollen immer weniger relevanten Ergebnissen sollen künftig also verwandte Themen angezeigt werden. Also etwa bei einer Suche nach einem Land ein dort gerade relevantes Thema präsentiert oder aber auch Videoeindrücke vermittelt werden. All das soll in den kommenden Monaten zunächst auf Englisch in den USA verfügbar sein und nach und nach in anderen Regionen und Sprachen angeboten werden.

Shortcuts

Deutlich näher ist da eine andere Neuerung: In der iOS-App für die Google-Suche sollen unter dem Suchfeld ab sofort Shortcuts auf beliebte Tools angezeigt werden, die sonst hinter Suchanfragen versteckt sind. Gemeint ist damit etwa der Schnellzugriff auf die Übersetzungsfunktion von Google Lens oder auch die Möglichkeit, schnell eine Produktsuche anhand eines hochgeladenen Bildschirmfotos zu starten.

Google Maps

Themenwechsel: Google Maps. Dort gibt es ebenfalls einen bunten Strauß an Neuerungen zu verkünden. Die erste nennt sich "Neighborhood Vibe" – also quasi "Grätzelstimmung". Das soll dabei helfen, sich einen "authentischen Eindruck eines Stadtteils zu verschaffen", wie es Google formuliert. Hier werden also etwa lokale Sehenswürdigkeiten neben Restaurants und anderen beliebten Orten dargestellt. All das natürlich mit zahlreichen Fotos und zusätzlichen Informationen angereichert. Dieses Feature soll in den kommenden Monaten für die iOS- und Android-Versionen von Google Maps verfügbar sein – und zwar global.

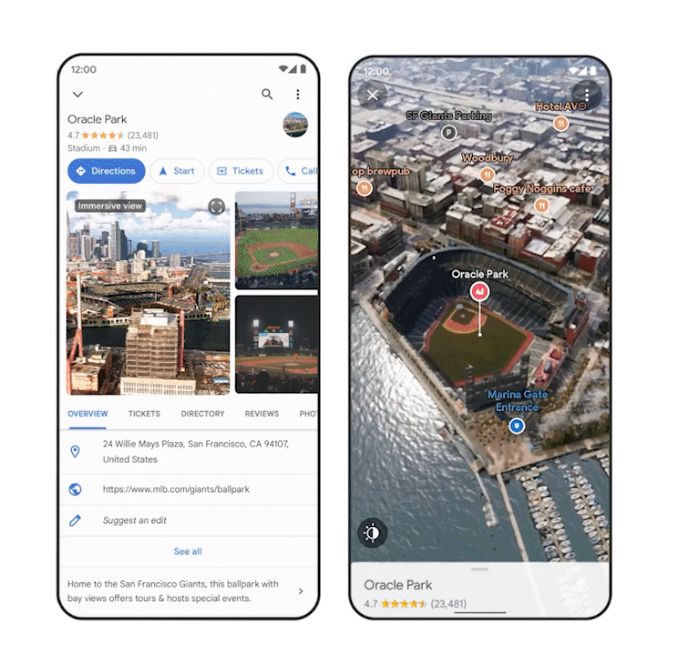

Neue 3D-Ansicht

Es war eines der visuell beeindruckendsten Demos der I/O-Keynote: Mit der "Immersive View" soll es künftig für ausgewählte Gegenden eine wesentlich detailliertere 3D-Ansicht in Google Maps geben. Dies samt der Möglichkeit, einen Zeitpunkt und Tag zu wählen, damit dann auch gleich das passende Licht und das erwartete Wetter sowie der Verkehr einbezogen werden. Basis dafür ist eine Kombination aus einer Unzahl von Satelliten-, Luft- und Street-View-Bildern sowie Echtzeitdaten – und natürlich ganz viel künstliche Intelligenz, wie es bei Google üblich ist.

Gerade für die Reiseplanung soll das neue Möglichkeiten eröffnen – oder aber auch einfach für Leute, die sich gerne via Google Maps in anderen Städten umsehen. Nun wird es mit diesen Plänen ernst: In den kommenden Monaten soll dieses Feature für die ersten Städte verfügbar sein. Konkret spricht Google von New York, San Francisco, London, Tokio und Los Angeles. Weitere Städte sollen im kommenden Jahr folgen.

Sehenswürdigkeiten

Etwas näher ist ein Ableger davon, die "fotorealistischen Luftaufnahmen für Sehenswürdigkeiten". Dabei werden aus den Daten der "Immersive View" fixe Animationen erstellt, die dann bei einzelnen Objekten auf Google Maps angezeigt werden. Bisher ging das weltweit mit rund 100 Sehenswürdigkeiten, ab sofort erhöht sich diese Zahl auf 250. Neu mit dabei sind etwa der Tokyo Tower oder auch die Akropolis in Athen.

Live-Ansicht

Unter dem Namen "Live View" bietet Google schon seit einiger Zeit eine Augmented-Reality-Ansicht, die die Karteninformationen mit dem von einer Smartphone-Kamera gelieferten Realbild kombiniert. Diese wird bald um eine Suchfunktion erweitert, sodass dann direkt in der Live-Ansicht nach einem Supermarkt oder einem Restaurant geforscht werden kann – und die Ergebnisse dort auch gleich visuell markiert werden. Auch dieses Feature soll es allerdings zuerst nur für sechs ausgewählte Städte geben – und zwar innerhalb der kommenden Monate.

Umweltfreundliche Routen

Besonders stark hat Google zuletzt seine "umweltfreundlichen Routen" forciert. So stark, dass sie seit kurzem gar schon in Österreich verfügbar sind. Als nächster Schritt sollen diese Informationen auch Entwicklern zur Verfügung gestellt werden, damit diese eine entsprechende Routenplanung samt Berechnung des CO2-Ausstoßes in ihre eigenen Apps integrieren können. Dabei denkt man nicht zuletzt an Liefer- oder Mitfahrdienste.

Google Shopping

Und dann wären da noch eine Reihe von Neuerungen für Google Shopping, die allesamt eines gemeinsam haben: Sie sind eigentlich nur für die USA relevant. Dazu gehört eine neue 3D-Ansicht für Schuhe sowie generell für Händler die Möglichkeit, deutlich leichter 3D-Modelle mit ein paar Fotos zu erstellen. Für komplexere Käufe werden nun eigene Einkaufsratgeber geliefert, und manche Shopping-Filter passen sich nun dynamisch an aktuelle Suchtrends an. (Andreas Proschofsky, 28.9.2022)