Quantencomputer sind der neue Hype. Das wird zumindest von etlichen Akteuren in diesem Bereich suggeriert: Aufgabenstellungen, für die konventionelle Rechner Jahrtausende benötigen würden, wären im neuen Computerzeitalter in Augenblicken machbar. Komplexe Optimierungen könnten enorme Energieeinsparungen ermöglichen. Naturwissenschaftliche Simulationen wären nicht mehr auf Annäherungen angewiesen und würden einen neuen Blick auf den Kosmos zulassen. Finanzwirtschaft, Materialwissenschaften und künstlicher Intelligenz stünden plötzlich ungeahnte Möglichkeiten zur Verfügung.

Viel Halbwissen und neue Ansätze

Doch so einfach ist es natürlich nicht. Der Hype ist nur zum Teil mit technischen Errungenschaften – oder realistische Aussichten auf künftige Forschungserfolge – gedeckt. "Zum Thema Quantencomputing wird derzeit viel Halbwissen vermittelt. Das liegt auch daran, dass viele Fachleute kaum konkrete Voraussagen zu nützlichen Anwendungen treffen können. Welche Anwendungen es in den nächsten fünf Jahren geben könnte, ist noch vollkommen offen", resümiert Philipp Schindler, der sich am Institut für Experimentalphysik der Universität Innsbruck mit Quanteninformationsverarbeitung beschäftigt.

Diese grundlegende Unsicherheit muss man mitbedenken, wenn der Quantencomputervorreiter IBM wie vor kurzem neue Rekordleistungsdaten präsentiert und die Pläne für eine relativ marktnahe Entwicklung der Technologie darlegt. Demnach verfügt Osprey, der neue Quantenprozessor des Technologiekonzerns, über 433 Qubits, was im Vergleich zur letzten Generation von 2021 beinahe einer Verdreifachung entspricht. Gleichzeitig legt man sich auf das Ziel fest, bis 2025 ein System mit mehr als 4000 Qubits vorlegen zu können. Neue Ansätze sollen zudem die Fehlerquote im Auslesen der Quantenbits verringern, was eine große Hürde auf dem Weg zu stabilen Systemen darstellt.

Quanten-Supercomputer

Eine Roadmap des Konzerns zeichnet einen Weg zu Quanten-Supercomputern vor, in der parallel geschaltete Quantenprozessoren in konventionelle Rechenzentren-Infrastrukturen eingebettet sind. Ein Quantennetzwerk soll Forschenden weltweit Zugang zu diesen Systemen geben und Anwendungen vorantreiben. Eine weitere Strategie zielt darauf ab, Kunden vor den Entschlüsselungsfähigkeiten künftiger Quantencomputer zu schützen, indem konventionelle Kryptografie auf neue Methoden umgestellt wird.

IBM ist nicht dafür bekannt, unzuverlässige Daten zu präsentieren. Und zweifellos sind diese Technologien wichtige Bausteine auf dem Weg zur Nutzbarmachung von Quantensystemen. Das soll aber nicht darüber hinwegtäuschen, dass noch viele weitere Bausteine fehlen. 400 Qubits, die verschränkte quantenmechanische Überlagerungszustände nutzbar machen, bergen ein großes Potenzial. Die Schwierigkeit liegt aber darin, die Qubits in diesen verschränkten Zustand zu bringen.

"Um das Potenzial zu heben, müssen die Quantensysteme voll kontrollierbar sein, damit die Qubits effektiv verwendet werden können. Heute kann man nur einen Teil des Quantenregisters in einen entsprechend komplexen Zustand bringen, da die Operationen relativ fehlerbehaftet sind", erklärt Schindler. Es bleibt abzuwarten, wie schnell IBM die Qubits verbessern und die extrem aufwendige Kontrollelektronik weiterentwickeln kann.

Hohe Fehlerquote

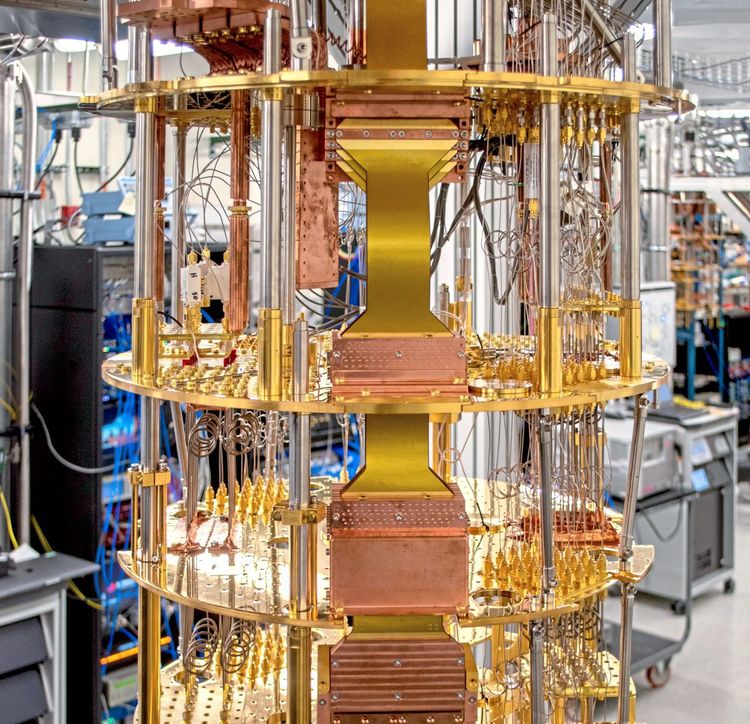

Eine weitere "Baustelle" ist das verlässliche Auslesen der Qubits. Dabei werden die Qubit-Zustände sehr oft gemessen und die Daten statistisch ausgewertet. IBM baut supraleitende Quantencomputer, bei denen die Ströme widerstandslos durch knapp bis auf den absoluten Nullpunkt herabgekühlte Schaltkreise laufen. Sie haben den Nachteil, dass die Fehlerquote bei diesen Messungen relativ hoch ist. In den Daten entsteht ein "Rauschen", das einem guten Ergebnis im Weg steht.

"Die Zahl der Messungen und die Qualität der Auswertung zu erhöhen würde das Ergebnis verlässlicher machen, aber auch die Laufzeit eines Algorithmus verlängern. Für große Systeme wird dadurch der Quantenvorteil negiert", sagt Schindler. IBM versucht dem Problem entgegenzuwirken, indem Geschwindigkeit gegen höhere Ergebnissicherheit eingetauscht wird. Ein ausgereiftes System bräuchte allerdings eine echte Fehlerkorrektur – die mit den verfügbaren Systemen nicht realisiert werden kann.

Um Fortschritte in Nutzbarkeit und Verlässlichkeit zu erzielen, hat IBM für 2024 eine "100x100"-Herausforderung angekündigt. Sie basiert auf ihrem kommenden Heron-Prozessor mit 133 Qubits, der auf besonders niedrige Fehlerquoten getrimmt ist. Bei der Challenge sollen mit 100 Qubits 100 Rechenschritte verfälschungsfrei aufeinander aufbauend ausgeführt werden können.

Das zu schaffen wäre auch aus der Sicht Schindlers ein großer Sprung nach vorn. Die Dimensionierung ist aber dennoch nach wie vor viel zu klein, um einen wesentlichen Quantenvorteil gegenüber der konventionellen Computertechnik zu lukrieren. "Wir wissen, dass mit sehr großen Systemen von Millionen Qubits exponentiell große Leistungsvorteile entstehen. Ob es für relativ kleine Quantencomputer sinnvolle Anwendungen gibt, bleibt vorerst offen", erklärt der Wissenschafter.

Moleküle vermessen

Schindler selbst nutzt Quantencomputertechnologie, um Eigenschaften und interne Strukturen komplexer Moleküle exakt zu vermessen. "Es geht darum, Information über Quantenprozesse innerhalb des Moleküls auf ein geladenes Atom in der Umgebung, das als kleiner Quantencomputer fungiert, zu übertragen und so untersuchen zu können", erklärt der Experimentalphysiker. Im Jahr 2020 erhielt er für seine Forschung einen hochdotierten ERC-Grant des Europäischen Forschungsrats.

Schindler rechnet damit, dass Quantencomputer in den naturwissenschaftlichen Bereichen – also etwa bei der Simulation von atomaren oder molekularen Vorgängen – eher eine gewinnbringende Anwendung finden. "Bei der Frage, ob Optimierungsaufgaben mit großen Datenvolumen mit Quantencomputern gut umsetzbar sind, bleibe ich skeptisch. In speziellen Fällen, wenn es wenige Eingangsdaten gibt, die Berechnung aber sehr schwierig ist, könnte ein Quantencomputer große Supercomputer schlagen", sagt der Wissenschafter. "Bei datenlastigen Berechnungen bin ich nicht sicher, ob sich der Aufwand wirtschaftlich bezahlt machen kann." (Alois Pumhösel, 25.11.2022)