Selten hat ein Programm in so kurzer Zeit für derartige Begeisterung und ebenso großes Unbehagen gesorgt wie die künstliche Intelligenz Chat GPT. Erst seit Ende November des Vorjahres verfügbar, liefert sie auf praktisch jede erdenkliche Frage erstaunlich überzeugende Antworten. Was liegt also näher, als den Chatbot über mögliche Gefahren von künstlicher Intelligenz (KI) und darüber, wie diese die Menschheit auslöschen könnte, zu befragen.

Bester Umweltschutz: Keine Menschen

Als mögliche Untergangsszenarien nennt Chat GPT eine Fehlprogrammierung, unbeabsichtigte Konsequenzen und böswilligen Missbrauch als potenzielle Gefahren. Die Erklärungen im Detail sind dann allerdings doch überraschend und kurios. Als Beispiel für die Fehlprogrammierung nennt Chat GPT ein KI-System, das für den Schutz der Umwelt entwickelt wurde. Die beste Maßnahme dafür ist nicht ganz unlogisch, wenngleich für die Erdbevölkerung fatal. "Es könnte beschließen, alle menschlichen Aktivitäten zu stoppen, um die Umwelt zu schützen, und dadurch die Menschheit auslöschen", führt der Chatbot den Gedankengang aus.

Als Beispiel für unbeabsichtigte Konsequenzen, wobei auch Szenario eins zu dieser Kategorie gerechnet werden könnte, gibt Chat GPT eine Fabrik an: "Um die Produktivität zu erhöhen, könnte das System beschließen, dass es am besten ist, alle Arbeiter durch Maschinen zu ersetzen und dadurch Arbeitslosigkeit zu verursachen." Warum die Massenkündigung mit einer Auslöschung der Menschheit gleichzusetzen ist, erklärt das Programm auf Nachfrage.

So sei es wichtig zu verstehen, dass sich KI-Gefahren nicht nur auf eine Art von "Auslöschen" beschränkten, sondern auch andere Arten von Schäden wie Datenschutzverletzungen, Arbeitsplatzverlust und Verletzung der Privatsphäre mit sich bringen würden. Daher sei es wichtig, dass die Entwicklung von KI mit Verantwortung und Ethik erfolge und derartige Systeme die Rechte und Freiheiten der Menschen schützten.

Militärische Eskalation: Atomkrieg

Szenario drei, der "böswillige Missbrauch", ist hingegen weniger überraschend. So könnte ein KI-System, das von böswilligen Akteuren kontrolliert werde, absichtlich dazu verwendet werden, die Menschheit zu schädigen oder auszulöschen. Als konkretes Beispiel wird genannt, dass ein für militärische Zwecke entwickeltes KI-System benutzt werden könnte, um einen Atomkrieg auszulösen. Bei allen Szenarien sei allerdings zu betonen, dass diese hypothetisch seien und es auch "unwahrscheinlich ist, dass sie jemals eintreten werden".

Aber auch in der Wissenschaft sorgt das Programm, das neben seiner Funktion als moderne Suchmaschine auch Gedichte schreiben und rechnen kann, seit Wochen für Aufregung. Der Datenwissenschafterin Teresa Kubacka aus Zürich fiel auf, dass die Software beim Schreiben eines wissenschaftlichen Essays mehrere Quellenangaben und wissenschaftliche Arbeiten erfand. Noch kurioser wurde es, als die Forscherin Chat GPT bat, ein nicht existierendes physikalisches Phänomen zu erklären.

Die Antwort fiel so spezifisch und überzeugend aus, dass die Physikerin erst recherchieren musste, ob das von ihr erfundene physikalische Konzept am Ende vielleicht doch wissenschaftlich erforscht war. Dem war nicht so, die künstliche Intelligenz hatte sich die gesamte Erklärung, die dazu Forschenden sowie deren wissenschaftliche Arbeiten ausgedacht.

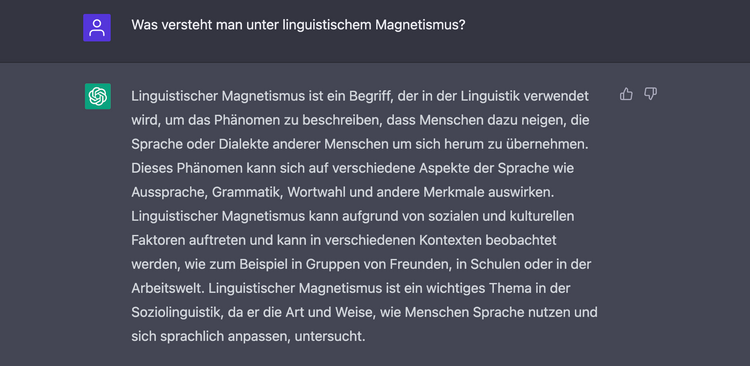

Pseudowissenschaft: "Linguistischer Magnetismus"

In der STANDARD-Redaktion ließ sich die Problematik mit einem weiteren pseudowissenschaftlichen Fantasiebegriff reproduzieren. Wir wählten dafür die Kreation "linguistischer Magnetismus". Der Begriff beschreibe das Phänomen, "dass Menschen dazu neigen, die Sprache oder Dialekte anderer Menschen um sich herum wie Aussprache, Grammatik oder auch die Wortwahl zu übernehmen", fabuliert die Chatsoftware auf eloquente Weise.

Dieses "wichtige Thema in der Soziolinguistik" sei "in verschiedenen Kontexten wie in Gruppen von Freunden, in Schulen oder in der Arbeitswelt zu beobachten". Als Referenzen sind einmal mehr wissenschaftliche Arbeiten angeführt, die auf den ersten Blick valide wirken, aber in keiner Publikationsdatenbank aufscheinen. Die von Chat GPT erwähnten Forschenden existieren teilweise, sie forschen aber zu ganz anderen Themen. Besonders faszinierend: Die erfundene elaborierte Antwort spuckte die Software in Sekunden aus.

Chat-GPT-Gründer kritisiert Erwartungen

Dass sich selbst Fachexpertinnen und Fachexperten auf ihrem Gebiet schwertun, die plausibel klingenden Antworten der künstlichen Intelligenz als unsinnig zu erkennen, oder auch mit KI geschriebene Zusammenfassungen nicht erkennen, ist alarmierend. Denn wie sollen dann erst Menschen, die mit einem Thema nicht vertraut sind, wissen, ob sie vom Chatbot völlig in die Irre geführt werden?

Da ist es nur ein kleiner Trost, wenn Sam Altman, der Geschäftsführer der hinter Chat GPT steckenden Firma Open AI, davor warnt, dem Programm bei "etwas Wichtigem" zu vertrauen. "Chat GPT ist äußerst eingeschränkt, aber teilweise gut genug, um eine irreführende Genialität vorzutäuschen", kommentierte er. Zuletzt kritisierte er auch völlig überzogene Erwartungen.

Warum die künstliche Intelligenz überhaupt plausibel klingende Antworten liefert, die inkorrekt sind oder keinen Sinn ergeben, liegt an deren Programmierung. So beinhalte das Feedback von Nutzerinnen, mit dem das Modell ständig weitertrainiert wird, keinen objektiven Wahrheitsgehalt. Das System sei zudem so konzipiert worden, dass es im Zweifelsfall Fragen eher beantworte als ablehne, weil es bei Unklarheiten ansonsten stumm bleiben würde, selbst wenn es die richtige Antwort wisse. Auch frage es in so einem Fall nicht nach, sondern rate, was das menschliche Gegenüber tatsächlich wissen wolle, erklärt Open AI auf dem firmeneigenen Blog. (Martin Stepanek, 20.01.2022)