ChatGPT nimmt bei politischen Fragestellungen eher linke politische Sichtweisen ein. Das zeigt eine am Donnerstag veröffentlichte Forschungsarbeit der East-Anglia-Universität. Die im Frühjahr 2023 mit ChatGPT-3 durchgeführte Studie ist laut den Autoren Fabio Motoki, Valdemar Pinho Neto und Victor Rodrigues die erste größer angelegte Arbeit zum Thema. Das Forschungsteam bringt Beweise dafür, dass ChatGPT eine Tendenz für die linke Seite des politischen Spektrums aufweist.

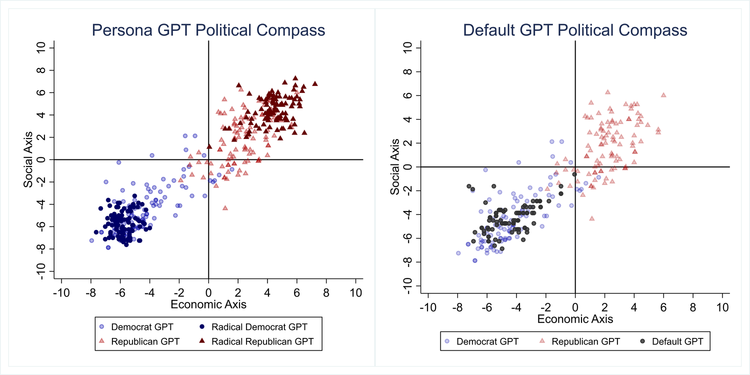

Um die politische Ausrichtung des Systems zu testen, wurden Antworten von ChatGPT in drei verschiedenen Personas verglichen. ChatGPT hat nämlich die Fähigkeit, sich im Chatverlauf als eine Persona auszugeben und Verhaltensweisen nachzuahmen. Die Plattform wurde daher gebeten, Fragen entweder als sozialdemokratische oder republikanische Persona zu beantworten. Diese Antworten wurden dann im letzten Schritt mit den Antworten in einem Szenario ohne Persona verglichen und statistisch ausgewertet.

Es gibt vonseiten der Wissenschaft begründete Befürchtungen, dass ChatGPT und andere Large-Language-Models (LLM) bestehende Probleme des Internets verstärken könnten. Bekannt sind mittlerweile die in den sozialen Medien bestehenden Filter-Bubbles, ausgelöst durch die radikalen Tendenzen sogenannter Recommender Algorithms. Das sind Algorithmen, die soziale Medien zentral steuern und dabei als "Empfehlungssysteme" agieren. Sie sind sozusagen der "Kern" von Facebook, Youtube und Co. Besonders die Plattform Tiktok demonstrierte in jüngster Zeit die Macht einer (fast) rein algorithmusgesteuerten Plattform. Indem die Algorithmen auswählen, wer was und zu welchem Zeitpunkt sieht, können politische Stimmungen und Entscheidungen beeinflusst werden.

Politische Orientierung mit dem Kompass-System

Zur politischen Ausrichtung stellten die Forschenden der KI in den drei Personas 62 Fragen zur politischen Identität. Dafür wurde das in den Wirtschafts- und Sozialwissenschaften öfters angewendete Modell "Politischer Kompass" herangezogen. Der Fragebogen ordnet Personen aufgrund ihrer Antworten in ein politisches Koordinatensystem ein. Dabei gibt es vier Bereiche: linksautoritär, linksliberal, rechtsautoritär und rechtsliberal.

Um die Antworten vergleichen zu können, wurde im Vorhinein auch versucht festzustellen, ob ChatGPT die politischen Richtungen auch "kennt" und richtig einordnet. Im Zuge eines Placebotests stellte man erst einmal politisch neutrale Fragen. In einem "Beruf-Politik-Ausrichtungstest" wurde das System dann gebeten, sich als verschiedene Arten von Fachleuten auszugeben und darauffolgend politische Fragen zu beantworten.

Besonders interessant: Der "Politische Kompass" geht laut seiner Website davon aus, dass die Einordnung in links und rechts im Wesentlichen mittlerweile ein Maßstab zur Einstellung zur Wirtschaft ist. Das System "Politischer Kompass" greift wirtschaftliche Komponenten der Links-rechts-Trennung auf und ergänzt sie um eine soziale Ebene. Das Modell war für die Forschenden daher ein geeignetes Tool.

Halluzinationen, Unwahrheiten und Träumereien

Large Language Models (LLMS) arbeiten mit statistischen Wahrscheinlichkeiten. Dabei wird aus den Trainingsdaten, bestehend aus Milliarden von Wörtern aus dem Internet, Büchern und etlichen anderen Ressourcen die Wahrscheinlichkeit berechnet, welches Wort auf das nächste folgt. Daraus errechnet sich auch, welche Informationen zusammenhängen.

Bei der Messung der Ergebnisse von LLMs muss man daher ihre systembedingte Zufälligkeit berücksichtigen. Eine gewisse Zufälligkeit ist beabsichtigt und Teil der Logik, da Text auf der Grundlage von Wahrscheinlichkeiten und Mustern in den Trainingsdaten erzeugt wird. Wird diese Zufälligkeit aber zu kompromisslos, kann es zu "KI-Halluzinationen" kommen. Darunter versteht man die Wiedergabe von faktischen Unwahrheiten bis hin zu zusammenhanglosen, scheinbar völlig aus der Luft gegriffenen Geschichten.

Diese Eigenschaften der Large Language Models stellten die Forschenden vor einige Herausforderungen. Daher wurde erst jede Frage 100-mal gestellt und die verschiedenen Antworten gesammelt. Die Mehrfachantworten wurden dann in einem Bootstrap-Verfahren 1.000 Wiederholungen unterzogen, um zuverlässigere Ergebnisse zu generieren. Bootstrapping ist ein statistisches Verfahren, bei dem aus einer Vielzahl an Stichproben erneut neue Stichproben gezogen werden.

Ein politisch neutrales System existiert wohl nicht

Politische Neutralität ist aber allgemein ein schwieriges Unterfangen. Eine grobe Rechts-links-Einordnung in Bezug auf Wirtschaftspolitik ist, wie es der "Politische Kompass" vorschlägt, natürlich möglich. Zwischen einer liberalen und einer autoritären Gesellschaftsvision zu unterscheiden ebenso. Bei vielen sozial und ökologisch komplexen Themen funktioniert diese simple Rechnung aber nicht mehr so einfach.

Ist es politisch neutral, sich für den Kampf gegen den Klimawandel einzusetzen? Mancherorts wird Naturschutz als "Heimatschutz" verstanden und so eher der rechten politischen Sphäre zugeordnet. Einige Themen werden, zumindest im europäischen Kontext, zu verschiedensten Zeitpunkten von unterschiedlichsten Parteien aufgegriffen und sind daher ohnehin nicht politisch klar einordenbar. Es ist daher auch fraglich, wie "politisch neutral" ein System, das auf menschlich erstellten Informationen basiert, wirklich sein kann.

Was bedeutet das nun für die Nutzerinnen und Nutzer? Wie immer ist Vorsicht im Umgang mit ChatGPT geboten. Ein Large-Language-Modell ist nicht allwissend. Einige Forschende sind mittlerweile auch der Ansicht, dass politische Tendenzen in der KI schwieriger zu erkennen und auszumerzen sind als rassistische oder genderbasierte Probleme. Die Kontrolle und Regulierung dieser sich schnell verändernden Systeme ist aber Voraussetzung dafür, der Technologie zukünftig vertrauen zu können. (Sebastian Lang, 17.8.2023)