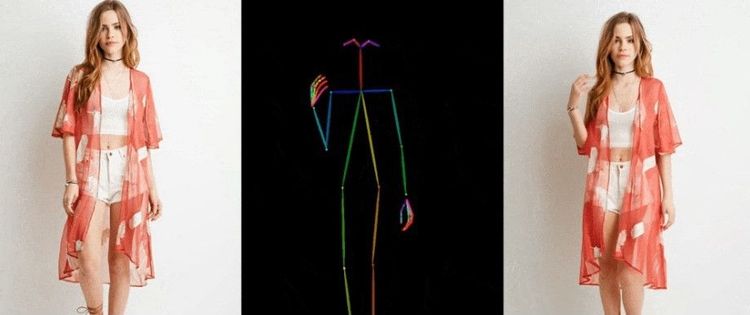

"Ruhet in Frieden, Tiktoker" – diese und ähnlich klingende Aussagen sind die Reaktionen, die von einem KI-Modell ausgelöst werden, das von Forschenden des chinesischen IT-Konzerns Alibaba entwickelt wurde. Das Modell mit dem Namen "Animate Anyone" ermöglicht es, Charaktere in Videoform basierend auf vorhandenem Bildmaterial und entsprechenden Bewegungssequenzen zu animieren. Wie das auf das technischer Ebene abläuft und wie sich das neue Modell im Vergleich zu der Konkurrenz schlägt, zeigen die Autoren des Papers in dem nachfolgenden Video.

Derzeit gebe es im Bereich der Bild-zu-Video-Erzeugung immer noch Herausforderungen, heißt es im Abstract des Papers. Unter anderem durch eine "Erweiterung der Trainingsdaten" könne das neue Modell beliebige Charaktere animieren und liefere im Vergleich zu anderen Bild-zu-Video-Methoden bessere Ergebnisse bei der Charakteranimation.

Geklaut von bekannten Tiktokern

Und genau hier entsteht einer der großen Kritikpunkte in Bezug auf Alibabas KI-Modell. Denn "Animate Anyone" hat Material von diversen Tiktokerinnen ohne deren Zustimmung verwendet, wie es unter anderem in einem Bericht von 404 Media heißt. Dazu gehören in der Tiktok-Community bekannte Namen wie Charli D'Amelio, Addison Rae, Ashley Nocera und Stina Kayy sowie diverse andere Accounts, die nur wenige Follower aufweisen.

Auch werden auf der Website von "Animate Anyone" diverse prominente Tiktokerinnen als Beispiele dafür angeführt, wie das KI-Modell funktioniert, namentlich handelt es sich dabei um die Infuencerinnen Jasmine Chiswell, Mackenzie Ziegler und Anna Šulcová. Chriswell hat auf Tiktok rund 17 Millionen Follower, Zieger 23,5 Millionen und Šulcová rund 890.000. Das Erstellen des Modells wäre nicht möglich gewesen, ohne von diesen Influencerinnen zu stehlen, heißt es in dem Bericht.

Die Influencerinnen verdienen ihren Lebensunterhalt mit den Videos und ihrer treuen Community: Wenn künftig jedermann auf Basis dieses Modells derartige Videos erstellen kann, dann untergräbt dies entsprechend das Geschäftsmodell. Schon jetzt ist es möglich, mit Tools wie jenen von Uberduck oder Eleven Labs Stimmen täuschend echt zu imitieren, und auch das Generieren von Fake-Bildmaterial ist mit bekannten Werkzeugen wie Midjourney, Stable Diffusion oder Dall-E eine Leichtigkeit.

Gefahr von Deepfakes

Abseits von den Themen des Urheberrechts und der kommerziellen Nutzung des Materials kommt jedoch eine weitere Problematik hinzu: jene, dass mit derartigen Modellen Menschen virtuell in Situationen platziert werden können, in denen sie sich nicht befinden wollen. Also Deepfakes, welche sich in Videos von vermeintlich rufschädigenden Aussagen diverser Politiker oder auch in Fake-Pornografie manifestieren können.

In einem Artikel von "Techcrunch" wird angemerkt, dass sich die Technologie nun so weit fortentwickelt habe, dass sie den Status reiner wissenschaftlicher Arbeit überschritten hat – das Alibaba-Paper baut auf Forschungsarbeiten der University of Minnesota auf – und bald gut genug ist, dass beim schnellen Scrollen über die Social-Media-Timeline kein Unterschied zu realen Inhalten mehr erkennbar ist. Bei Bildern und Text sei dies jetzt schon der Fall, bei Videoinhalten werde dies in naher Zukunft geschehen. Menschen mit bösartigen Absichten könnte die Technologie dann verwenden, um die erwähnten Deepfakes zu generieren.

Demo und Quellcode kommen bald

Derzeit hat das Team den Code noch nicht für die Öffentlichkeit freigegeben. Allerdings schreibt man auf der eigenen Github-Seite: "Wir arbeiten aktiv an der Vorbereitung der Demo und des Codes für die öffentliche Freigabe. Obwohl wir uns zum jetzigen Zeitpunkt nicht auf ein bestimmtes Veröffentlichungsdatum festlegen können, können Sie sicher sein, dass die Absicht, sowohl die Demo als auch den Quellcode zugänglich zu machen, feststeht." Es ist also nur eine Frage der Zeit, bis entsprechende Auswirkungen sich auch in der freien Wildbahn zeigen werden. (stm, 6.12.2023)