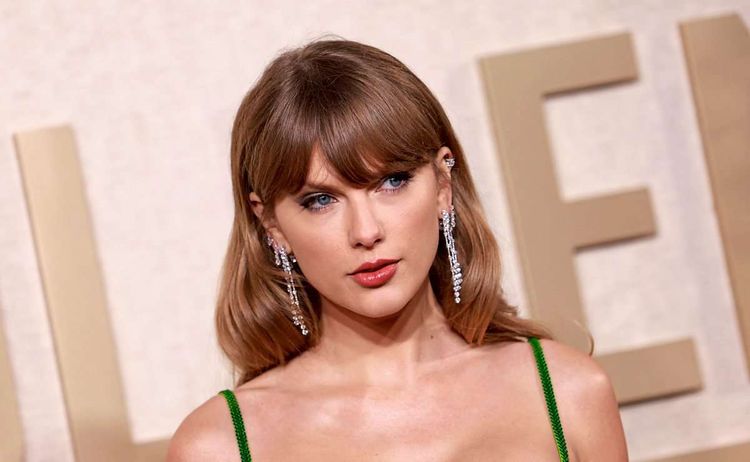

San Francisco – Elon Musks Online-Plattform X hat die am Wochenende verhängte Sperre für Suchanfragen nach dem Namen von US-Sängerin Taylor Swift wieder aufgehoben. Auslöser für die Blockade waren gefälschte pornografische Bilder von Swift, die unter anderem bei X die Runde machten. Die Suche nach dem Popstar ganz lahmzulegen, war eine vorübergehende Notlösung für die Plattform. Jetzt sagte X-Manager Joe Benarroch dem Finanzdienst Bloomberg und dem "Wall Street Journal", man werde Versuche, die Bilder weiterhin zu veröffentlichen, im Auge behalten.

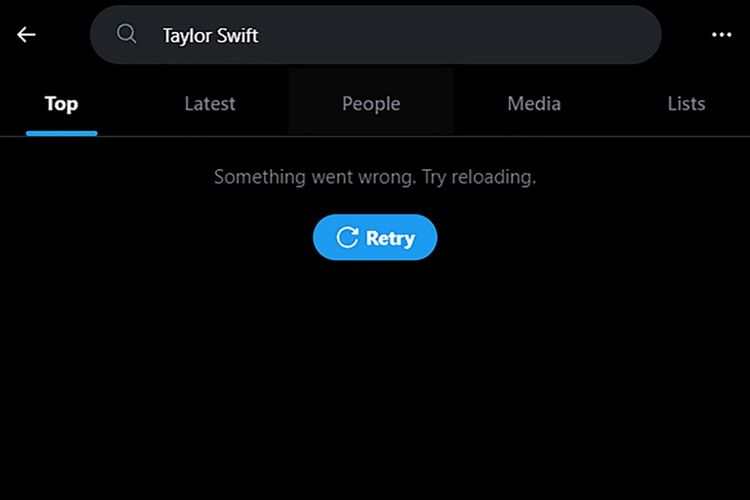

"Etwas ist schiefgelaufen"

Am Wochenende hieß es bei der Suche nach "Taylor Swift" auf der Plattform lediglich: "Etwas ist schiefgelaufen. Probiere, es erneut zu laden." Für X war die Sperre umso ungünstiger, da Swift seit Sonntag im Mittelpunkt der Aufmerksamkeit stand: Ihr Freund, der Football-Spieler Travis Kelce, zog mit seinem Team Kansas City Chiefs ins Saison-Finale Super Bowl ein – und das Netz war voll von Bildern und Videos des Paars nach dem Spiel.

Doch woher stammten die Bilder? Die Spuren führen zu einschlägigen Telegram-Kanälen und 4chan-Foren, in denen KI-generierte Bilder von Prominenten geteilt werden. Die pornografischen Bilder von Taylor Swift dürften mit Microsoft Designer, einem KI-Bildgenerator erstellt worden sein, wie 404 Media berichtet. Die Ersteller der Bilder dürften eine Schlupfloch ausgenutzt haben, das es ihnen ermöglichte die Inhalte zu erstellen.

Um klassische Deefakes handelt es sich dabei aber nicht. Die ursprüngliche Definition beschreibt Systeme, die auf Gesichter trainiert wurden und ein anderes in einem Zielvideo ersetzen. Die aktuellen Bilder sind aber vollständig von einer KI generiert, anstatt nur Gesichter in bestehendem Material auszutauschen.

Microsoft selbst hat die Lücke mittlerweile geschlossen und betonte, dass die Erstellung derartiger Inhalte einen Verstoß gegen die Nutzungsrichtlinien darstellt. Gleichzeitig betont ein Unternehmenssprecher auch, dass eine interne Untersuchung nicht beweisen konnte, dass die pornografischen Bilder von Taylor Swift tatsächlich mit Microsofts Designer erstellt wurden. Am Freitag sagte Microsoft-CEO Satya Nadella in einem Interview mit NBC News, dass es in unserer Verantwortung liegt, den KI-Tools mehr "Leitplanken" hinzuzufügen, um zu verhindern, dass sie schädliche Inhalte erstellen.

Eigentlich blockiert Microsoft Designer Prompts wie "Nacktbild von Taylor Swift" sofort, aber mit einigen gar nicht so ausgefallenen Tricks, ließ sich diese Sicherheitssperre umgehen. So fanden User auf Telegram und 4chan heraus, dass sich das Microsoft-Tool zur Erstellung von pornografischen Inhalten bringen lässt, wenn man den Namen des Promis absichtlich falsch schreibt und Bilder umschreibt, statt explizite Anweisungen zu sexuellen Handlungen zu geben. Diese Umgehungsmöglichkeiten hat Microsoft mittlerweile unterbunden. Auf 4chan behaupten manche User, dass sie bereits neue Exploits für Designer sowie Bing Image Creator gefunden hätten.

Die pornografischen KI-Bilder erreichten ein Millionenpublikum: Ein Exemplar erreichte 45 Millionen Aufrufe und wurde 24.000-mal repostet, in nur 17 Stunden, bevor es von X (vormals Twitter) offline genommen wurde. Offenbar kam man bei X mit dem Löschen kaum noch nach, weshalb man sich letztendlich gezwungen sah, die Notbremse zu ziehen, und die Suche nach Taylor Swift einschränkte. (APA, red 30.1.2024)