Der Verstand ist klar, der Körper aber gelähmt: Bei Locked-in-Patientinnen und -Patienten sind jene Teile des Gehirns geschädigt, die Bewegungen kontrollieren oder entsprechende Steuerungssignale weiterleiten. Betroffene können zwar denken, hören, sehen – Kommunikation ist aber etwa nur durch Computer möglich, die per Augenbewegung steuerbar sind. Im Rahmen des erst seit wenigen Monaten laufenden EU-Projekts Intrecom – gefördert vom European Innovation Council – möchten Forschende diesen Menschen ihre Stimme auf neue Art zurückgeben. Mittels Operation sollen leistungsfähige Elektroden über bestimmte Hirnareale gelegt werden, um Signale auszulesen, Sprache und Bewegung zu decodieren und so neue Assistenzsysteme zu ermöglichen.

Gernot Müller-Putz, Leiter des Instituts für Neural Engineering sowie des Labors für Brain-Computer-Interfaces an der TU Graz, ist mit seinem Team bei dem Projekt mit an Bord. Er hebt hervor, dass in den nächsten Jahren mittels invasiver Methoden – also unter den Schädelknochen implantierter Sensoren – vor allem gedachte Sprache decodierbar wird. Auch dem Auslesen komplexer Bewegungsmuster wird man wieder etwas näher kommen.

Gehirnimplantate werden allerdings bis auf weiteres lediglich im medizinischen Bereich zum Einsatz kommen. "Bei Locked-in-Patienten macht es Sinn, das Risiko einer Schädeloperation einzugehen, weil eine starke Lebensverbesserung erzielt werden kann", sagt Müller-Putz. Ähnlich ist es bei Implantaten zum Monitoring von schweren Fällen von Epilepsie. Bei Anwendungen für weniger schwere Krankheitsfälle und nicht-medizinische Einsatzgebiete sind dagegen nicht-invasive Methoden das Mittel der Wahl – sprich: Elektroden, die direkt an der Kopfhaut die Gehirnströme abnehmen.

Universelle Anwendung

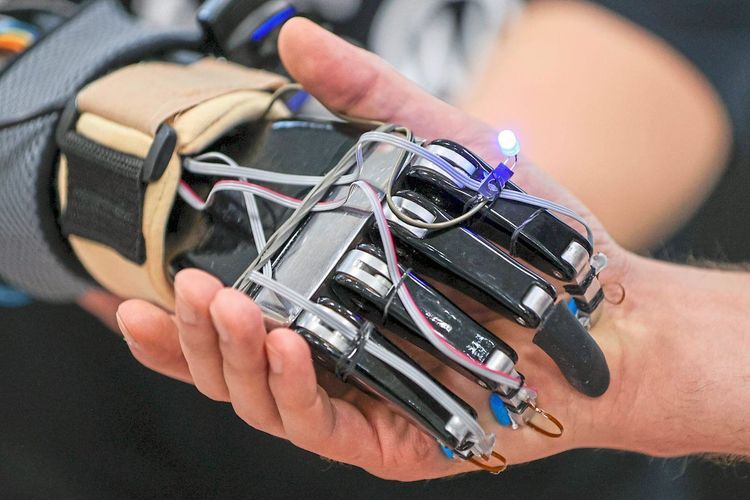

Müller-Putz beschäftigt sich seit geraumer Zeit mit der Erkennung von Bewegungen auf diese Art. In den Grazer Laboren arbeiten die Forschenden mit Probanden, deren Gehirnströme mittels Kappen, die mit Elektroden gespickt sind, aufgenommen werden. Hier ist es etwa ein Ziel, mittels der Brain-Computer-Interfaces eine Neuroprothese steuern zu können, die gezielte Impulse an die Nerven der Hand weitergibt. Die Genauigkeit der aufgenommenen Daten bleibt dabei zwar hinter jener der Implantate zurück, dafür birgt der Ansatz die Chance auf eine universellere Anwendbarkeit. "Der Durchbruch kommt, wenn die Systeme praktikabler werden", sagt Müller-Putz. "Die Autotelefone der 1990er brauchten auch noch eine schwere Kiste auf der Rückbank. Später kamen tragbare Geräte, die in jede Tasche passen. Diese Entwicklung könnte den nicht-invasiven Brain-Computer-Interfaces bevorstehen."

Eine Hausforderung bei den Grazer Experimenten ist, möglichst viele Daten von den jeweiligen Gehirnsignalen zu sammeln. "Wir definieren zuerst die Bewegung, die wir messen möchten, beispielsweise eine Handöffnung oder -rotation", schildert der Forscher.

"Dann zeichnen wir die Gehirnströme auf, während die Person die Bewegungen immer wieder durchführt oder – etwa bei Querschnittgelähmten – versucht, sie durchzuführen. Zusätzlich werden noch Beispiele von bis zu 20 weiteren Probanden gesammelt." Die Daten werden analysiert und nach statistischen Mustern durchforstet. Schließlich wird ein Machine-Learning-System anhand der Daten auf die Erkennung der Muster trainiert, sodass es sie später in neuen Aufnahmen wiedererkennen kann. In den aktuell laufenden Versuchen kann das System auf diese Art fünf bis sechs verschiedene Bewegungen unterscheiden.

Neuartige Deep-Learning-Methoden

Um mehrere Handbewegungen im Dickicht der Gehirnstrommuster zu erkennen, sind allerdings große und qualitativ gute Datensätze nötig. Das Problem: "Man kann kaum genug Beispiele aufzeichnen, um genug Trainingsdaten für eine größere Anzahl von Bewegungen zusammenzubekommen", bedauert der Wissenschafter. Erschwerend wirkt sich die Wandelbarkeit der Signale aus – sie verändern sich graduell abhängig von Tageszeit, Alter und verschiedenen äußeren Einflüssen.

Die Lösung sollen neuartige Deep-Learning-Methoden bringen, mit denen sich trotz einer überschaubaren Anzahl von Beispielen ein erstes Modell zur Erkennung von Bewegungen generieren lässt. Gleichzeitig ist es möglich, allgemeine Modelle auf Basis von Daten einer Personengruppe zu trainieren, die erst danach durch ein weiteres Training auf eine konkrete Person hin adaptiert werden. "Die Gehirnströme, die die Bewegungen steuern, sind zwar hochgradig individuell, dennoch gibt es auch Aspekte, die bei vielen Menschen wiederkehren", erklärt Müller-Putz dazu.

2021 ist es den Grazer Forschenden gelungen, erstmals Probanden einen robotischen Arm in Echtzeit kontinuierlich steuern zu lassen, ohne dass ein auslösender Gedanke oftmals wiederholt werden musste. "Wesentlich dabei ist, dass die Probanden die Augen verwenden dürfen, um die Bewegungsbahn des robotischen Arms zu verfolgen", erklärt Müller-Putz. "Diese Hand-Augen-Koordination liefert einen wesentlichen Beitrag zur Decodierung einer zielgerichteten Bewegung." Allerdings: Augenbewegungen sorgen für Artefakte, Störsignale, in den Daten. Der Schlüssel zum Erfolg war, dass diese Fehler in Echtzeit herausgerechnet werden konnten.

Falsche Versprechungen

Im Moment funktionieren Experimente dieser Art nur in komplexen Laboraufbauten und mit enganliegenden EEG-Kappen. Bis die Systeme zu einer mit Elektroden gespickten Baseballkappe mit tragbarem Mini-Computer als Steuereinheit für die Handprothese schrumpfen, wird es noch viele Jahre dauern. "Wie schnell Produkte am Markt sind, hängt vom Interesse der Gesellschaft und der einhergehenden Finanzierung ab", sagt Müller-Putz, der gleichzeitig vor den Versprechungen diverser Start-ups warnt. "Da wird oft viel mehr angepriesen als nach derzeitigem Stand der Technik tatsächlich leistbar ist."

Der Weg zu einem praktikablen, für viele Zwecke einsetzbaren Brain-Computer-Interface ist noch weiter, als der aktuelle Neurotech-Hype glauben machen will. Dass im Prinzip Gehirnströme aber auch mit nicht-invasiven Methoden erstaunlich detailliert interpretierbar sind, zeigte kürzlich eine Studie im Journal "Nature Neuroscience": Forschende der Universität Texas nutzten Daten von Magnetresonanztomografen, um zusammenhängende Wortsequenzen und Sätze aus dem Gehirn auszulesen. Immerhin beruhigend: Man fand dabei auch heraus, dass die Kooperation der beteiligten Personen notwendig ist, damit die Sache funktioniert. (Alois Pumhösel, 30.5.2023)