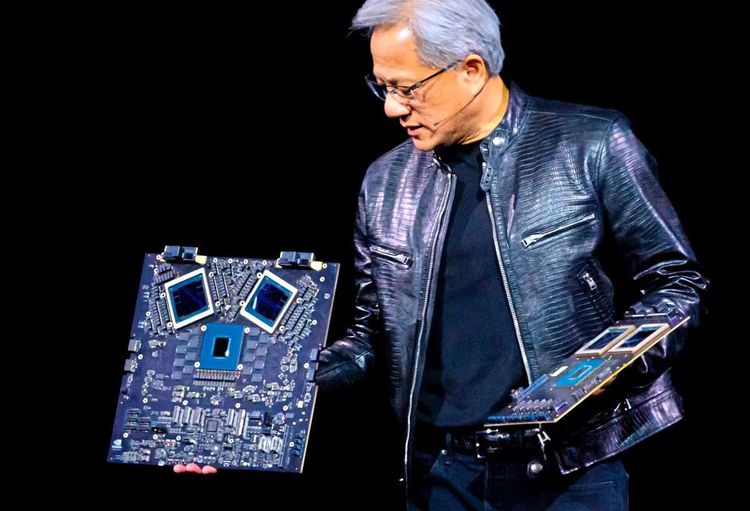

Auch wenn die Szenerie an ein Popkonzert erinnerte, stand nicht Taylor Swift auf der Bühne, sondern Jensen Huang in seiner typischen schwarzen Lederjacke. Nvidia hat seinen neuen Chip Blackwell B200 vorgestellt, mit dem der Halbleiterhersteller seine Rolle als das Hardware-Rückgrat der künstlichen Intelligenz (KI) weiter stärken will. Konzernchef Jensen Huang enthüllte das neue Flagschiffprodukt am Montag auf der Messe GTC 2024 in einer vollgepackten Eishockey-Arena im Silicon Valley, die für erwartete 16.000 Teilnehmer umgebaut worden war. Man erwarte Amazon, Alphabet, Meta, Microsoft, OpenAI und Tesla als Kunden, sagte Huang. Zudem gab er Partnerschaften mit den Software-Unternehmen Ansys, Cadence und Synopsys bekannt.

Die nach dem Mathematiker David Blackwell benannte Plattform löst die Hopper-Reihe von 2022 ab, die ihren Namen von der Computerpionierin Grace Hopper erhielt. Mit ihr baute der Konzern seinen Marktanteil im vergangenen Jahr auf etwa 80 Prozent aus. In ersten Reaktionen sagten Experten weitere Erfolge mit Blackwell voraus. "Wir gehen davon aus, dass Nvidia nicht nur weiterhin führen wird, sondern den Abstand zu seinen Konkurrenten im Bereich KI vergrößern wird", sagte Kinngai Chan von Summit Insights nach der Ankündigung. Nvidias Aktien haben in den vergangenen zwölf Monaten um 240 Prozent zugelegt. Dadurch stieg die Firma zur Nummer drei unter den "Glorreichen Sieben" der größten US-Technologiekonzerne auf. Am Montag lagen sie nach Börsenschluss zunächst 1,2 Prozent im Minus.

Zwei- bis 30-mal so schnell

Die B200 präsentiert sich als zwei verbundene Chips etwa in der Größe eines seiner Vorgänger, die jedoch funktionell eine Einheit bilden. Die beiden Chips sollen mit bis zu 10 Terabyte pro Sekunde miteinander kommunizieren können. Die Zahl der Transistoren liegt bei 208 Milliarden und damit mehr als doppelt so hoch wie bei Hopper. Blackwell soll zwischen zwei- und 30-mal so schnell sein wie der Vorgänger, je nach Benchmark. Huang holte aber noch weiter aus: Für die Entwicklung des GPT-MoE-1.8T-Modells waren 8.000 GPUs 90 Tage lang beschäftigt, und das Vorhaben hat 15 Megawatt Strom verbraucht. Mit Blackwell sollen nur noch 2.000 GPUs nötig sein und der Stromverbrauch auf ein Viertel sinken.

"Blackwell-GPUs sind der Motor für diese neue industrielle Revolution", so Huang. Dass es nicht allzu schwer sein dürfte, die Branchengrößen im KI-Sektor vom neuen Chip zu überzeugen, liegt vor allem daran, dass Nvidia aktuell am Markt nahezu konkurrenzlos ist. Nicht ohne Grund werden in der Pressemitteilung des Unternehmens acht CEOs zitiert, dazu gehören Sam Altman von OpenAI, Satya Nadella (Microsoft), Alphabe Sundar Pichai (Alphabet), Mark Zuckerberg (Meta), Google-Deepmind-CEO Demis Hassabis, Oracle-Chef Larry Ellison, Michael Dell (Dell) und Elon Musk (Tesla).

Enorme Umsätze, unstillbare Nachfrage

Nvidia hat nicht bekanntgegeben, wie viel die neuen Blackwell-Chips kosten werden. Die H100-Chips von Nvidia kosten laut CNBC derzeit zwischen 25.000 und 40.000 Dollar, wenn sie denn überhaupt verfügbar sind, denn die Nachfrage erscheint aktuell unersättlich. So hat Microsoft für den ChatGPT-Entwickler OpenAI einen Hochleistungscomputer aus 10.000 Nvidia-Chips gebaut. Pro Quartal verkaufte Nvidia im letzten Geschäftsjahr rund eine halbe Million Exemplare des H100, wobei auch Meta zu den Großkunden zählen dürfte. Mark Zuckerberg hat bereits angekündigt, dass sein Unternehmen 350.000 H100-Chips einsetzen wird, wobei noch 600.000 ähnliche GPUs dazukommen.

Allein im abgelaufenen Quartal erzielte Nvidia einen Umsatz von 14,5 Milliarden US-Dollar im Datacenter-Bereich. Der Grafikkarten-Markt für Konsumenten macht nur noch rund zwölf Prozent des Gesamtumsatzes aus. Im Vorjahr kam es zur Wartezeiten von bis zu elf Monaten bei den H100-Chips.

Robotik und NIM

Nvidia hat außerdem eine neue Reihe von Tools für Automobilhersteller vorgestellt. Das Unternehmen war nämlich vor dem KI-Hype bereits bedeutend im Bereich der Robotik. Darüber hinaus stellte das Unternehmen Nvidia NIM vor. Dabei handelt es sich um eine Softwareplattform, die das Erschaffen von KI-Anwendungen vereinfachen soll. NIM unterstützt Modelle aus verschiedenen Quellen, darunter Nvidia, Google und Hugging Face, und lässt sich mit Plattformen wie Amazon Sagemaker und Microsoft Azure AI integrieren. NIM wird seine Fähigkeiten im Laufe der Zeit erweitern, einschließlich Tools für generative KI-Chatbots.

Nvidia will auch den Einsatz sogenannter "digitaler Zwillinge" vorantreiben, in denen Unternehmen ihr gesamtes Geschäft im Computer simulieren können. Bevor man etwas in der realen Welt baut, werde man es künftig zunächst digital simulieren, betonte Huang.

Mit diesem Konzept macht Nvidia auch Apples Computerbrille Vision Pro nützlicher für den Einsatz in Unternehmen. Nvidias 3D-Umgebung Omniverse, mit der Firmen "digitale Zwillinge" ihrer Produkte und Fabriken erstellen können, kommt auf das Apple-Gerät. Die Technologie wird oft bei der Gestaltung von Objekten verwendet. Huang demonstrierte sie am Montag bei der hauseigenen Entwicklerkonferenz GTC unter anderem am Beispiel des südkoreanischen Autobauers Hyundai.

So konnte ein Designer verschiedene Farbvarianten eines Automodells in unterschiedlichen Umgebungen ansehen - und sich auch virtuell ans Lenkrad setzen. Apple will mit der 3.499 Dollar (rund 3.200 Euro) teuren Vision Pro einen sogenannten "räumlichen Computer" etablieren, mit dem man sich digitale Inhalte auch innerhalb der realen Umgebung anzeigen lassen kann.

Nvidia setzt auch auf Roboter. "Alles, was sich bewegt, wird robotisch sein", sagte der Firmenchef. Das Ziel sei, dass Roboter allein schon dadurch lernen können, dass sie Menschen beobachten. "Der ChatGPT-Moment für Robotik könnte unmittelbar bevorstehen", sagte Huang. Eine zentrale Rolle sollen dabei Simulationen spielen, in denen Roboter für die reale Welt lernen.

"Alles, was man digitalisieren kann: Solange es eine Struktur gibt, auf die wir einige Muster anwenden können, bedeutet das, dass wir die Muster lernen können", sagte Huang. "Und wenn wir die Muster lernen können, können wir auch die Bedeutung verstehen. Wenn wir die Bedeutung verstehen, können wir sie auch generieren. Und hier sind wir, bei der generativen KI-Revolution." (APA, pez, 19.3.2024)