Künstliche Intelligenz (KI) neigt gelegentlich dazu zu "halluzinieren" – also Informationen zu erfinden, die es nicht gibt, und diese trotzdem überzeugend auszugeben. So können KI-Tools wie ChatGPT oder Google Gemini zwar bei den Hausübungen helfen, indem sie zum Beispiel einen fertigen Aufsatz über ein historisches Ereignis abliefern, inhaltlich korrekt muss dieser aber nicht unbedingt sein.

Während in der Schule aber bloß eine Rüge oder eine schlechte Note wartet, kann dies zu echten Sicherheitsproblemen führen, wenn die KI Programmcode oder Anleitungen zum Entwickeln von Software schreibt und dieser ungeprüft übernommen werden, wie das Fachmedium "The Register" mit Berufung auf Bar Lanyado, Sicherheitsforscher bei Lasso Security, schreibt.

Großangelegte Analyse

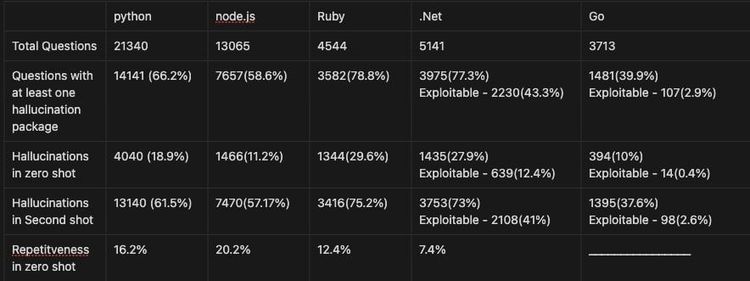

Generative KI tendiert demnach dazu, Softwarepakete zu erfinden, die es gar nicht gibt, und diese in die Antworten einzubauen. Dies war Lanyado bereits zuvor in einzelnen Fällen aufgefallen, nun führte er eine quantitative Analyse durch: Er sammelte 2.500 Fragen zu über 100 Themen in Bezug auf fünf Programmiersprachen (Python, Node.js, Go, .Net und Ruby).

Nach einem Ausfiltern kam er schließlich auf 47.803 Fragen, mit deren Beantwortung vier unterschiedliche KI-Modelle – GPT-3.5, GPT-4, Gemini Pro und Coral (Cohere) – beauftragt wurden.

Gemini ist Schlusslicht

Das Ergebnis ist, dass GPT-3.5 durchschnittlich bei 22,2 Prozent der Anfragen halluzinierte Pakete ausspuckten, bei GPT-4 sind es gar 24,4 Prozent. Cohere kommt auf 29,1 Prozent halluzinierte Softwarepakete.

Das Schlusslicht bildet aber Googles Gemini: Hier wurden bei 64,5 Prozent der Anfragen Pakete erfunden, die es nicht gibt. Die Bandbreite der Fehlerquoten über die Programmiersprachen hinweg reicht von 39,9 Prozent bei Go bis 78,8 Prozent bei Ruby.

Das Sicherheitsproblem liegt nun darin, dass Kriminelle den verwendeten Code analysieren und anschließend anstatt der inexistenten Packages eigene Pakete mit der gleichen Bezeichnung anlegen könnten, um auf diesem Weg Schadcode in die Anwendungen einzuschleusen. Oftmals wiederholten sich die fehlerhaften Aussagen auch in Lanyados Analyse, was es Hackern entsprechend leichter macht, im Code nach ihnen zu suchen.

Fallbeispiel Alibaba

Dass dies nicht nur graue Theorie ist, verdeutlicht der Sicherheitsforscher ebenfalls. So soll der chinesische Konzern Alibaba einen Befehl zum Download des Python-Paketes "huggingface-cli" in seinen auf Github veröffentlichten "Graph Translator" integriert haben, das Installationskommando ist allerdings fehlerhaft.

Lanyado konnte im Test diese Schwachstelle nutzen, um probeweise ein ungefährliches Paket einzuschleusen. Laut dem Bericht von "The Register" verzeichnete dieses innerhalb von drei Monaten 15.000 Downloads. Alibaba hat auf eine Anfrage des Mediums nicht reagiert. (stm, 2.4.2024)