Jeder Hype hat seinen Zyklus. Auf eine erste Phase der meist eher unreflektierten Begeisterung folgen erste Zweifel und irgendwann das Zusammentreffen mit der Realität. Die kann entweder einen kompletten Zusammenbruch bescheren oder auch einfach nur eine etwas angemessenere Bewertung der realen Möglichkeiten und Gefahren einer neuen Technologie. Wie lange dieser Zyklus dauert, hängt dabei nicht zuletzt davon ab, wie groß die anfängliche Begeisterung ist – oder auch: wie lange mahnende Stimmen übertönt werden.

Der von ChatGPT losgetretene Hype rund um das, was landläufig als Künstliche Intelligenz bezeichnet wird, war dermaßen stark, dass es ziemlich lange gedauert hat, nun scheint aber auch bei diesem Thema der anfängliche Magie-Glaube langsam einer etwas nüchterneren Betrachtung zu weichen – und der Erkenntnis, dass es noch viel zu tun gibt.

Eine Wette auf die Zukunft

Während große Cloud-Anbieter wie Microsoft oder Google derzeit keine Grenzen zu kennen scheinen, wenn es darum geht, in KI zu investieren, ist der Erfolg dieser Initiativen bisher überschaubar. Wie The Information unlängst berichtete, haben mittlerweile sämtliche große Anbieter ihre Umsatzerwartungen für den Verkauf von generativer KI auf Basis von sogenannten großen Sprachmodellen (LLMs) deutlich reduziert.

So betonte Amazon, wo man mit AWS den größten Cloud-Service bedient, vor einigen Wochen, dass das Potenzial von KI zwar "riesig", aber auch der erwartbare, kurzfristige Umsatz sehr gering sei. Bei Google ist man wohl auch dank der eigenen Workspace-Tools und der generell starken Positionierung im Bereich KI zwar etwas optimistischer. Die eine Milliarde Dollar Umsatz, die das Unternehmen für das laufende Jahr in Nordamerika mit dem Verkauf von KI generieren will, verblasst gegenüber anderen Google-Geschäftsbereichen aber. Zumal das alles in keiner Relation zu den aktuellen – und massiven – Kosten für Betrieb und Training dieser Systeme steht.

Wozu das alles?

Eine Realität, die sich dabei zeigt: Viele mit Diensten wie Microsoft Copilot oder Gemini for Google Workspace umworbene Firmen haben schlicht keine Ahnung, was sie damit eigentlich anfangen sollen – und ob sich die doch recht teuren Zusatzdienste für sie überhaupt rentieren.

"Bieten uns diese Services einen Mehrwert?" "Woher wissen wir, ob sie gute Antworten liefern?" "Wie bewerten wir, wie sich das schlägt?" Alles Fragen, die sich derzeit viele Firmen stellen, erzählt Ali Ghodsi, Chef der Firma Databricks. Ghodsi weiß dabei sehr gut, wovon er spricht, verkauft sein eigenes Unternehmen doch Software an große Firmen, die diesen bei der Entwicklung von KI helfen soll. "Ich glaube, die Leute waren letztes Jahr übermäßig begeistert", meint Ghodsi mit dem Blick auf die eilige Implementation von ChatGPT-artigen Technologien in Unternehmen.

Unsicherheitsfaktoren

Der schwer quantifizierbare Nutzen bei einem relativ hohen Preis ist dabei derzeit ein zentraler Unsicherheitsfaktor. So verlangt Microsoft pro User 30 Dollar monatlich für die Nutzung von Copilot im Firmenumfeld. Nun bekommen zweifellos viele Unternehmen Vergünstigungen, trotzdem ist das eine ordentliche Investition, wenn man nicht so recht weiß, wohin damit.

Dann wäre da noch die Sache mit den "Halluzinationen". Wie sich mittlerweile herumgesprochen haben sollte, erfinden solche Systeme gerne mal Informationen – das dafür aber sehr überzeugend. Nun kann man solche Dinge in Bereichen, wo es keiner exakten Präzision bedarf, als (wenn auch üblicherweise sehr klischeebehaftete) "Kreativität" abtun, etwa bei der Erstellung von Bildern oder harmlosen Texten. Bei anderen Aufgaben ist das hingegen ein echtes Problem, gerade wenn es um die Suche nach exakten Informationen geht oder gar die Auswertung von Firmendaten.

Apropos: Die Analyse von großen Datensätzen ist an sich eine der zentralen Stärken von LLMs, immerhin ist die Mustererkennung der Kern solcher Systeme. Interessant ist dabei, was Techcrunch unlängst von der Google Cloud Next, Googles zentrale Cloud-Konferenz, berichtete. Nämlich dass so manche Firma nun realisiert, dass die Qualität solcher Services massiv davon abhängt, wie gut das Ausgangsmaterial ist. Das heißt für Firmen, dass es eben nicht reicht, irgendwie alles an internen Informationen in ein LLM zu werfen und zu hoffen, dass das schon passt. Sondern dass die Daten zuvor sehr gut organisiert sein sollten – und dass das wiederum ziemlich aufwendig ist.

Das Ende von Big Tech? Ganz im Gegenteil ...

Dass der riesige Ressourcenaufwand mächtiger KI-Systeme große Plattformanbieter implizit bevorzugt, sollte eigentlich selbsterklärend sein. Trotzdem wurde im Überschwung der ersten Begeisterung – und wohl auch wegen des für knackige Schlagzeilen verlockenden Narrativs – im Vorjahr so manch Theorie aufgestellt, dass der KI-Umbruch das Ende der Vorherrschaft der aktuellen Big-Tech-Konzerne bedeuten könnte. Dass das schon damals wenig Sinn ergab und ausgerechnet das von Microsoft finanziell getragene OpenAI als Paradebeispiel herhalten musste, ist das eine. Das andere ist, dass die Realität im Jahr 2024 nicht weiter davon entfernt sein könnte.

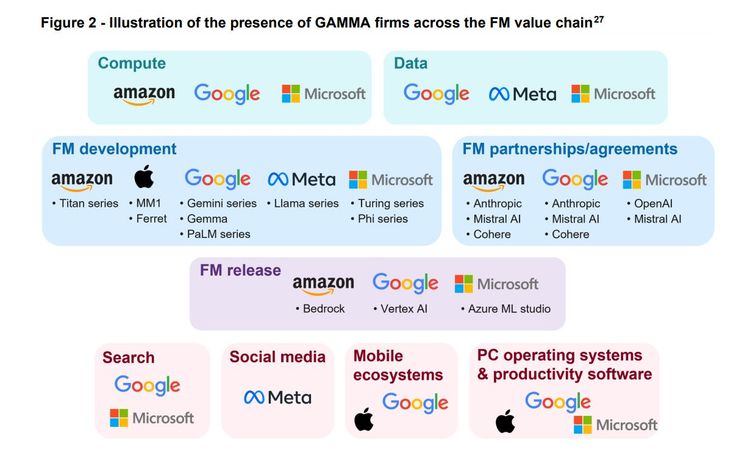

Vor wenigen Tagen warnte die britische Competition and Markets Authority (CMA) vor der wachsenden Dominanz von Big Tech in so gut wie allen Bereichen rund um generative KI. Ob bei der Entwicklung von Modellen, der Bereitstellung der Infrastruktur oder auch beim Vertrieb: Überall haben einmal mehr die gleichen fünf GAMMA-Firmen ihre Finger bestimmend im Spiel, die die Branche seit Jahren dominieren: Google, Amazon, Microsoft, Meta und Apple.

Ob Anthropic, Cohere oder auch das europäische Mistral: Hinter den meisten neuen Firmen in diesem Bereich stehen große Investments der dominanten Cloud-Betreiber – meist gleich von mehreren davon. Sie sichern sich damit nach allen Richtungen ab, um ja keinen Trend, keinen technologischen Durchbruch zu verpassen.

Start-ups auf der Suche nach Einnahmen

Doch während die Cloud-Anbieter KI als logische Erweiterung ihrer bestehenden Services verkaufen können, tun sich viele Start-ups noch schwer damit, ein auch nur ansatzweise tragfähiges Geschäftsmodell zu entwickeln – also jenseits des vom Hype hereingeschwappten Risikokapitals. Und auch da zeigen sich die Bruchlinien immer stärker.

So war Stability AI Ende 2022 noch so etwas wie der Darling der Branche. Die offene Entwicklung jenseits der Tech-Giganten brachte viel Applaus ein. Davon ist mittlerweile nichts mehr zu sehen, die Firma ist zuletzt regelrecht implodiert. Nach diversen Kontroversen und dem Abgang zentraler Forscher hat der zuvor gefeierte Firmengründer Emad Mostaque im März die Notbremse gezogen und seinen Rückzug verkündet. Insider sprechen in diesem Zusammenhang von einer regelrechten Todesspirale, in der sich die Firma befinde. Und auch wenn man natürlich noch nicht aufgeben will, so scheint die Zukunft mehr als ungewiss.

Eine ziemlich seltsame Geschichte

In vielerlei Hinsicht bemerkenswert ist die Geschichte von Inflection AI: Von Deepmind-Co-Gründer Mustafa Suleyman initiiert, schienen die Voraussetzungen geradezu perfekt – ist doch Deepmind jene Firma, die Google vor einigen Jahren übernommen hat und auf deren Know-how die KI-Macht des Suchmaschinenanbieters zu weiten Teilen basiert.

Mit einem eigenen Chatbot namens Pi wollte Inflection AI Google und OpenAI den Rang ablaufen. Dass dieser in ersten Tests kaum anders als ChatGPT oder Bard abschnitt, tat der Begeisterung keinen Abbruch. Die Firma konnte bei einer Bewertung von vier Milliarden immerhin 1,5 Milliarden Dollar an Finanzierung einstecken. Vor kurzem dann die Nachricht, dass Suleyman zu Microsoft wechselt, um künftig dessen KI-Abteilung zu leiten. So weit nicht ungewöhnlich, gerade im KI-Bereich gibt es derzeit ein reges Abwerben zentraler Personen.

Versteckte Übernahme?

Für einige Irritation sorgten aber die Begleittöne. Im Rahmen des Deals zahlt Microsoft nämlich 650 Millionen US-Dollar an Inflection AI, damit dieses die eigenen Modelle auf Azure, also dem Cloud-Dienst von Microsoft, anbietet. Wie es mit dem Start-up weitergeht, bleibt unklar. So mancher Beobachter ist angesichts des Ablaufs gar davon überzeugt, dass es sich dabei in Wirklichkeit um eine versteckte Übernahme handle. Eine, die den entscheidenden Vorteil hat, dem zunehmend kritischer werdenden Auge der Regulatoren zu entgehen.

Eine große, unabhängige Zukunft lässt all das jedenfalls nicht erwarten. Allgemein ist allerdings die Frage, wie viele der KI-Start-ups überhaupt auf langfristige Eigenständigkeit abzielen, wie viele in Wirklichkeit auf einen gewinnbringenden Exit durch den Verkauf an eine der Branchengrößen hoffen. Das ist freilich ein Phänomen, das nicht nur auf die KI-Sparte beschränkt ist.

Chatbots stagnieren

Doch es gibt noch weitere Anzeichen einer – gewissen – Abkühlung des Hypes. Da wäre etwa der Umstand, dass Chatbots zwar eine durchaus signifikante Fangemeinde haben, deren Größe aber auch stagniert. Wie Investor und KI-Experte Nat Friedman auf X verdeutlicht, hat sich bei den Nutzungszahlen von ChatGPT seit einem Jahr praktisch nichts getan, die Zahl der monatlich aktiven User bewegt sich stabil um die 55 Millionen herum. Zugelegt hat zwar kontinuierlich Googles Bard und zuletzt dessen Nachfolger Gemini, am Gesamtbild ändert das aber recht wenig.

Bei OpenAI dürfte man aber gerade noch andere Sorgen haben: Der mit Spannung erwartete Start eines eigenen Chatbot-Stores hat sich zu einem veritablen Flop entwickelt. Wie The Information vor einigen Wochen berichtete, klagen Entwickler mittlerweile darüber, dass es kaum User gebe – und dass es sich so anfühlt, als habe OpenAI den GPT Store schon wieder aufgegeben.

Vorsicht

Angesichts all dessen darf es eigentlich nicht verwundern, dass die Investoren langsam etwas vorsichtiger beim Thema KI werden: Die erste Welle an Begeisterung weiche zunehmend der Realität, dass KI noch viele Herausforderungen vor sich habe – sowohl technische als auch in Hinblick auf die Vermarktbarkeit –, und es noch Jahre dauern werde, bis diese vollständig überwunden sind, formuliert es Umesh Padval von Thomvest Ventures gegenüber Techcrunch.

Andere Investoren wie Aaron Fleishman von Tola Capital verweisen wiederum darauf, dass man sich zu sehr auf "prognostiziertes exponentielles Wachstum" verlassen habe, um die extrem hohen Bewertungen von KI-Start-ups zu rechtfertigen. Firmen wie Stability AI seien da ein warnendes Beispiel: Dieses sei bereits Ende 2022 mit einer Milliarde Dollar bewertet worden, nur um dann im Jahr 2023 gerade einmal elf Millionen US-Dollar an Umsatz zu generieren. Das übrigens bei Betriebskosten in der Höhe von 153 Millionen US-Dollar.

Bewertungen

Zahlen, die auch nicht untypisch sind. Cohere nennt sich selbst die führende Plattform für Enterprise AI und ist damit tatsächlich einer der bekanntesten OpenAI-Konkurrenten. Bisher gelang es der Firma denn auch, satte 445 Millionen US-Dollar von Investoren einzusammeln. Der Umsatz im Jahr 2023: 13 Millionen Dollar.

Das hält Cohere aber nicht davon ab, weiter hoch mit dem KI-Hype zu pokern, derzeit sucht man nach neuen Investoren bei einer Bewertung von sechs Milliarden Dollar – dem 450-Fachen des Umsatzes. Und damit steht man nicht allein da, das französische KI-Unternehmen Mistral will nun neues Kapital bei einer Bewertung von fünf Milliarden Dollar einsammeln. Wer hier investieren wird, kann man sich in etwa ausmalen.

Bei all dem bleibt eine der zentralen Fragen weiterhin unklar, nämlich an welcher Stelle sich KI künftig überhaupt monetarisieren lassen wird. Also etwa, ob es überhaupt einzelne Modelle oder Entwicklungen sein werden, die sich zu Geld machen lassen, oder ob es doch eher die Infrastruktur dahinter ist. Die aktuelle Entwicklung weist eher auf die zweite Option hin.

So viele ungeklärte Fragen und Probleme

Apropos offene Fragen: Von diesen gibt es auch mehr als ein Jahr nach der Explosion des KI-Hypes immer noch unzählige. Neben dem schon erwähnten Problem der Halluzinationen wäre da der weiterhin riesige Ressourcenverbrauch zu nennen, und natürlich sind auch viele rechtlichen Fragen mit Blick auf das verwendete Trainingsmaterial weiterhin ungeklärt. Von den gesellschaftlichen Auswirkungen ganz abgesehen.

So zeigt sich etwa, dass generative KI zunehmend das Netz mit zweifelhaften bis falschen Inhalte flutet und so auch der Qualität der Ergebnisse in klassischen Suchmaschinen Schaden zufügt. Eine Antwort darauf scheint bisher noch niemand zu haben. Genauso wenig wie auf die Frage, wie es weitergehen soll, wenn immer mehr neue KI auf Basis der Ausgaben anderer KI trainiert wird und so die Ergebnisse immer schlechter werden: ein Phänomen, für das übrigens unter Expertinnen und Experten der etwas böse Begriff "Habsburg AI" kursiert.

Zudem gibt es derzeit wachsende Zweifel daran, dass immer größer werdende Large Language Models überhaupt noch substanziell besser werden. Anders gesagt: Es könnte für eine rasche Weiterentwicklung im Bereich KI zunehmend neue Ansätze brauchen als das bisher oft forcierte "Mehr und größer".

Eine notwendige Klarstellung

All das soll übrigens nicht heißen, dass es sich bei KI um einen kurzfristigen Hype handelt, der bald wieder vorbei ist. Ganz und gar nicht. Die dahinterstehenden Technologien waren vorher schon wichtig, sind durch den Hype noch wichtiger geworden und werden in Zukunft die Basis vieler – mal mehr, mal weniger sinnvoller – neuer Funktionen bilden, die in unser aller Leben einfließen.

Wie schnell das geht, ist dann noch einmal eine andere Frage. Aber etwas Ruhe würde der gesamten Branche ohnehin guttun. Im Vorjahr haben viele Firmen mit Blick auf den großen Hype und unter Druck des Aktienmarktes irgendwie alles veröffentlicht, was ihnen in den Sinn gekommen ist. Was vielleicht auch erklären könnte, warum diese Funktionen bei Firmen bisher noch nicht den ganz großen Anklang gefunden haben.

Wenn auf dieser Basis nun langsam aussortiert wird, was davon wirklich hilfreich ist, und vor allem neue, durchdachtere Tools entstehen, dann ist das auch langfristig definitiv ein Fortschritt. (Andreas Proschofsky, 20.4.2024)