Wer nicht möchte, dass seine Daten durch die Nutzung von ChatGPT weiterverwendet werden, kann jetzt aktiv etwas dagegen unternehmen.

Es gibt viele Gründe, warum man ChatGPT gesunde Skepsis entgegenbringen sollte. Anfangs waren es noch veraltete Datensätze, die schlichtweg keine Antworten zu aktuellen Fragen liefern konnten. Nach und nach stellte sich aber heraus, dass der Chatbot auch sonst gerne zu "Halluzinationen" neigt, wie KI-Forscher es höflich formulieren. Im ordinären Sprachgebrauch könnte man es auch als "Unwahrheiten" oder "Lügen" bezeichnen.

Entwickler OpenAI gibt an, dass seine umfangreichen Sprachmodelle mittlerweile aus drei Hauptquellen Informationen beziehen: dem Internet, lizenzierten Daten von anderen Quellen und den Informationen, die Menschen ihm in Chat-Konversationen liefern. Und genau hier liegt das Problem: Selbst wenn man es als Nutzerin oder Nutzer beispielsweise noch nicht bemerkt haben sollte, dass sich der Chatbot in jedem der als Antwort verpackten Absätze immer wieder gerne wiederholt, so sind jegliche – bleiben wir dabei – "Halluzinationen" umso gefährlicher, je mehr persönliche Informationen der Chatbot erhält.

Vorsicht geboten

Dass es ChatGPT mit der Wahrheit zu realen Personen nicht immer ganz genau nimmt, zeigten zuletzt zwei Beispiele, die durch die Medien gegangen sind. In einem Fall beschuldigte der Chatbot einen Rechtswissenschafter aus den USA fälschlicherweise der sexuellen Belästigung und belegte dies mit Zeitungsartikeln, die es nie gab. Davor wurde ein australischer Bürgermeister von ChatGPT als Schuldiger in einem Bestechungsskandal genannt, den er eigentlich aufgedeckt hatte. Auch große Unternehmen wie Samsung sind besonders vorsichtig geworden und verbieten derzeit sogar den Gebrauch von ChatGPT.

Will man mit dem Chatbot experimentieren oder ihn gar regelmäßig verwenden, ist man in erster Linie gut beraten, sich bei der Preisgabe persönlicher Informationen möglichst einzuschränken. Seit kurzem gibt es aber auch zwei weitere Möglichkeiten, wie man sensible Daten von ChatGPT entfernen kann. Zumindest theoretisch. Aufgrund der Prüfung der italienischen Datenschutzbehörde und der zwischenzeitlichen Sperre von ChatGPT in Italien hat das Unternehmen seit Ende April nämlich Tools und Prozesse eingeführt, die den Nutzern mehr Kontrolle über einige ihrer Daten geben.

Davor: Der Gesprächsverlauf, den es nie gab

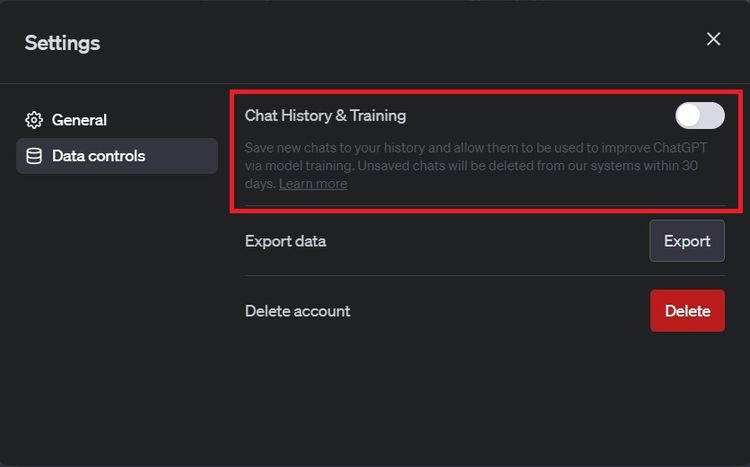

Standardmäßig können die Unterhaltungen, die mit ChatGPT geführt werden, von OpenAI als Trainingsdaten für zukünftige große Sprachmodelle verwendet werden. Das heißt, theoretisch könnten diese Informationen in die Beantwortung künftiger Fragen durch das Modell einfließen. Allerdings hat OpenAI mit 25. April eine Einstellung eingeführt, die es jedem ermöglicht, diesen Prozess zu stoppen. Man kann also im Vorfeld darüber entscheiden, ob die Unterhaltungen für das Training verwendet werden oder nicht.

Um die Aufnahme in das Training zu verhindern, genügen wenige Mausklicks. Ist man bei ChatGPT angemeldet, muss man lediglich auf das Benutzerprofil in der linken unteren Ecke des Bildschirms klicken. Navigiert man nach "Settings" auf "Data controls", lässt sich im Pop-up-Fenster rechts oben der Chatverlauf deaktivieren.

OpenAI weist darauf hin, dass die Deaktivierung des Chatverlaufs "nicht zum Trainieren und Verbessern unserer Modelle verwendet wird". Dennoch werden die Daten 30 Tage lang aufbewahrt, "um sie auf Missbrauch zu prüfen", ehe sie permanent gelöscht werden. In der Standardansicht von ChatGPT sollte links oben der Hinweis zu sehen sein, dass der Chatverlauf deaktiviert ist. Mittels Schaltfläche in der Seitenleiste lässt sich diese Entscheidung jederzeit rückgängig machen.

Danach: Das Formular

Wer ChatGPT bereits mit sensiblen Daten gefüttert haben sollte, kann als Europäer (oder Japaner) auch im Nachhinein eine Löschung der Daten beantragen. Dafür hat OpenAI nämlich ein eigenes Formular eingeführt.

Das Formular zielt in erster Linie darauf ab, Informationen aus Antworten zu entfernen, die ChatGPT den Nutzerinnen und Nutzern gibt, und nicht aus den Trainingsdaten. Es erfasst Informationen wie Namen, E-Mail-Adresse, Herkunftsland, ob der Antrag im Auftrag einer anderen Person gestellt wird und ob die Betroffenen Personen des öffentlichen Lebens (= Prominente) sind.

Es kommt noch besser: Anschließend fordert OpenAI Beweise dafür, dass seine Systeme die betroffene Person erwähnt haben. Das Unternehmen verlangt "relevante Eingabeaufforderungen", die zur Erwähnung geführt haben, sowie Screenshots, die das belegen. Das Unternehmen erklärt auch, dass solche klaren Beweise erforderlich sind, um Anfragen ordnungsgemäß bearbeiten zu können.

Hat man dieses Prozedere durchlaufen, ist eine Löschung dennoch nicht fix. OpenAI behält es sich nämlich vor, dass es "Privatsphäre und freie Meinungsäußerung" gegeneinander abwägen wird, wenn es Entscheidungen über Löschanträge von Personen trifft. "Einzelpersonen haben auch das Recht, auf ihre persönlichen Daten, die in unseren Schulungsinformationen enthalten sind, zuzugreifen, sie zu korrigieren, einzuschränken, zu löschen oder zu übertragen", heißt es auf der Seite des Hilfezentrums von OpenAI. Dazu wird auch empfohlen, sich per E-Mail an den Datenschutzbeauftragten zu wenden: dsar@openai.com. Natürlich ist es zu begrüßen, dass es solche Möglichkeiten gibt. Sie zeigen aber auch auf, dass man sich umso besser überlegen sollte, welche Informationen man mit ChatGPT teilen will. (bbr, 10.5.2023)