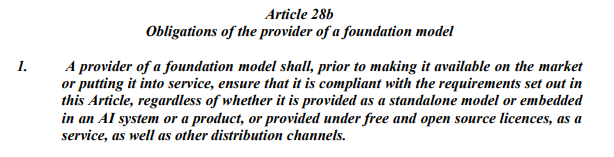

Am 14. Juni haben sich die Abgeordneten des Europaparlaments auf ihre Position zum AI Act geeinigt – jenes EU-Regelwerk, das den Umgang mit künstlicher Intelligenz in Europa regulieren soll. Frei von Kritik an ihr ist die aktuelle Fassung nicht: So bemerken Expertinnen und Experten einen Passus – konkret den Artikel 28b –, bei dem Bereitsteller sogenannter Foundation-Modelle für ihre Werke diverse Auflagen erfüllen und für die Nichteinhaltung zur Verantwortung gezogen werden können. "Dabei wird nicht zwischen kommerziellen Produkten und Open Source unterschieden", sagt Jeannette Gorzala, Vizepräsidentin des Europäischen AI-Forums. Ganz im Gegenteil: Es werde sogar explizit betont, dass auch kostenlose und unter Open-Source-Lizenzen bereitgestellte Lösungen unter diese Regelung fallen.

Unter Foundation-Modellen versteht man Modelle, die nicht einem spezifischen Zweck dienen, sondern allgemeine Grundkompetenzen einer KI beinhalten. Also zum Beispiel nicht die für selbstfahrende Autos nötige spezifische Objekterkennung von Verkehrsteilnehmern, aber allgemeine Objekterkennung in Bildern. Diese Modelle werden etwa von Start-ups zur Entwicklung von Prototypen genutzt, bevor diese spezifische Modelle für ihre Zwecke entwickeln.

Aus für Open Source

Unter offener Lizenz werden diese Modelle auch von Privatpersonen, Organisationen und vor allem Forschungseinrichtungen bereitgestellt – und diese können auf Basis des AI Act dafür zur Verantwortung gezogen werden, wie Bernhard Nessler, Research Manager Deep Learning & Certification am Software Competence Center Hagenberg, sagt. Eine Universität mit vergleichsweise wenig Budget muss also ähnlich gewappnet sein wie ein US-amerikanischer Tech-Konzern.

Nessler kritisiert unter anderem, dass der Entwickler eines Foundation-Modells nicht ausschließen kann, dass sein System anschließend für schädliche Zwecke verwendet wird – ähnlich wie ein Autohersteller nicht garantieren kann, dass das von ihm verkaufte Fahrzeug nicht für einen Bankraub verwendet wird. Die Verantwortung für das Modell solle somit nicht nur beim Bereitsteller des Modells, sondern auch bei den Anwendern und jenen liegen, die das Modell weiterentwickeln.

Planung für die nächsten Jahre

Folglich würden sich wissenschaftliche Institutionen und Organisationen künftig hüten, Foundation-Modelle frei zugänglich auf Plattformen wie Github zu laden – was in weiterer Folge ein Schlag gegen europäische Start-ups wäre, die im Feld der künstlichen Intelligenz Alternativen zu Anbietern aus Drittstaaten entwickeln wollen. Investoren werden zudem skeptisch sein und das Risiko eher scheuen, wenn ein europäisches Start-up dennoch mit derartigen Modellen arbeiten sollte.

Auch merkt Nessler an, dass es nach Finalisierung des AI Act vier bis fünf weitere Jahre dauern kann, bis derartige Fehler von der Legislative korrigiert werden. Nach Bekanntgabe der Position im EU-Parlament beginnen nun die Verhandlungen im Trilog zwischen den großen drei EU-Institutionen. Sie sollen bis Ende 2023 abgeschlossen sein, und Gorzala bestätigt im Gespräch mit dem STANDARD, dass die Branchenverbände in dieser Zeit noch stark lobbyieren werden.

Umgang mit Biometrie und ChatGPT

Im Vorfeld der Abstimmung hatte auch die Frage für Diskussionen gesorgt, ob die Echtzeitauswertung von biometrischen Daten – also etwa Gesichtserkennung – via KI erlaubt werden soll. Im öffentlichen Raum ist dies nun verboten, wohl aber erlaubt ist die nachträgliche Auswertung nach richterlicher Anordnung. Als Ausnahme für die Live-Auswertung von biometrischen Daten wird außerdem explizit der Grenzschutz genannt. Im Kontext von Asyl- und Migrationsthemen ist die Erkennung von Emotionen via KI zwar untersagt, der Einsatz von KI allgemein fällt aber in die Kategorie "High Risk": Der Einsatz ist also erlaubt, wenn auch unter strengen Auflagen.

Ein starker Fokus des AI Act liegt auch auf generativer KI, also auf Software, die so wie ChatGPT und Midjourney Texte und Bilder auf Befehl erstellt. Hier müssen die Anbieter künftig klar kennzeichnen, wenn KI im Spiel ist. Außerdem müssen sie ein transparentes Register darüber führen, mit welchen Daten die KI-Modelle trainiert wurden. Das soll es Kunstschaffenden erleichtern, auf Schadenersatz aufgrund von Verletzung des Urheberrechts zu klagen. (Stefan Mey, 16.6.2023)