Die Idee klingt zumindest nicht ganz verkehrt. Mit dem Berufsinfomat hat das Arbeitsmarktservice (AMS) am Mittwoch einen eigenen KI-Chatbot vorgestellt, der Arbeitssuchenden bei Fragen zu Jobmöglichkeiten hilfreich zur Seite stehen soll. Wie sich in den Stunden danach schnell herausstellen sollte, macht der Service dies auch und mag in manchen Teilen deshalb unzweifelhaft nützlich sein. Gleichzeitig ist aber auch schnell massive Kritik an der Umsetzung aufgekommen. Denn wie sich herausstellt, gibt es nicht nur offenbar eklatante Mängel bei der technischen Implementation des Dienstes – das Tool produziert auch eifrig Vorurteile.

Chatbots reproduzieren Vorurteile

Dass der Berufsinfomat auf dem bekannten Tool ChatGPT der Firma OpenAI basiert, ist dabei kein Geheimnis. Dies hatte das AMS bereits bei der Vorstellung bekannt und auch so beworben. Damit gehen aber auch all jene Probleme einher, die jeder kennt, der sich schon mal oberflächlich mit solchen KI-Tools beschäftigt hat

So reproduziert der Berufsinfomat allerlei Vorurteile. Fragt man etwa in der Rolle eines jungen Mannes nach Empfehlungen für passende Jobs, kommt schnell der Tipp, sich doch im Bereich der IT umzusehen. Bei der exakt selben Fragestellung aus der Perspektive einer Frau wird stattdessen ein Studium der Genderstudies empfohlen, ein paar Sätze später werden der Arbeitssuchenden Jobs im Gastgewerbe und Küche als Karriereoptionen empfohlen.

Eine zweifelhafte Reaktion

Einen entsprechenden Test einer X-Userin konnte DER STANDARD direkt so reproduzieren. In diesem Fall hat AMS-Chef Johannes Kopf auf der einst Twitter genannten Plattform sogar selbst reagiert. Die Probleme seien bekannt, erklärt Kopf. Der Bias sei dem Bot nicht so einfach abzugewöhnen, aber man habe schon viel weitergebracht und werde weiter dranbleiben.

Offen bleibt, wie das gehen soll, wenn es sich beim Berufsinfomat nur um eine minimal angepasste Version von ChatGPT handelt. In diesem Fall scheint der bekannte Chatbot mit ein paar zusätzlichen Daten gefüttert worden sein, zudem wurde der sogenannte System Prompt angepasst, der solchen Tools erzählt, wie sie sich verhalten sollen. Das heißt aber eben auch: Die Eingriffsmöglichkeiten des AMS sind enden wollend.

Spurensuche

Da solche Chatbots nicht allzu schwer auszutricksen sind, ist mittlerweile klar, wie die Anpassungen des System Prompts konkret aussehen. Das AMS hat ChatGPT ein paar recht simple Regeln mitgegeben. So soll immer korrektes Gendering bei allen Bezeichnungen verwendet werden, die Wörter Arbeitsagentur und Arbeitsamt sollen durch "AMS" ersetzt werden, und natürlich soll nicht zwischen Männern und Frauen bei Berufsempfehlungen unterschieden werden.

Ob das bereits das ist, was Kopf mit "schon viel gelungen" meint, bleibt zunächst unklar, klar ist angesichts des oben zitierten Beispiels aber, dass der Plan nicht aufgegangen ist. Das ist allerdings auch nicht überraschend. Ein solcher Bias kann bei KI-Chatbots nur schwer verhindert werden, er ist ihnen nämlich immanent – und das ist auch keine neue Erkenntnis.

Das Bias-Problem

Es liegt schlicht daran, wie all das funktioniert, steckt doch hinter ChatGPT keine Intelligenz im klassischen Sinne, diese Tools geben – vereinfacht gesprochen – einfach immer die statistisch wahrscheinlichsten Antworten, die sie aus jenem Material schließen, mit dem sie trainiert wurden. Und das ist bei ChatGPT nun einmal das Internet und viele andere Informationen, die allerlei Vorurteile enthalten.

Über diverse Tricks versuchen die Entwicklerinnen und Entwickler solcher Systeme diesen Bias abzugewöhnen, ganz gelingt das bisher aber nie. Das gilt auch für ein zweites bekanntes Problem dieser Tools: dass sie dazu neigen, Dinge schlicht zu erfinden, wenn sie keine passende Antwort haben.

Technische Defizite

Doch die Kritik beschränkt sich nicht auf bekannte Defizite solcher Systeme, auch die konkrete technische Umsetzung des Berufsinfomat wird zum Teil regelrecht zerrissen. So hat sich der Softwareentwickler Mario Zechner das Ganze einmal im Detail angesehen und lässt in mehreren Tweet-Serien kein gutes Haar an der Implementation.

Der – relativ einfach einsehbare – Code sehe aus, als wäre er selbst von einer KI geschrieben, weise bereits auf den ersten Blick zahlreiche grobe Fehler und potenzielle Sicherheitslücken auf. Tatsächlich haben andere findige User mittlerweile bereits diverse Lücken demonstriert. So kann der Chatbot etwa dazu gebracht werden, ein Pop-up darzustellen.

Zur Codequalität oder der Art der Erstellung will sich das AMS nicht äußern, in einer Stellungnahme gegenüber dem STANDARD betont man lediglich: "Es ist eine Entscheidung des Auftragnehmers, wie er sein Produkt entwickelt." In Bezug auf die erwähnte Sicherheitslücke heißt es wiederum: "Das Cross-Site-Scripting wurde im Rahmen der TÜV-Prüfung bei der Firma Goodguys.ai ebenso untersucht. Es war zu keinem Zeitpunkt möglich, dass ein Nutzer durch schädliche Eingaben die Ausgaben bei anderen Nutzern oder die Funktionalität des Servers kompromittieren konnte."

Wer will, kann die im Code gefundenen Informationen sogar nutzen, um darüber direkten – und uneingeschränkten – Zugriff auf ChatGPT zu erhalten, wenn auch nur in der GPT-3.5-Version. Das geht mit den entsprechenden Informationen etwa über ein recht simples Skript. Beim AMS sieht man darin kein Problem: "Hier wird kein API-Key von OpenAI an dieser Stelle verwendet oder offenbart. Der im Client ersichtliche Endpoint (AJAX URL) ist sichtbar, die Antworten jedoch sind ausschließlich in Bezug auf den Inhalt des AMS-Berufsinfomat möglich, dessen Inhalte öffentlich sind. Damit wird keine direkte Nutzung von OpenAI ermöglicht."

Sperren ausgehebelt

Wer den Berufsinfomat als normalen Chatbot nutzen will, der muss allerdings gar nicht so weit gehen, lassen sich die Sicherheitssperren des AMS-Tools doch bereits mit ein paar geschickt gestellten Fragen austricksen. Wer richtig formuliert, kann den Chatbot also sogar dazu bringen, Code zu erzeugen, etwas, das in vom AMS vorgegebenen Regeln ebenfalls untersagt ist. Oder aber man lässt sich Tipps zur Erlangung der Weltherrschaft geben, wie es der Ö1-Journalistin Sarah Kriesche gelungen ist.

Zukauf

Doch noch einmal zurück zur technischen Umsetzung: Beim Berufsinfomat handelt es sich augenscheinlich um eine "Von der Stange"-Lösung, die direkt von der Firma Goodguys.ai zugekauft wurde und die auch auf anderen Webseiten wie Basel.com zu finden ist – wo sogar im Code ein Hinweis auf das AMS zu finden ist, wie Webentwickler David Bopp aufgespürt hat. Auch das AMS nennt Goodguys.ai selbst als Partner, dessen Tool läuft dann auf den Servern des Bundesrechenzentrums (BRZ), wobei der Großteil der Last ohnehin an OpenAI ausgelagert wird.

Gegenüber dem STANDARD formuliert das AMS die eigene Sicht der Dinge so: "Die Basis ist ein KI-Tool von Goodguys (AI Concierge), das die Technologie von ChatGPT nutzt, und wurde für die Zwecke des AMS weiterentwickelt, damit punktgenau auf arbeitsmarktrelevante, berufs- und ausbildungsspezifische Daten zugegriffen wird. Der eigentliche Mehrwert des Berufsinfomat für Mitarbeiter_innen, Kund_innen und Interessierte am Arbeitsmarkt ist, dass nur dieser mit einer angepassten Logik auf AMS-Datensätze zugreift. Laufend werden die Daten aktualisiert, wodurch sich Informationen auch laufend verändern (zum Beispiel bis.ams.or.at, berufslexikon.at, ausbildungskompass.at; insgesamt knapp 100.000 Datenobjekte, Anm.), und in einem komplexen Verarbeitungsprozess werden sie dem AMS-Berufsinfomat zugeführt."

Und weiter zu den technischen Details: "Der AMS-Berufsinfomat ist ein auf Generative AI basierendes Chatsystem und nutzt Technologien wie Large Language Models (LLMs), Machine/Deep Learning, Python, Java, NoSQL, SQL und JS. Die Lösung besteht aus Client- als auch Server-Komponenten, wobei die Serverkomponenten sowohl hauptsächlich interne KI-Verarbeitungsprozesse als auch externe Services wie OpenAI nutzen. Die technische Basis bildet ein RAG (Retrieval-augmented generation)-Verfahren mit einer vor-/nachgeschalteten Verarbeitungspipeline. Erst als letzter Verarbeitungsschritt wird OpenAI ChatGPT 3.5T verwendet, um die Antwort auf Basis der ausgewählten Datenobjekte zu generieren. Der Client wurde im Rahmen der Anpassungen auf Barrierefreiheit, Responsiveness und Performance optimiert und neu designt."

Zechner bezeichnet das Tool abschließend als "AI Snakeoil", das offenbar irgendeine Agentur dem AMS für viel zu viel Geld – offiziell ist von rund 300.000 Euro die Rede – angedreht hat, weil man um jeden Preis innovativ wirken wollte. Eines, das noch dazu voller Vorurteile sei.

Beim AMS sieht man auf Nachfrage des STANDARD die Kosten als gerechtfertigt an: "Einerseits wurde für den Berufsinfomat neue Infrastruktur aufgebaut (zusätzliche Server). Andererseits fielen Kosten für Lizenzen, Entwicklung, Design, monatelangen Pilotbetriebmit rund 100 AMS-User_innen, Barrierefreiheit, Tests, laufende Aktualisierung und Betrieb des Systems an."

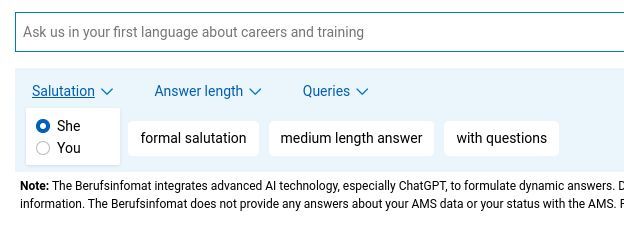

Dass beim Berufsinfomat tatsächlich nicht alles von Hand gemacht wurde, legt übrigens auch ein weiterer Umstand nahe. Wer die englische Sprachausführung nutzt, bekommt als Anredeoptionen "She/You" geboten. Das mag auf den ersten Blick wenig Sinn ergeben, bis klar wird, dass es sich dabei offenbar um eine automatische Übersetzung der Begriffe "Sie/Du" als Wahl zwischen förmlicher und persönlicher Ansprache handelt. Dass dies im Vorfeld niemandem aufgefallen ist, überrascht zumindest. Zumal ja das AMS betont, dass die Software im Vorfeld ausführlich getestet wurde, wie weiter oben nachzulesen ist.

Solche Tools werfen aber noch andere Fragen auf, etwa nach dem Datenschutz. Immerhin werden dadurch potenziell private Daten – also Dinge, die die Nutzerinnen und Nutzer an dieser Stelle eingeben – an OpenAI geliefert. Ein Problem sieht man beim AMS aber auch in diesem Fall nicht: "Der Berufsinfomat erhebt und verwendet grundsätzlich keine persönlichen bzw. personenbezogenen Daten; wir weisen den Nutzer auch an mehreren Stellen in hervorgehobener Formatierung darauf hin, dass dieser keine derartigen Daten eingeben soll", sieht man die Verantwortung bei den Usern.

Und weiter: "Es wurde im Vorfeld eine Datenschutz-Folgeabschätzung gemacht und risikominimierende Maßnahmen gesetzt. Die Folgeabschätzung hat Folgendes ergeben: 'Das System erhebt grundsätzlich keine Daten personenbezogen; sehr wohl können aber in den Anfragen persönliche und darunter auch personenidentifizierende Informationen als Fragebestandteil durch die Nutzer_innen angegeben werden, in welchen Fällen aufgrund eines sicherheits- und qualitätssicherungsnotwendigen Nutzungsloggings diese Informationen zwar verarbeitet, aber nicht personenbezogen abgelegt werden.'"

Vorgeschichte

Es ist nicht das erste Mal, dass das AMS seine liebe Not mit ambitionierten Softwareprojekten hat. So sorgte vor einigen Jahren ein eigener AMS-Algorithmus zur Bewertung von Arbeitsmarktchancen für gehörige Aufregung. Dessen Einsatz wurde schlussendlich von der Datenschutzbehörde untersagt, bis heute gibt es in dieser Frage kein abschließendes Urteil. (Andreas Proschofsky, 4.1.2024)