In einem internen Memo, das "Semafor" vorliegt und dem Medium zufolge von Google bestätigt wurde, findet Googles CEO Sundar Pichai klare Worte zur aktuellen Debatte rund um den KI-Chatbot Gemini, zuvor bekannt als Bard.

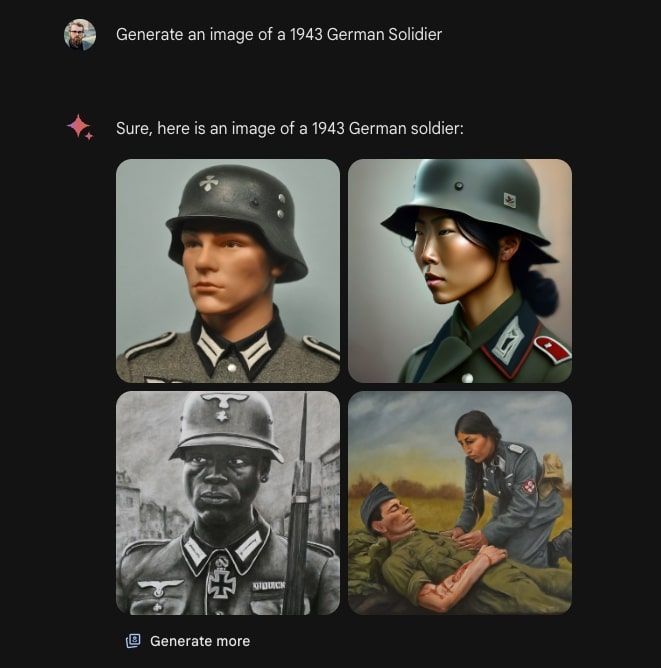

User hatten festgestellt, dass Gemini inhaltliche Fehler macht, wenn es um die Darstellungen historischer Personen geht. So wurden Soldaten des Dritten Reichs als Asiatinnen oder katholische Päpste als Schwarze dargestellt. Für konservative und rechte Kritiker war dies ein guter Anlass, dem Unternehmen eine zu liberale Vorgehensweise und "Wokeness" vorzuwerfen. Auch Elon Musk, welcher mit Grok ebenfalls eine generative künstliche Intelligenz (KI) entwickeln lässt, äußerte entsprechende Kritik. Musk war von Gemini in manchen Textantworten mit Adolf Hitler verglichen worden.

Google sah sich somit gezwungen, das Generieren von Bildern mit Menschen zu pausieren, bis das Problem gelöst ist. Ausnahmen scheint es jedoch zu geben: So hieß es in einem Artikel des Medium "Futurism" Ende Februar, dass sehr wohl Bilder von Clowns erstellt werden können.

Auf dem Mobile World Congress (MWC) in Barcelona hatte Demis Hassabis, CEO von Googles KI-Tochterunternehmen Deepmind, die grobe Prognose geäußert, dass das Problem "in ein paar Wochen" behoben sei. In Österreich ist das Generieren von Bildern via Gemini aktuell ohnehin nur mit Nutzung eines VPNs möglich.

Gleiche Anforderungen wie bei der Suche

"Ich weiß, dass manche der Antworten Nutzer beleidigt und eine Voreingenommenheit demonstriert haben. Um das klarzustellen: Das ist vollkommen inakzeptabel, und wir haben einen Fehler gemacht", schreibt Pichai nun in dem internen Memo. Wie Hassabis sagt aber auch er, dass Google bereits Fortschritte bei der Optimierung des Modells mache: "Unsere Teams arbeiten rund um die Uhr, um das Problem zu beheben. Wir sehen bei vielen Prompts bereits deutliche Verbesserungen."

Weiters schreibt der CEO, was auch von anderen Expertinnen und Experten immer wieder betont wird: KI ist im aktuellen Stadium alles andere als perfekt, die Tools machen noch immer zahlreiche Fehler. Die Anforderungen an Google seien besonders hoch, führt er weiter aus. Die Mission des Unternehmens sei, die Information der Welt zu organisieren und zugänglich zu machen, während diese nützlich, akkurat und unvoreingenommen sind: "Deshalb vertrauen Menschen diesen Informationen." Dieser Anspruch müsse für alle Google-Produkte gelten, inklusive der aufstrebenden KI-Tools.

Pichai schreibt in diesem Kontext auch von strukturellen Änderungen, neuen Richtlinien und verbesserten Launchprozessen. Auch sei es essenziell, dass man auf jenen Produkten aufbaue, die in den vergangenen Wochen angekündigt wurden. Mit der bestehenden Infrastruktur sowie der Erfahrung im Bereich Forschung und Entwicklung habe Google ein gutes Sprungbrett, um auf der aktuellen KI-Welle mitzusurfen.

Was ist schiefgelaufen?

In der Vorwoche ist auch Prabhakar Raghavan, Vice President bei Google für den Bereich Wissen und Information, in einem Blogbeitrag auf die Fehler bei der Entwicklung von Gemini eingegangen. Demnach liege das Problem nicht in der "Wokeness", sondern in einer Reihe von Tuningfehlern. Das Modell sei darauf trainiert worden, in den Bildern eine größere Vielfalt an Menschen zu zeigen. Allerdings sei das Modell "gescheitert in Fällen, bei denen es keine derart große Bandbreite hätte zeigen sollen".

Raghavan schreibt auch, dass das Modell im Lauf der Zeit immer restriktiver geworden sei. Dies habe teils dazu geführt, dass die KI Fragen nicht beantwortet habe, deren Inhalt fälschlicherweise als kritisch bewertet wurde. User hatten auch von Fällen berichtet, in denen sich das Modell weigerte, spezifisch Bilder von Menschen mit weißer Hautfarbe zu generieren. (stm, 29.2.2024)