Zurückgelassene Kinder, die verblutend in den Ruinen einer zerstörten Stadt liegen – diese und andere Bildmotive wurden in den vergangenen Wochen zuhauf in sozialen Netzwerken publiziert, um vermeintlich die Situation im Nahen Osten zu illustrieren. Jedoch handelt es sich in vielen Fällen um Fakes, die immer öfter auch mit KI-Tools wie Midjourney oder Stable Diffusion generiert werden, wie die Nachrichtenagentur AP aktuell berichtet. Erkennbar sind die mit künstlicher Intelligenz erstellten Fälschungen unter anderem an unnatürlichen Hintergründen und Gliedmaßen – allen voran den Händen, zumal die KIs nach wie vor Probleme mit der Darstellung von Fingern haben – sowie an Pupillen mit einem unrealistischen Schimmern.

Das Netz als Wilder Westen

Während die dargestellten Situationen aber gefälscht sind, sind die Empörung und die Polarisierung im Netz real. Millionenfach werden die entsprechenden Beiträge angesehen und von Usern mit dem eigenen Netzwerk geteilt, ohne dass entsprechende Faktenchecks stattfinden. Die Schnelligkeit des digitalen Raums verleitet dazu. Und dass Elon Musk anlässlich der Twitter-Übernahme einen Großteil des Moderationsteams entließ, sorgt gerade auf dem heute als X bekannten Kurznachrichtendienst für einen entsprechenden Wildwuchs.

Nicht hilfreich ist auch der Umbau im Bereich der verifizierten Accounts, womit sich nun jedermann als eine Institution ausgeben kann, solange er dafür bezahlt. So hatte sich etwa ein Account als offizieller Auftritt der "Jerusalem Post" ausgegeben und behauptet, der israelische Premierminister befinde sich im Krankenhaus. Das Posting erreichte 700.000 Menschen, bevor der Account gesperrt wurde.

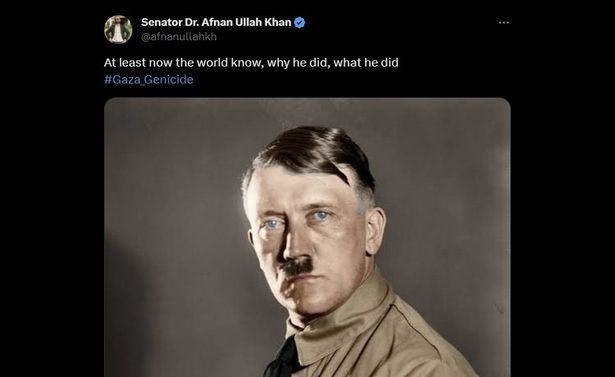

Diese Entwicklung brachte Mitte Oktober auch EU-Kommissar Thierry Breton dazu, Musk in einem offenen Brief mit Verweis auf den Digital Services Act (DSA) an seine Verpflichtung zu erinnern, illegale X-Inhalte zu löschen. Die von Musk eingesetzte CEO Linda Yaccarino bestätigte daraufhin die Löschung hunderter Accounts mit Hamas-Verbindungen und schritt persönlich ein, um ein Posting löschen zu lassen, das Adolf Hitler verherrlichte.

Das Problem dürfte aber umfangreicher sein und neben X auch andere Netzwerke betreffen: Mitte Oktober ergab eine Auswertung der israelischen Analysefirma Cyabra, dass ein Viertel jener Accounts auf Facebook, X, Instagram und Tiktok, die über den Krieg debattieren, Fake-Accounts sind.

Vielfalt der Fakes

Doch nicht nur die Verbreitung der Fälschungen ist ein Problem, sondern auch die vielfältigen Möglichkeiten der Erstellung. So kommt es auch vor, dass Bilder und Videos vorheriger Ereignisse aus dem Kontext gerissen werden, um vermeintlich eine aktuelle Situation zu entlarven. So wurde etwa ein Video geteilt, in dem Palästinenser beschuldigt werden, Verletzungen zu simulieren. In Wahrheit handelt es sich dabei aber um eine Dokumentation aus dem Jahr 2017 über einen Make-up-Künstler, der an palästinensischen Filmproduktionen arbeitete.

In anderen Fällen wurden Szenen aus dem Computerspiel "Arma 3" sowohl im Kontext des Krieges in der Ukraine als auch jenes im Nahen Osten missbraucht, um angeblich Kampfhandlungen zu porträtieren. So wurde von einem Hamas-nahen Account ein Video verbreitet, das angeblich den Abschuss eines israelischen Helikopters zeigt. Hinter dem Spiel steht das tschechische Entwicklerstudio Bohemia Interactive, das selbst in einem Blogpost vor irreführendem Missbrauch des Spielmaterials warnt und betont, selbst solche Videos auf den Plattformen zu melden.

Es wird schlimmer

Vor allem aber – da sind sich alle Expertinnen und Experten einig – wird die einfache Zugänglichkeit von generativen KIs dazu beitragen, dass sich die Problematik von Fake News weiter verschärfen wird. Das gilt für Bilder, aber auch für Videos: So hatte sich schon im März 2022 ein Video verbreitet, in dem Wolodymyr Selenskyj angeblich kapituliert. Für das Fälschen von Stimmen sind wiederum nur wenige Sekunden Originalmaterial notwendig. Es ist davon auszugehen, dass sich entsprechende Fakes auch im Kontext kommender Wahlen verbreiten werden.

Fake-Video zur angeblichen Kapitulation der Ukraine, bereitgestellt von "The Telegraph".

Industrie und Politik sind bemüht, hier gegenzusteuern. So sollen Wasserzeichen in KI-Bildern diese als solche erkennbar machen, diverse Tools großer Anbieter unterbinden das Eingeben von Namen öffentlicher Personen in den Befehlen (Prompts). Das Problem dabei: Wenn auch nur ein einziger Anbieter ausschert, wird eben dessen Software für üble Zwecke missbraucht.

Entsprechend ist auch ein Katz-und-Maus-Spiel zwischen den Erstellern der Fakes und jenen ausgebrochen, die diese zu entlarven versuchen. So hilft ein kostenloses Tool wie Tineye etwa bei der Nachforschung, ob ein Foto zu einem früheren Zeitpunkt bereits in einem anderen Kontext verwendet wurde. Andere Programme wie AI or not sollen wiederum helfen, KI-Fakes als solche zu erkennen. Nicht immer mit Erfolg: So wurden in den ersten Tages des Krieges Fotos als Fälschungen eingestuft, die jedoch echt waren. (Stefan Mey, 30.11.2023)